SeaTunnel 同步 MySQL 到 Doris 的优化策略

在数据仓库建设过程中,数据同步是一个关键环节。SeaTunnel作为一个高性能的分布式数据集成工具,被广泛用于将MySQL数据同步到Doris等OLAP数据库。然而,如何优化这个同步过程,提高效率并减少资源消耗,是每个数据工程师都需要面对的挑战。本文将结合实际配置文件,详细探讨SeaTunnel同步MySQL到Doris的优化策略。

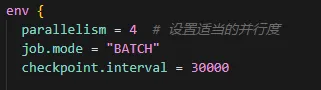

一、环境配置优化

1. 并行度设置

并行度是影响同步性能的关键因素。我在实时数仓数据湖项目中进行了不同的并行度设置:

env {

parallelism = 4 # 全量加载配置

}

env {

parallelism = 8 # CDC模式配置

}优化建议:

- 全量加载:根据表大小和服务器资源调整并行度,大表可适当增加

- CDC模式:考虑源库负载,避免过高并行度导致源库压力过大

- 不同表可设置不同并行度,如订单表可设置较高并行度,而配置表可设置较低并行度

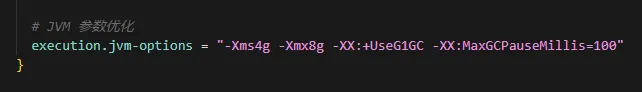

2. JVM参数优化

合理的JVM参数可以提高SeaTunnel的稳定性和性能:

execution.jvm-options = "-Xms4g -Xmx8g -XX:+UseG1GC -XX:MaxGCPauseMillis=100"优化建议:

- 根据服务器内存调整堆大小,通常建议最大堆内存不超过物理内存的70%

- 使用G1垃圾收集器处理大内存场景

- 设置合理的GC暂停时间,平衡吞吐量和延迟

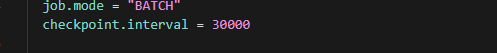

3. 检查点配置

检查点配置影响任务的容错性和恢复能力:

checkpoint.interval = 10000 # CDC模式

checkpoint.interval = 30000 # 全量模式优化建议:

- CDC模式:设置较短的检查点间隔(如10秒),确保数据实时性和故障恢复

- 全量模式:可设置较长的检查点间隔,减少检查点开销

- 配置本地检查点存储路径,加快恢复速度:execution.checkpoint.data-uri = "file:///opt/seatunnel/checkpoints"

二、源端优化

1. 读取限流

避免对源MySQL数据库造成过大压力:

read_limit.bytes_per_second = 10000000 # 每秒读取字节数限制,约10MB/s

read_limit.rows_per_second = 1000 # 每秒读取行数限制优化建议:

- 根据源库负载能力调整限流参数

- 业务低峰期可适当放宽限制,高峰期则收紧限制

- 对于重要业务表,设置更严格的限流策略

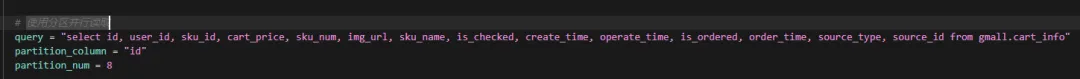

2. 分区并行读取

全量同步时,合理的分区策略可以提高读取效率:

query = "select id, ... from gmall.order_info"

partition_column = "id"

partition_num = 4优化建议:

- 选择均匀分布的字段作为分区列,如自增ID

- 分区数量根据表大小和并行度设置,通常与并行度相同或略高

- 对于特别大的表,可以使用自定义分区SQL,确保每个分区数据量均衡

3. 连接池配置

合理的连接池配置可以提高源端读取效率:

connection_pool {

max_size = 10

min_idle = 3

max_idle_ms = 60000优化建议:

- max_size设置为并行度的1.5-2倍

- 保持适当的min_idle连接数,减少连接创建开销

- 根据业务特点调整max_idle_ms,避免频繁创建销毁连接

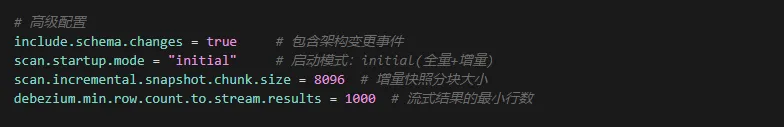

4. CDC特有配置

对于CDC模式,有一些特殊的优化参数:

snapshot.mode = "initial"

snapshot.fetch.size = 10000

chunk.size.rows = 8096优化建议:

- 对于首次同步,使用initial模式;对于增量同步,可使用latest模式

- 调整snapshot.fetch.size以平衡内存使用和网络开销

- 设置合理的chunk.size.rows,大表可适当增加以提高并行效率

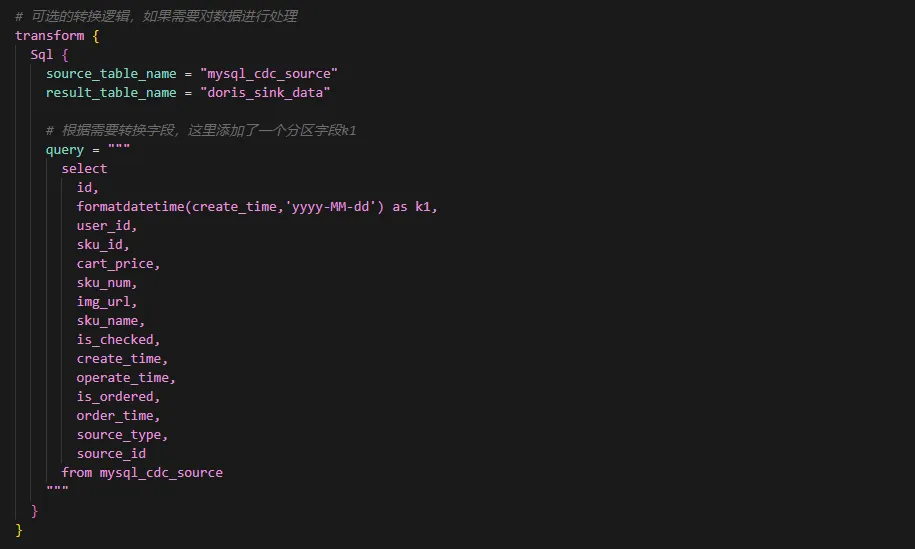

三、转换优化

1. SQL转换优化

合理的SQL转换可以减少数据处理开销:

transform {

Sql {

query = """

select

id,

date(create_time) as k1, # 使用date函数确保k1是DATE类型

...其他字段...

from mysql_seatunnel

"""

}

}优化建议:

- 只选择必要的字段,减少数据传输量

- 在源端进行数据类型转换,减轻Doris负担

- 使用适当的函数处理日期时间字段,确保与目标表类型匹配

- 对于复杂转换,考虑使用多个转换步骤,提高可维护性

2. 分区字段处理

合理的分区字段处理可以提高Doris的查询效率:

formatdatetime(create_time,'yyyy-MM-dd') as k1 # 使用date函数确保k1是DATE类型优化建议:

- 确保分区字段类型与Doris表定义一致,避免类型转换错误

- 对于时间分区,使用date函数提取日期部分,而不是使用字符串格式化

- 考虑业务查询模式,选择合适的分区粒度(日、月、年)

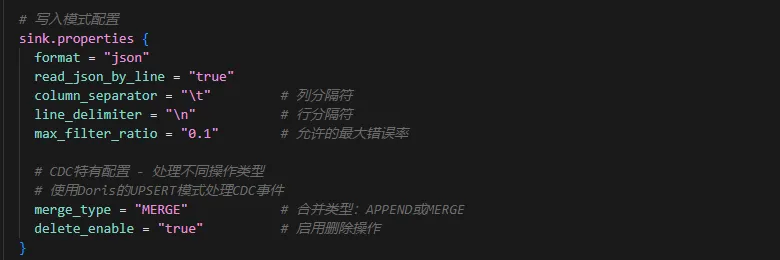

四、目标端优化

1. 写入模式配置

合理的写入模式配置可以提高Doris的导入效率:

sink.properties {

format = "json"

read_json_by_line = "true"

max_filter_ratio = "1.0"

merge_type = "MERGE"

delete_enable = "true"

}优化建议:

- 使用JSON格式,简化数据处理

- 根据数据质量调整max_filter_ratio,开发环境可设置较高值

- 对于CDC场景,使用MERGE模式并启用delete_enable

- 全量加载可考虑使用APPEND模式,提高写入性能

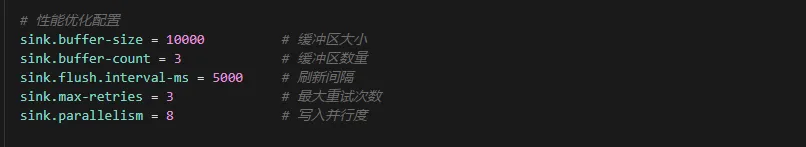

2. 缓冲区配置

合理的缓冲区配置可以平衡内存使用和写入效率:

sink.buffer-size = 5000

sink.buffer-count = 3

sink.flush.interval-ms = 5000优化建议:

- 大表可适当增加buffer-size,提高批量写入效率

- buffer-count通常设置为3-5,避免过多内存占用

- 调整flush.interval-ms,平衡实时性和写入效率

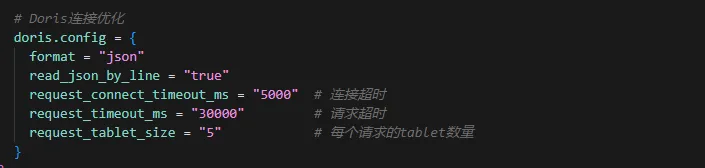

3. Doris连接优化

优化Doris连接参数可以提高写入性能:

doris.config = {

request_connect_timeout_ms = "10000"

request_timeout_ms = "60000"

request_tablet_size = "2"

}优化建议:

- 增加超时时间,避免网络波动导致的失败

- 减少request_tablet_size,避免单个请求过大

- 根据网络环境调整连接参数,云环境可能需要更长的超时时间

本文地址:https://www.yitenyun.com/123.html

下一篇:基于数据库锁实现防重复提交