Llama-Factory能否运行在ARM架构服务器上?树莓派可行吗?

Llama-Factory能否运行在ARM架构服务器上?树莓派可行吗?

在AI模型日益普及的今天,越来越多开发者希望将大语言模型(LLM)微调任务下沉到低成本、低功耗的边缘设备上。树莓派这类嵌入式平台因其价格亲民、部署灵活,成为不少极客和教育场景下的首选。于是,“Llama-Factory能不能跑在树莓派上?ARM架构支持吗?”就成了一个既现实又充满挑战的问题。

答案并不简单:从纯技术角度看,是的,它可以启动;但从工程实践出发,训练几乎不可行。真正能落地的,其实是“用树莓派做控制台,让远程GPU干活”这种混合模式。

为什么我们关心ARM上的Llama-Factory?

Llama-Factory 的核心价值在于“开箱即用”的微调体验——它把 Hugging Face Transformers、PEFT、Accelerate 和 Gradio 整合成一套可视化流水线,让用户点几下就能完成 LoRA 或 QLoRA 微调。这对企业快速构建领域模型非常友好。

但它的底层依赖也很明确:Python + PyTorch + CUDA + 各类原生扩展库(如 bitsandbytes, flash-attn)。这些组件大多为 x86_64 架构优化,尤其是 NVIDIA GPU 生态,几乎与 ARM 绝缘。

而 ARM 平台的问题更复杂。以树莓派为例:

- CPU 是 Cortex-A76,浮点性能有限;

- 内存共享 GPU/CPU,带宽瓶颈明显;

- 没有独立显卡,无法使用 CUDA;

- 多数 AI 库没有预编译的 aarch64 wheel 包。

这意味着,哪怕你成功安装了 Llama-Factory,也可能卡在第一个 import torch 上。

能不能装?试试就知道

假设你在一台树莓派 5(64位 Debian 系统,4GB RAM)上尝试部署:

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -r requirements.txt

大概率会在这里失败——最常见的报错来自 bitsandbytes 和 sentencepiece。

bitsandbytes:QLoRA的关键,却最难装

这个库用于 4-bit 量化训练,是 QLoRA 实现低显存微调的核心。但它包含大量 CUDA 内核代码,官方只提供 x86_64-linux 的 wheel。在 ARM 上 pip install bitsandbytes 会尝试从源码编译,结果往往是:

error: no matching function for call to 'cublasSgemmEx'

因为根本没有 ARM 版本的 cublas 支持。

解决思路:

- 直接移除该依赖(修改 requirements.txt),牺牲 QLoRA 功能;

- 使用社区维护的非官方包(如某些 Jetson 镜像中的 torch-bnbs);

- 或改用 CPU-only 的替代方案,比如 torchao(仍在实验阶段)。

sentencepiece:分词器的基础,也常出问题

虽然理论上支持 ARM,但很多用户反馈在树莓派上 pip install sentencepiece 会因 C++ 编译器版本不兼容而失败。

建议做法:

sudo apt install python3-sentencepiece

优先使用系统包管理器安装,避免源码编译。

PyTorch 怎么办?

官方 PyTorch 不提供 ARM Linux 的预编译包。你可以尝试:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu

这能装上 CPU 版本的 PyTorch,但性能堪忧——ResNet50 推理都要好几秒,更别说训练 Transformer 了。

如果你用的是 NVIDIA Jetson(ARM + NVIDIA GPU),情况稍好:NVIDIA 提供了定制版 torch-jetson,支持 CUDA 加速。但树莓派无此待遇。

WebUI 可以跑,但别指望训练

好消息是:Gradio 构建的 WebUI 可以在树莓派上正常启动。

from llamafactory.api import create_ui

demo = create_ui()

demo.launch(server_name="0.0.0.0", port=7860)

这段代码只需要基础 Python 环境和少量前端依赖,完全可以在 ARM 上运行。你能看到界面、上传数据、选择模型、配置参数……一切看起来都很完美。

但一旦点击“开始训练”,系统就会试图加载模型权重、初始化优化器、执行前向传播——这时你会发现:

- 加载 1.8B 模型需要几分钟;

- batch_size=1 的单步训练耗时超过 30 秒;

- 几分钟后内存耗尽,进程被 OOM Killer 杀掉。

根本原因在于:PyTorch 在 ARM CPU 上运行 Transformer 的效率太低,且缺乏算子融合、自动调度等现代加速机制。

那到底有没有可行路径?

当然有,关键是要重新定义“运行”的含义。

场景一:本地WebUI + 远程训练(推荐)

这是最实用的方案:在树莓派上运行 WebUI,作为“遥控器”,实际训练发生在云端或本地高性能主机上。

实现方式有两种:

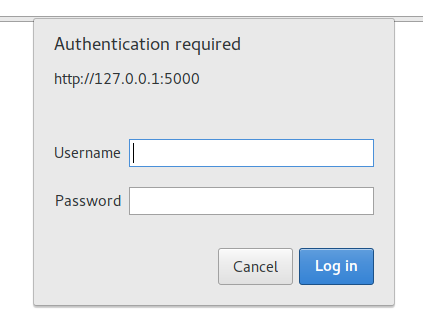

方式1:SSH隧道反向代理

# 在远程x86+GPU机器上启动Llama-Factory服务

python src/webui.py --host 127.0.0.1 --port 7860

# 从树莓派建立SSH隧道

ssh -L 7860:localhost:7860 user@remote-gpu-server

然后在树莓派浏览器访问 http://localhost:7860,就像本地运行一样流畅。

方式2:API代理 + 轻量前端

将训练任务封装成 REST API,树莓派只保留一个简化版 UI,负责提交任务和查看日志。这更适合嵌入产品原型。

这种架构其实很常见——就像你用手机 App 控制家里的NAS,真正的计算不在手机上。

场景二:仅做推理部署(务实之选)

与其勉强训练,不如专注推理。

流程如下:

1. 在 x86 + GPU 环境中使用 Llama-Factory 完成 QLoRA 微调;

2. 导出合并后的模型(Hugging Face 格式);

3. 使用 llama.cpp 或 MLC LLM 转换为 GGUF 或 MLC 格式;

4. 部署到树莓派运行轻量推理。

例如,在树莓派上运行 Phi-2 或 TinyLlama 的 INT4 量化版本,响应延迟可控制在 1~2 秒内,足以应付简单的对话助手、指令解析等任务。

# 使用llama.cpp运行量化模型

./main -m models/phixtral-2b-Q4_K_M.gguf -p "请写一首关于春天的诗"

这种方式充分发挥了 ARM 设备“低功耗+常驻运行”的优势,避开其算力短板。

场景三:教学演示 & 流程理解(教育价值高)

即使不做真实训练,Llama-Factory 的 WebUI 对教学仍有巨大价值。学生可以通过图形界面直观理解:

- 数据格式如何组织(Alpaca vs ShareGPT)

- LoRA 的 rank、alpha 参数意义

- 训练过程中的 loss 曲线变化

- 模型评估指标的作用

就像用模拟器学开车,虽不能上高速,但能掌握基本操作逻辑。

ARM平台的未来:希望在远方

目前 ARM 上跑不动 Llama-Factory 的根本原因不是“不行”,而是“生态未就绪”。

不过趋势正在改变:

Apple Silicon 的带动效应

MacBook Pro 上的 M1/M2 芯片证明了 ARM 架构也能胜任 AI 开发。pytorch-metal 已支持在 macOS 上利用 GPU 加速训练,甚至能在 Mac Mini 上微调 7B 模型。

如果这套生态能向 Linux ARM 扩展(比如通过 Vulkan Compute 或 OpenCL),未来或许会出现“ARM 原生训练栈”。

边缘智能的新范式

MLC LLM、TinyGrad、liteLLM 等项目正在探索“无需 CUDA”的轻量化训练框架。它们不依赖传统深度学习库,更适合资源受限环境。

设想一下:未来某天,我们能在树莓派上对一个小模型进行 few-step online fine-tuning,实现个性化适配——这比“全量训练”更有意义。

最终结论:分工协作才是正解

回到最初的问题:

Llama-Factory 能否运行在 ARM 架构服务器上?树莓派可行吗?

答案是:

✅ 可以运行 WebUI 层 —— 作为远程训练系统的操作面板,体验良好。

❌ 无法有效执行本地训练 —— 即使是最小的 1.8B 模型,也会因内存不足和算力低下而崩溃。

💡 最佳实践是“云训边控” —— 利用 Llama-Factory 在高性能环境完成微调,再将轻量化模型部署至 ARM 设备推理。

这也揭示了一个更深层的趋势:未来的 AI 架构不是“在哪跑”,而是“怎么协同”。中心节点负责重载训练,边缘节点专注低延迟响应,中间靠统一接口连接。

Llama-Factory 当前的设计哲学仍是“集中式训练中心”,但它的模块化结构为未来演化留下了空间。也许下一版本,我们会看到内置 MLC 后端、支持 ONNX Runtime 推理、甚至集成 WebNN 的轻量模式。

到那时,树莓派不仅能“看”训练,还能真正参与其中——哪怕只是微调一层偏置项,也是属于边缘智能的一小步。

本文地址:https://www.yitenyun.com/3137.html