深入理解Transformer Debugger架构:激活服务器与前端可视化

深入理解Transformer Debugger架构:激活服务器与前端可视化

【免费下载链接】transformer-debugger

Transformer Debugger是一个专门用于分析和调试Transformer神经网络的开源工具。通过激活服务器和前端可视化组件的协同工作,它能够深入探索模型内部的神经元激活模式、注意力机制和特征表示,为研究人员和开发者提供直观的神经网络调试体验。🚀

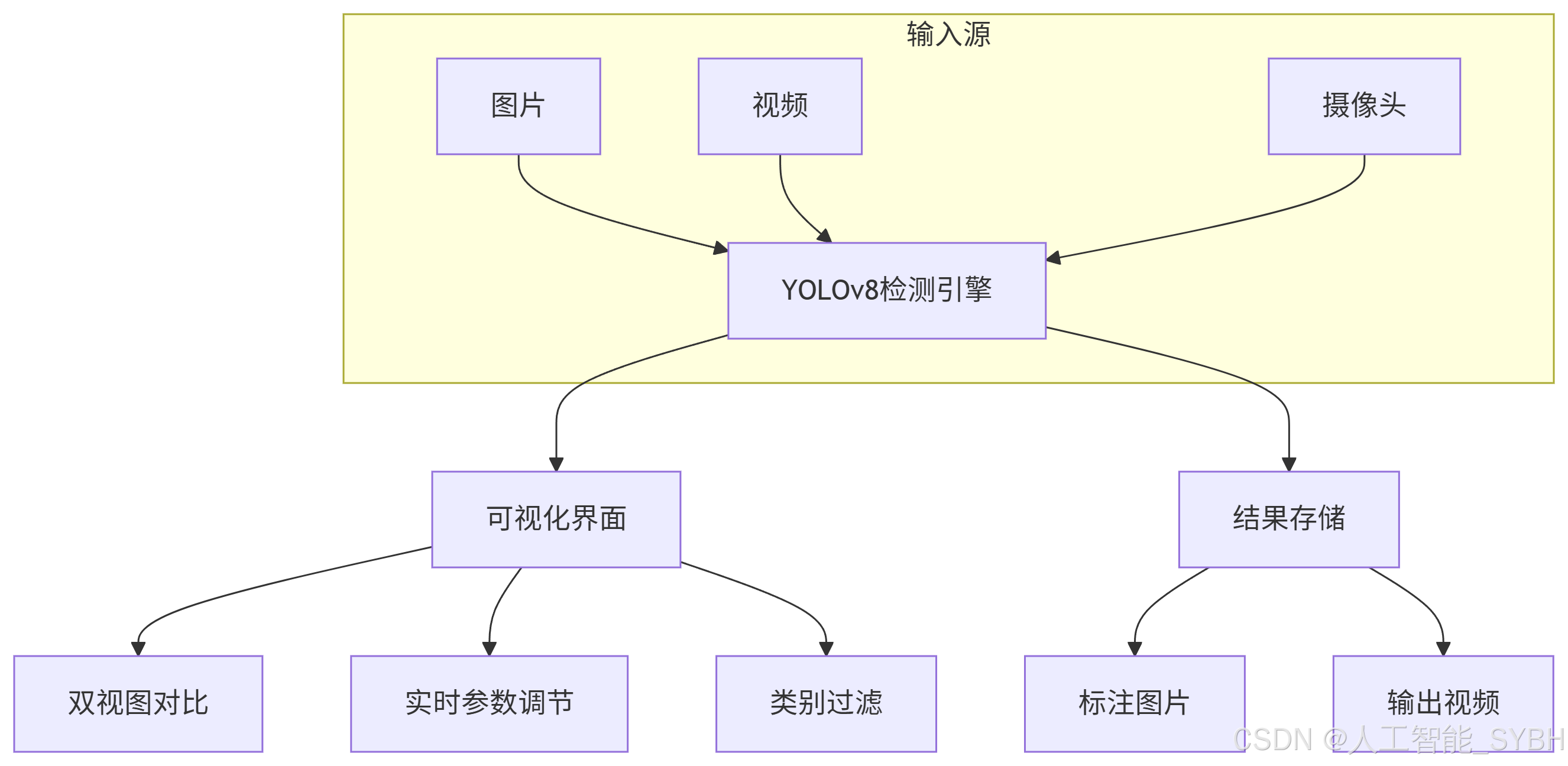

核心架构概览

Transformer Debugger采用前后端分离架构,主要由激活服务器和后端数据处理模块构成。激活服务器负责处理神经网络的前向传播和反向传播计算,同时收集各个层级的激活数据。前端可视化界面则通过丰富的图表和交互组件,将这些复杂的内部状态以直观的方式呈现给用户。

激活服务器深度解析

激活服务器是Transformer Debugger的核心组件,位于neuron_explainer/activation_server/目录。它通过多个关键模块协同工作:

派生标量计算引擎

derived_scalar_computation.py模块负责从原始激活数据中提取有意义的派生标量。这些标量包括注意力权重、MLP激活值、残差连接贡献度等关键指标。

推理路由系统

inference_routes.py定义了模型的推理接口,支持批量请求处理和实时计算。通过精心设计的API端点,用户可以灵活地控制模型的推理过程。

交互式模型管理

interactive_model.py实现了模型的动态加载和配置,支持多种Transformer架构的调试需求。

前端可视化架构

前端界面位于neuron_viewer/目录,采用React+TypeScript技术栈构建。通过模块化设计,实现了高度可扩展的可视化组件库。

核心可视化组件

TransformerDebugger主组件:TransformerDebugger.tsx作为整个应用的入口,协调各个子组件的渲染和交互。

卡片系统架构:

- 推理参数卡片:inference_params/管理模型推理的各种配置

- 节点表格组件:node_table/展示神经元激活状态

- 提示处理模块:prompt/处理用户输入和token管理

数据获取与处理

requests/目录下的服务模块负责与后端API通信,确保数据的实时更新和准确显示。

关键技术特性

实时激活监控

系统能够实时捕获和显示神经网络在处理输入序列时各个神经元的激活状态。通过activationsForPrompt.tsx等面板组件,用户可以直观地观察到模型内部的信息流动。

注意力机制可视化

attention_utils.py提供了丰富的注意力矩阵分析工具,帮助用户理解模型如何分配注意力资源。

多层特征分析

通过LayerDisplay.tsx组件,系统支持对Transformer各个层级的特征表示进行对比分析。

使用场景与优势

模型调试优化

开发者可以通过Transformer Debugger快速定位模型中的问题区域,比如识别出对特定任务贡献度较低的注意力头或MLP神经元。

可解释性研究

研究人员能够深入探索模型的决策过程,理解不同神经元在语言理解、推理等任务中的具体作用。

教学与演示

工具的可视化界面使得复杂的神经网络内部工作机制变得直观易懂,非常适合用于教学和学术交流。

总结

Transformer Debugger通过其精心的架构设计,成功地将复杂的神经网络内部状态转化为易于理解的视觉信息。无论是进行模型优化、可解释性研究还是教学演示,这个工具都能提供强大的支持。🎯

通过激活服务器的高效计算和前端界面的丰富展示,Transformer Debugger为Transformer模型的深度理解和优化开辟了新的可能性。

【免费下载链接】transformer-debugger