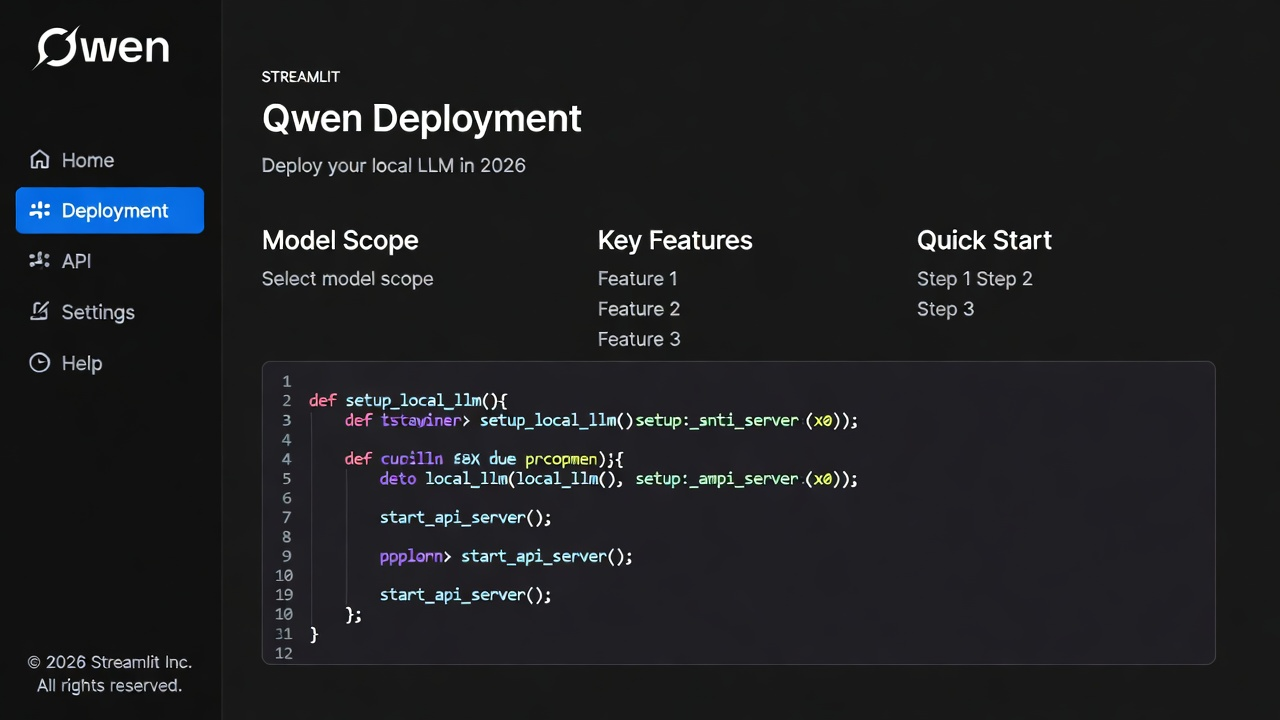

SSH连接超时问题解决方案:Miniconda服务器

构建稳定高效的远程AI开发环境:Miniconda与SSH深度实践

在人工智能项目日益复杂的今天,开发者早已习惯将模型训练、数据处理等重负载任务部署在远程服务器上。然而,一个看似不起眼的问题却频繁打断工作流——SSH连接突然断开,正在运行的Jupyter Notebook会话丢失,长时间训练的任务戛然而止。这种“功亏一篑”的体验几乎每个远程开发者都曾遭遇。

更令人头疼的是,这类中断往往发生在深夜或无人值守时,等到第二天才发现日志文件不完整、检查点未保存。问题的根源并不总是网络本身,而更多是SSH协议默认行为与现代开发需求之间的错配。幸运的是,结合合理的工具链配置和系统调优,这一顽疾完全可以被根治。

关键在于两方面的协同优化:一是使用Miniconda-Python3.11构建高度一致且可复现的开发环境;二是通过精细化调整SSH保活机制,确保连接持久稳定。这两者共同构成了现代AI工程实践中不可或缺的基础能力。

Miniconda:为远程开发打造纯净可靠的Python环境

当团队成员各自使用不同版本的NumPy、PyTorch甚至Python解释器时,“在我机器上能跑”就成了最常听到的无奈辩解。Miniconda的出现正是为了终结这种混乱局面。

作为Anaconda的精简版,Miniconda只包含核心组件——Conda包管理器和Python解释器,初始安装包不足100MB,非常适合快速部署到云服务器。相比完整的Anaconda发行版,它避免了预装大量用不到的库所带来的资源浪费,同时保留了强大的依赖解析能力。

其真正的威力体现在虚拟环境隔离机制上。通过conda create命令可以轻松创建独立环境:

conda create -n pytorch_env python=3.11

conda activate pytorch_env

pip install torch torchvision

每个环境都有自己的包目录和Python解释器副本,彻底杜绝了项目间的依赖冲突。更重要的是,Conda不仅能管理纯Python包,还能处理像CUDA、MKL这样的二进制依赖,这对于深度学习框架的支持至关重要。

这一点远超传统的pip + venv组合。后者虽然轻量,但在面对需要编译的C/C++扩展时常常束手无策,尤其是在没有root权限的受限环境中。而Conda提供的预编译包直接解决了这一痛点。

为了实现团队协作中的环境一致性,推荐使用YAML文件定义依赖规范:

name: ai-research-env

channels:

- defaults

- conda-forge

dependencies:

- python=3.11

- numpy

- pandas

- jupyter

- pip

- pip:

- torch==2.1.0

- torchvision

- transformers

只需一条命令即可还原整个环境:

conda env create -f environment.yml

这不仅提升了部署效率,也为实验结果的可复现性提供了坚实保障。在科研论文评审中,审稿人能够基于同一份环境配置验证你的代码,极大增强了工作的可信度。

SSH连接为何总在关键时刻掉线?

表面上看,SSH断开像是网络波动所致,实则多数情况是由中间设备的空闲连接清理策略引发。无论是企业防火墙、NAT路由器还是云服务商的负载均衡器,通常都会对“静默”连接进行回收,以释放资源。

SSH协议本身并未强制要求持续通信,因此当终端长时间没有输入输出(比如你去开会了),这条连接就会被判定为空闲状态,最终被切断。此时即使本地网络恢复,远端进程也已终止。

OpenSSH为此提供了两套互补的心跳机制:

- 服务端探测(

ClientAliveInterval):由服务器主动向客户端发送存活请求; - 客户端探测(

ServerAliveInterval):由客户端定期向服务器发送保活包。

两者配合使用,形成双向保活,能有效穿透大多数中间网络设备的超时限制。

服务端配置:让服务器主动“唤醒”连接

编辑 /etc/ssh/sshd_config 文件,添加以下设置:

# 每60秒检查一次客户端是否存活

ClientAliveInterval 60

# 允许连续3次未响应后断开

ClientAliveCountMax 3

# 启用TCP层保活(底层网络支持)

TCPKeepAlive yes

# 登录等待时间(防止暴力破解)

LoginGraceTime 120

修改完成后需重启SSH服务:

sudo systemctl restart sshd

这样配置后,若客户端连续3分钟无响应(60秒×3次),连接才会被关闭。既避免了僵尸会话占用资源,又能容忍短暂的网络抖动。

客户端配置:从本地发起连接守护

在本地用户的 ~/.ssh/config 中加入主机别名配置:

Host my-miniconda-server

HostName 192.168.1.100

User developer

Port 22

ServerAliveInterval 60

ServerAliveCountMax 3

TCPKeepAlive yes

IdentityFile ~/.ssh/id_rsa

现在只需执行:

ssh my-miniconda-server

即可自动应用所有优化参数。其中ServerAliveInterval 60意味着每分钟发送一次NOP包,维持连接活跃状态。

值得注意的是,过于频繁的探测(如每10秒一次)可能增加不必要的网络流量,尤其在移动网络环境下影响明显;而间隔过长(如5分钟以上)则无法及时感知断网。60秒是一个经过广泛验证的平衡点。

实战工作流:构建抗中断的远程开发链路

理想的工作模式应具备三个特征:连接稳定、会话持久、环境可控。下面是一个典型的高效流程。

第一步:建立安全连接

优先采用SSH密钥认证替代密码登录。在服务端禁用密码验证:

# /etc/ssh/sshd_config

PasswordAuthentication no

PubkeyAuthentication yes

然后将公钥上传至~/.ssh/authorized_keys。此举不仅能防止暴力破解,还可实现免交互登录,便于脚本自动化。

第二步:启动持久化会话

直接运行训练脚本存在风险,一旦SSH断开进程即终止。正确做法是使用tmux或screen创建后台会话:

tmux new -s training_session

python train_model.py > logs/training_$(date +%F).log 2>&1

按 Ctrl+B 再按 D 即可脱离当前会话,程序仍在后台运行。后续可通过 tmux attach -t training_session 重新接入查看输出。

对于无需交互的日志型任务,也可使用nohup:

nohup python data_preprocess.py > preprocess.log 2>&1 &

这种方式简单直接,适合一次性批处理作业。

第三步:安全访问Jupyter服务

许多开发者习惯在服务器启动Jupyter并直接暴露端口,但这存在严重安全隐患。正确的做法是通过SSH隧道进行端口转发:

# 本地执行

ssh -L 8888:localhost:8888 developer@192.168.1.100

随后在浏览器打开 http://localhost:8888,所有流量均经加密通道传输。即使Jupyter未设置密码,外部也无法直接访问该端口。

建议搭配--ip=0.0.0.0 --no-browser参数启动:

jupyter notebook --ip=0.0.0.0 --port=8888 --no-browser --NotebookApp.token=''

注意关闭token验证仅适用于可信内网环境,公网部署务必启用身份认证。

第四步:环境备份与灾备恢复

定期导出当前环境快照:

conda env export > environment-prod.yml

这份文件应纳入版本控制系统(如Git),并与代码一同提交。当需要重建环境或迁移服务器时,只需:

conda env create -f environment-prod.yml

即可获得完全一致的运行时环境,极大简化了运维复杂度。

设计权衡与最佳实践

在实际部署中,有几个关键细节值得特别关注:

权限最小化原则

为不同用户分配独立系统账户,并限制其shell权限。例如,仅允许执行特定命令的数据分析人员可使用受限shell(rssh或scponly)。避免所有人共用root或高权限账号,降低误操作风险。

日志与监控不可忽视

即使是稳定的连接也可能因系统重启、内存溢出等原因中断。建议将重要任务的标准输出重定向至日志文件,并配置简单的监控脚本检测进程存活状态:

# 检查训练进程是否存在

if ! pgrep -f "train_model.py" > /dev/null; then

echo "Training process died at $(date)" | mail admin@company.com

fi

避免过度依赖单一工具

尽管SSH+Miniconda组合极为强大,但对于超长期任务(如数周训练),仍建议结合分布式训练框架(如PyTorch DDP、Horovod)和容错机制(检查点自动保存)。不要把所有希望寄托于一条永不中断的连接。

这套融合了环境管理与连接优化的技术方案,已在多个高校实验室和初创企业中验证有效。它不仅解决了“连接断开、前功尽弃”的痛点,更建立起一套标准化、可复制的远程开发范式。掌握这些技能,意味着你可以安心地让模型整夜训练,而不必担心清晨醒来面对一个崩溃的终端。

未来,随着边缘计算和混合云架构的发展,这种“本地控制+远程执行”的模式只会越来越普遍。而今天的每一次SSH配置调整、每一个environment.yml文件的编写,都是在为更智能、更可靠的开发基础设施添砖加瓦。