解放LLM潜能:code2prompt MCP服务器本地配置全攻略

解放LLM潜能:code2prompt MCP服务器本地配置全攻略

【免费下载链接】code2prompt A CLI tool to convert your codebase into a single LLM prompt with source tree, prompt templating, and token counting.

还在为每次向AI助手解释代码库结构而烦恼?code2prompt MCP(Model Context Protocol)服务器模式让你彻底告别手动整理代码的繁琐过程!

通过本文,你将掌握:

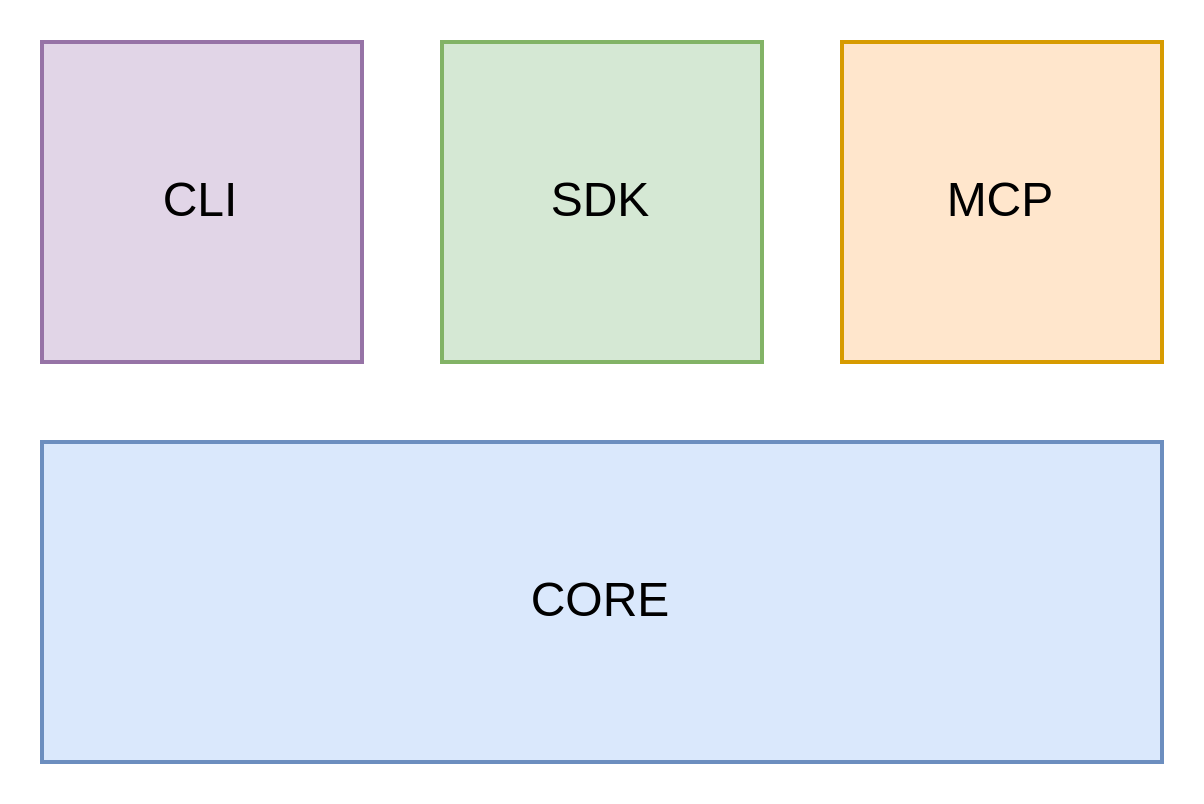

- MCP服务器核心价值与工作原理

- 完整安装配置流程(含详细步骤)

- 主流AI助手集成配置方法

- 实战用例与最佳实践技巧

MCP服务器:本地服务的智能桥梁

MCP服务器模式将code2prompt转换为本地服务,让AI助手(如Claude Desktop、Cursor、Roo Code等)能够实时获取代码库结构化信息。它基于高性能Rust库code2prompt-rs构建,自动生成优化后的AI可读上下文。

环境准备与安装部署

前置依赖检查

确保系统中已安装:

- Git版本管理工具

- Rye Python包管理器(

curl -sSf https://rye.astral.sh/get | bash)

分步安装指南

- 克隆MCP服务器仓库

git clone https://gitcode.com/GitHub_Trending/co/code2prompt-mcp.git

cd code2prompt-mcp

- 依赖安装与虚拟环境配置

rye sync # 自动创建.venv虚拟环境并安装依赖

- 启动MCP服务器

source .venv/bin/activate

python -m src/code2prompt_mcp/main.py

AI助手集成配置

Cline配置示例

编辑AI助手配置文件,添加MCP服务器设置:

{

"mcpServers": {

"code2prompt": {

"command": "bash",

"args": [

"-c",

"cd /path/to/code2prompt-mcp && rye run python /path/to/code2prompt-mcp/src/code2prompt_mcp/main.py"

],

"env": {}

}

}

}

通用配置要点

- 路径适配:确保command中的路径与实际安装位置一致

- 环境变量:可根据需要配置特定环境变量

- 权限设置:保证AI助手有权限执行MCP服务器

实战应用场景

代码库智能分析

直接向AI助手请求:"请使用Code2Prompt MCP分析/path/to/project项目的代码上下文"

精准文件过滤

指定文件类型:"获取所有Python文件,排除markdown文件和tests目录,使用Code2Prompt MCP提供上下文"

项目对比诊断

比较不同分支或版本的代码差异,为AI提供结构化对比数据

验证与故障排查

安装验证步骤

- 重启AI助手应用程序

- 测试连接:请求分析简单项目路径

- 检查日志输出确认服务正常运行

常见问题解决

- 权限拒绝:检查执行权限和路径权限

- 依赖缺失:重新运行

rye sync确保依赖完整 - 端口冲突:检查默认端口是否被占用

性能优化建议

- 虚拟环境优化:使用rye管理的虚拟环境确保依赖隔离

- 路径缓存:对常用项目路径启用缓存加速

- 模板定制:根据项目类型选择合适模板

扩展与自定义

自定义模板集成

MCP服务器支持自定义Handlebar模板,可在模板目录基础上扩展

多语言支持

通过配置支持不同编程语言的特定处理规则

安全注意事项

- 本地服务模式确保代码不会离开本地环境

- 权限控制:仅允许授信AI助手连接

- 网络隔离:建议在内网环境中使用

现在,你的AI助手已经装备了代码库理解超能力!立即配置code2prompt MCP服务器,体验智能编程的新境界。

提示:记得star项目支持开发,遇到问题可查看详细文档或加入社区讨论!

【免费下载链接】code2prompt A CLI tool to convert your codebase into a single LLM prompt with source tree, prompt templating, and token counting.