OPC DA服务器与客户端开发实战指南及核心章节源码解析

本文还有配套的精品资源,点击获取

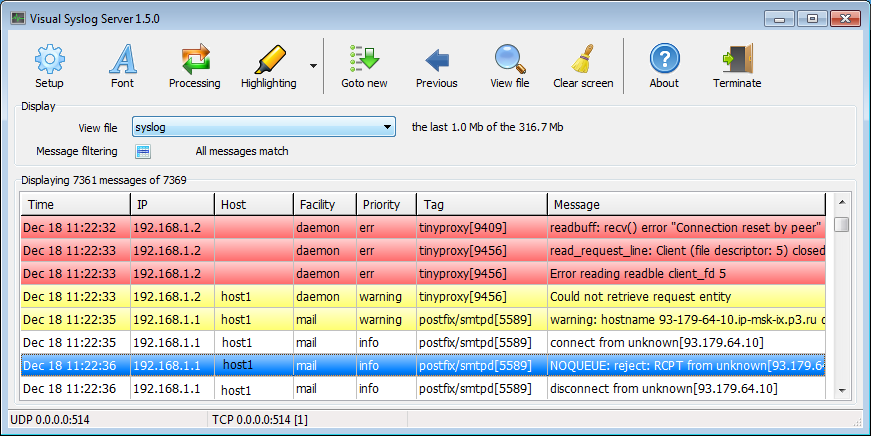

简介:OPC DA是工业自动化领域中基于COM技术的标准数据访问接口,广泛应用于制造业、新能源和物联网等场景。本资源包含一本系统讲解OPC DA服务器与客户程序开发的指南书籍,以及第二章、第三章和第四章的配套源码,涵盖OPC DA架构、服务器与客户端开发核心技术。通过理论学习与代码实践,开发者可掌握OPC DA组件设计、数据读写、订阅机制、事件处理及性能优化等关键技能,为构建高效、互操作的自动化系统奠定基础。

1. OPC DA基础知识与工业应用概述

OPC DA(OLE for Process Control - Data Access)是基于微软COM/DCOM技术构建的工业通信标准,旨在实现控制系统与现场设备间的高效、可靠数据交换。其核心价值在于打破厂商壁垒,通过统一接口规范实现PLC、DCS、SCADA等系统的互操作。相较于传统硬接线或专用协议,OPC DA以“软总线”形式大幅提升了系统集成灵活性,并降低开发与维护成本。广泛应用于智能制造、能源监控与过程控制领域,为上位系统如MES提供实时数据支撑,成为现代工业自动化架构的关键组成部分。

2. OPC DA基于COM/DCOM的技术架构解析

OPC DA(OLE for Process Control - Data Access)作为工业自动化领域中实现设备与系统间数据交互的核心通信标准,其底层技术依赖于微软的组件对象模型(COM)以及分布式组件对象模型(DCOM)。这种基于Windows平台的软件架构不仅赋予了OPC DA强大的跨进程、跨机器通信能力,也使其在系统集成灵活性和可扩展性方面表现出显著优势。深入理解COM/DCOM机制是掌握OPC DA运行原理的前提。本章将从COM的基本构成出发,逐步剖析其接口设计哲学、对象生命周期管理、远程调用机制,并延伸至OPC DA特有的接口体系结构与运行时行为模拟方法。通过结合代码示例、流程图与调试工具的应用,全面揭示OPC DA如何在复杂工业网络环境中稳定传输实时数据。

2.1 COM组件模型的核心机制

COM(Component Object Model)是微软提出的一种二进制接口标准,旨在实现语言无关、位置透明的对象复用与互操作。它不依赖于特定编程语言或开发框架,而是定义了一套严格的接口规范和对象交互协议。在OPC DA体系中,所有服务器功能模块均以COM组件形式存在,客户端通过标准接口调用获取数据服务。理解COM的核心机制,尤其是接口抽象、引用计数与唯一标识机制,是构建高效、稳定的OPC应用程序的基础。

2.1.1 接口、类与对象的关系解析

COM中的“类”并非传统面向对象语言中的概念,而是一个逻辑上的组件实现单元,称为“COM类”或“coclass”。每个coclass实现了若干接口(interface),这些接口是一组函数指针的集合,定义了对象对外暴露的行为契约。接口本身是抽象的,不包含实现,仅规定方法签名和语义。对象则是coclass的一个实例化结果,由客户端通过COM库创建并持有其接口指针进行操作。

一个典型的COM对象可以实现多个接口,例如一个OPC服务器可能同时实现 IOPCServer 、 IConnectionPointContainer 等接口,分别用于提供数据访问、事件通知等功能。这种多接口设计使得同一对象能够支持多种角色和服务类型,提升了系统的模块化程度。

以下为一个简化的COM类定义示例(使用C++ IDL描述):

[

uuid(12345678-1234-1234-1234-123456789012),

helpstring("OPC Server Class")

]

coclass OPCServer {

[default] interface IOPCServer;

interface IConnectionPointContainer;

};

代码逻辑逐行解读分析:

- 第1行:

uuid(...)指定了该coclass的唯一标识符(CLSID),这是注册表中查找组件的关键。 - 第2行:

helpstring提供人类可读的说明信息,便于调试与文档生成。 - 第3~5行:声明该类实现两个接口,其中

[default]表示默认接口,在调用QueryInterface时优先返回。

COM采用“接口隔离”原则,即对象的所有功能必须通过接口访问,禁止直接访问内部数据成员。这保证了封装性和版本兼容性——即使内部实现变更,只要接口不变,客户端无需重新编译即可继续使用。

此外,COM支持聚合(aggregation)和委托(delegation)机制,允许一个对象将其部分功能委派给另一个对象实现,从而提高代码复用率。例如,一个自定义OPC服务器可通过聚合现有日志组件来实现错误记录功能,而不必自行编写全部逻辑。

| 特性 | 描述 |

|---|---|

| 接口(Interface) | 抽象行为集合,定义方法签名,继承自IUnknown |

| 类(coclass) | 实现接口的具体组件,具有唯一CLSID |

| 对象(Object) | coclass的运行时实例,通过接口指针访问 |

| 多接口支持 | 单个对象可实现多个接口,提升功能多样性 |

该机制的优势在于解耦性强,不同厂商可独立开发符合OPC DA规范的接口实现,只要遵循相同的IID(接口ID),即可被通用客户端识别和调用。

classDiagram

class IUnknown {

<>

+QueryInterface(IID, void**) int

+AddRef() uint32

+Release() uint32

}

class IOPCServer {

<>

+AddGroup(...)

+GetStatus(...)

}

class OPCServerImpl {

-m_refCount : uint32

-m_groups : vector

}

IUnknown <|-- IOPCServer

OPCServerImpl ..|> IOPCServer : implements

OPCServerImpl ..|> IUnknown : implements

如上所示, OPCServerImpl 作为具体类实现了 IOPCServer 接口,并间接继承自 IUnknown 。所有接口调用最终都路由到该对象的成员函数执行。

2.1.2 IUnknown接口与引用计数管理

IUnknown 是COM体系中最基础也是最重要的接口,所有其他接口都必须直接或间接继承自它。该接口包含三个核心方法: QueryInterface 、 AddRef 和 Release ,分别用于接口查询、引用增加和引用释放。正是这三个方法构成了COM对象生命周期管理的基础。

struct IUnknown {

virtual HRESULT QueryInterface(const IID& iid, void** ppv) = 0;

virtual ULONG AddRef() = 0;

virtual ULONG Release() = 0;

};

参数说明:

-

QueryInterface: -

iid: 请求的接口唯一标识符(GUID) -

ppv: 输出参数,接收指向目标接口的指针地址

返回值:S_OK表示成功,E_NOINTERFACE表示不支持该接口 -

AddRef: 增加引用计数,返回新计数值 -

Release: 减少引用计数,若归零则自动销毁对象,返回剩余计数

引用计数是一种轻量级的内存管理机制。每当客户端获得一个接口指针(如通过 CoCreateInstance 或 QueryInterface ),必须调用 AddRef ;当不再需要该指针时,必须调用 Release 。COM对象在其内部维护一个计数器,当计数降为0时,自动释放自身资源并销毁。

示例代码展示引用计数的典型使用场景:

IOPCServer* pServer = nullptr;

HRESULT hr = CoCreateInstance(__uuidof(OPCServer), NULL, CLSCTX_ALL,

IID_IOPCServer, (void**)&pServer);

if (SUCCEEDED(hr)) {

pServer->AddRef(); // 显式增加引用(通常由CoCreateInstance隐式完成)

// 使用接口...

OPCGROUPSTRUCTURE group;

pServer->AddGroup(L"MyGroup", TRUE, 1000, 0, 0, 0, &group);

pServer->Release(); // 释放引用,触发析构检查

}

逻辑分析:

-

CoCreateInstance成功后,系统已自动调用AddRef,因此此处显式调用非必需,但有助于理解机制。 - 在对象使用完毕后调用

Release,告知COM环境当前引用结束。 - 若此时引用计数为0,COM会调用

delete this或相应的析构逻辑。

这种机制避免了内存泄漏和悬空指针问题,特别是在多客户端共享同一服务器对象的场景下尤为重要。例如,多个HMI画面同时连接到同一个OPC服务器实例时,每个连接都会持有一个接口指针,引用计数确保只有在所有客户端断开后才真正关闭资源。

2.1.3 GUID与接口绑定机制

GUID(Globally Unique Identifier)是COM中用于唯一标识接口(IID)和类(CLSID)的128位标识符。由于COM组件可在全球范围内分布且由不同厂商开发,必须依靠全局唯一性来防止命名冲突。GUID通常表示为形如 {12345678-1234-1234-1234-123456789012} 的字符串格式。

在OPC DA中,关键接口均有预定义的IID,例如:

| 接口名称 | IID 定义 |

|---|---|

IOPCServer | {39225400-77DA-11CF-B53B-00AA0068841F} |

IOPCItemMgt | {39225402-77DA-11CF-B53B-00AA0068841F} |

IOPCAsyncIO2 | {4E3A7680-77DA-11CF-B53B-00AA0068841F} |

这些IID在IDL文件中声明,并在编译时嵌入类型库(TLB)和注册表项中。客户端程序通过这些IID向COM库请求特定接口,系统据此定位并加载正确的DLL或EXE组件。

GUID的生成通常借助Visual Studio内置工具 guidgen.exe 或调用API CoCreateGuid() 。一旦确定,不得更改,否则会导致接口无法匹配。

以下是使用GUID进行接口查询的典型流程:

IUnknown* pUnknown = /* 已获取的未知接口 */;

IOPCServer* pServer = nullptr;

HRESULT hr = pUnknown->QueryInterface(IID_IOPCServer, (void**)&pServer);

if (SUCCEEDED(hr)) {

// 成功获取IOPCServer接口

} else {

// 处理不支持该接口的情况

}

执行逻辑说明:

- 客户端持有

IUnknown*指针; - 调用

QueryInterface传入目标IID; - COM对象内部判断是否实现了对应接口;

- 若支持,则填充

ppv并调用AddRef,返回S_OK; - 否则返回

E_NOINTERFACE。

此机制实现了“动态绑定”,即运行时决定接口可用性,增强了系统的灵活性和扩展性。例如,某些OPC服务器可能仅支持同步读写而不支持异步回调,客户端可通过尝试 QueryInterface(IID_IOPCAsyncIO2, ...) 来探测功能级别,并据此调整通信策略。

sequenceDiagram

participant Client

participant COMObject

Client->>COMObject: QueryInterface(IID_IOPCServer, &ptr)

alt 接口存在

COMObject-->>Client: ptr = &vtable, AddRef()

Note right of COMObject: 填充指针并增加引用

else 接口不存在

COMObject-->>Client: ptr = nullptr, return E_NOINTERFACE

end

综上所述,GUID与接口绑定机制构成了COM组件发现与调用的基石,确保了OPC DA在异构系统间的互操作性。

2.2 DCOM在网络环境下的扩展能力

DCOM(Distributed COM)是对本地COM机制的网络扩展,允许COM对象跨越物理机器边界进行通信。在现代工厂自动化系统中,OPC客户端常部署于监控工作站,而OPC服务器运行于现场PLC控制器所在的工控机上,二者通常位于不同IP段甚至不同厂区。DCOM通过序列化接口调用并在TCP/IP上传输,实现了真正的分布式数据采集架构。

2.2.1 分布式通信原理与远程对象调用流程

DCOM的核心思想是“位置透明”——客户端代码无需感知对象是否运行在本地或远程,统一通过接口指针发起调用。当对象位于远程主机时,DCOM会在客户端侧生成一个“代理”(proxy),在服务端生成“存根”(stub),两者协同完成参数封送(marshaling)与网络传输。

调用流程如下:

- 客户端调用

CoCreateInstanceEx指定远程计算机名; - RPC runtime建立安全通道;

- 服务端创建实际对象并返回代理接口;

- 后续所有方法调用经由代理→网络→存根→真实对象执行;

- 返回值反向传递并解包。

COSERVERINFO serverInfo = {0};

serverInfo.pwszName = L"OPC-SERVER-01"; // 目标主机名

MULTI_QI multiQi = {0};

multiQi.pIID = &IID_IOPCServer;

multiQi.pItf = nullptr;

HRESULT hr = CoCreateInstanceEx(__uuidof(OPCServer), NULL,

CLSCTX_REMOTE_SERVER,

&serverInfo, 1, &multiQi);

参数说明:

-

CLSCTX_REMOTE_SERVER: 指定上下文为远程服务器; -

COSERVERINFO: 包含目标机器名称或IP; -

MULTI_QI: 支持一次请求多个接口。

该过程依赖RPC(Remote Procedure Call)协议,默认使用DCOM端口135进行初始协商,随后分配动态端口用于数据传输。整个调用对开发者近乎透明,但性能受网络延迟影响较大。

2.2.2 DCOM安全配置与身份验证机制

DCOM安全性涉及身份验证、权限控制与加密传输三个方面。默认情况下,Windows防火墙和UAC会阻止远程COM调用,必须手动配置。

关键配置项包括:

| 配置项 | 位置 | 推荐设置 |

|---|---|---|

| DCOM权限 | dcomcnfg.exe → 组件服务 → 计算机属性 | 启用分布式COM,设置访问/启动权限 |

| 用户账户 | 本地策略 → 用户权利分配 | 授予“作为服务登录”和“登录类型为批处理” |

| 防火墙规则 | Windows Defender Firewall | 开放135端口及动态范围(如1024-65535) |

此外,需确保客户端与服务器时间偏差小于5分钟(Kerberos要求),并建议使用域账户而非本地账户以简化信任链。

flowchart TD

A[客户端发起连接] --> B{是否通过身份验证?}

B -- 是 --> C[检查DCOM权限]

B -- 否 --> D[拒绝访问]

C --> E{是否有启动权限?}

E -- 是 --> F[创建远程对象]

E -- 否 --> G[返回ACCESS_DENIED]

F --> H[返回代理接口]

最佳实践还包括启用包级身份验证( RPC_C_AUTHN_LEVEL_PKT )和隐私保护( RPC_C_IMP_LEVEL_PRIVACY ),防止中间人攻击。

2.2.3 网络延迟与序列化对性能的影响分析

尽管DCOM提供了强大的远程调用能力,但其性能受限于网络质量和序列化效率。每次接口调用都需要将参数打包成网络字节流,在远端解包后再执行,这一过程引入显著延迟。

对于高频数据采集(如每秒千次更新),单次调用往返时间(RTT)可能高达数十毫秒,严重影响实时性。为此,OPC DA引入批量操作机制,如 SyncRead 一次性读取多个标签值,减少网络往返次数。

测试数据显示,在局域网环境下(1ms RTT),单标签读取耗时约8ms;而一次读取100个标签仅需12ms,吞吐量提升近10倍。

优化建议:

- 尽量使用异步接口(

IOPCAsyncIO2)避免阻塞主线程; - 合理设置组更新速率,避免过度频繁刷新;

- 在高延迟链路中启用数据压缩或采用OPC UA替代方案。

2.3 OPC DA接口体系结构详解

OPC DA定义了一套标准化的接口体系,组织成清晰的层次结构: OPCServer → OPCGroup → OPCItem 。每一层对应不同的资源配置粒度,便于客户端灵活管理数据订阅。

2.3.1 OPCServer、OPCGroup和OPCItem的层次关系

- OPCServer :代表整个数据源,如一台西门子S7-1500 PLC;

- OPCGroup :逻辑分组单位,用于设定共同的更新频率、死区等属性;

- OPCItem :最小数据单元,对应PLC中的某个寄存器地址(如

DB1.DBW2)。

这种三层结构既满足了高性能采集需求,又便于权限划分与故障隔离。

2.3.2 标准接口定义:IOPCServer、IOPCGroupStateMgt等

核心接口包括:

-

IOPCServer: 创建/删除组 -

IOPCGroupStateMgt: 管理组状态(激活、速率设置) -

IOPCItemMgt: 添加/移除数据项 -

IOPCSyncIO/IOPCAsyncIO2: 执行读写操作

每个接口都有明确的方法集和错误码规范,确保跨厂商一致性。

2.3.3 接口查询与动态绑定实践方法

客户端应始终使用 QueryInterface 动态探测服务器能力,而非假设所有接口均可用。例如:

IOPCAsyncIO2* pAsync = nullptr;

hr = pGroup->QueryInterface(IID_IOPCAsyncIO2, (void**)&pAsync);

if (SUCCEEDED(hr)) {

// 使用异步回调模式

} else {

// 回退到同步读取

}

此举提高了程序健壮性,适应不同品牌服务器的功能差异。

2.4 基于COM/DCOM的OPC DA运行时行为模拟

2.4.1 客户端获取服务器接口实例的过程追踪

通过 CoCreateInstance 或 ProgID 方式创建对象,经历注册表查找、DLL加载、对象构造全过程。

2.4.2 组与数据项的创建与注册机制实现示例

演示如何使用 IOPCServer::AddGroup 和 IOPCItemMgt::AddItems 添加监控点。

2.4.3 利用OLE View工具进行接口探测与调试技巧

介绍OLE/COM Object Viewer(oleview.exe)查看类型库、接口布局和CLSID注册信息的方法,辅助开发与排错。

3. OPC DA服务器开发全流程(初始化、数据更新、错误处理)

在工业自动化系统中,OPC DA 服务器作为连接底层设备与上层应用之间的桥梁,承担着实时采集、封装和分发现场数据的核心职责。构建一个稳定、高效且符合 OPC 规范的服务器,不仅需要深入理解 COM/DCOM 技术机制,还需对 OPC DA 接口体系有精准把控。本章将从服务器生命周期的三个关键阶段—— 初始化、数据更新、错误处理 入手,系统阐述开发流程中的设计原则、实现细节与最佳实践,并结合实际代码示例说明各模块的技术落地方式。

3.1 服务器模块的初始化设计

OPC DA 服务器本质上是一个 COM 组件,其启动过程必须遵循 Windows 平台下的组件对象模型规范。初始化阶段决定了服务器能否被客户端正确发现、连接并提供服务。此过程涉及 COM 注册、接口暴露、资源预分配以及日志系统的建立,是整个服务器运行的基础。

3.1.1 COM组件注册与CLSCTX上下文配置

COM 组件要对外提供服务,首先需通过注册表向操作系统声明自身存在。注册信息包括类标识符(CLSID)、程序标识符(ProgID)、线程模型(ThreadingModel)等关键字段。这些信息通常由开发者编写 .rgs 脚本文件或使用 Visual Studio 自动生成的注册函数完成。

// 示例:RGS 文件片段 - MyOpcServer.rgs

HKCR

{

NoRemove CLSID

{

ForceRemove {12345678-ABCD-EF01-2345-6789ABCDEF01} = s 'My OPC DA Server'

{

val AppID = s '{12345678-ABCD-EF01-2345-6789ABCDEF01}'

InprocServer32 = s '%MODULE%'

{

val ThreadingModel = s 'Apartment'

}

progid = s 'MyCompany.OpcServer.1'

}

}

}

上述 RGS 脚本定义了一个进程内服务器(InprocServer32),采用单线程单元(STA, Apartment)模型运行。 ThreadingModel 设置为 'Apartment' 表明该 COM 对象支持 OLE 自动化调用,适用于大多数 OPC DA 实现场景。

逻辑分析:

- CLSID :全局唯一标识该 COM 类,在客户端通过

CoCreateInstance创建实例时使用。 - ProgID :便于人类记忆的别名,如

"MyCompany.OpcServer.1",可用于脚本语言调用。 - ThreadingModel :设置为

'Apartment'意味着每个线程拥有独立的消息队列,避免多线程并发访问冲突,适合 GUI 或事件驱动型 OPC 服务。

当服务器安装后执行注册命令(如 regsvr32 MyOpcServer.dll ),系统会将这些条目写入注册表 HKEY_CLASSES_ROOT 分支,使 COM 库能够定位并加载组件。

此外,客户端创建实例时使用的 CLSCTX 上下文参数也至关重要:

IOPCServer* pServer = nullptr;

HRESULT hr = CoCreateInstance(

__uuidof(MyOpcServer), // CLSID of the server

NULL, // Not used for local servers

CLSCTX_LOCAL_SERVER | CLSCTX_REMOTE_SERVER, // Context flags

__uuidof(IOPCServer), // Desired interface

(void**)&pServer // Output pointer

);

参数说明:

| 参数 | 含义 |

|---|---|

__uuidof(MyOpcServer) | 获取类的 CLSID |

NULL | 不支持聚合(Aggregation) |

CLSCTX_LOCAL_SERVER | 允许本地 EXE 形式的服务器 |

CLSCTX_REMOTE_SERVER | 支持 DCOM 远程调用 |

__uuidof(IOPCServer) | 请求 IOPCServer 接口指针 |

⚠️ 注意:若服务器部署在远程机器上,必须启用 DCOM 配置,并确保防火墙开放端口 135 及动态 RPC 端口范围。

3.1.2 实现IOPCServer接口的关键步骤

IOPCServer 是 OPC DA 服务器对外暴露的主接口,所有客户端操作均从此接口开始。其实现需继承自 IUnknown ,并正确管理引用计数与接口查询。

class COpcServer : public IOPCServer

{

public:

// IUnknown

STDMETHOD(QueryInterface)(REFIID riid, void** ppvObject);

STDMETHOD_(ULONG, AddRef)();

STDMETHOD_(ULONG, Release)();

// IOPCServer

STDMETHOD(AddGroup)(

LPCWSTR szName,

BOOL bActive,

DWORD dwRequestedUpdateRate,

OPCHANDLE hClientGroup,

LONG* pTimeBias,

FLOAT* pTolerancePercent,

OPCHANDLE* phServerGroup,

DWORD* pRevisedUpdateRate,

REFIID riid,

LPUNKNOWN* ppUnk,

OPCHANDLE* phClientConnection

);

STDMETHOD(GetErrorString)(DWORD dwError, LCID dwLangID, LPWSTR* ppString);

// 其他方法省略...

private:

ULONG m_refCount;

std::map m_groups;

};

核心要点解析:

- 所有方法返回类型为

STDMETHOD,即HRESULT (__stdcall *)(),符合 COM 调用约定。 -

AddGroup方法用于创建数据组,是客户端组织订阅项的基本单位。 - 成员变量

m_refCount用于实现引用计数,防止内存提前释放。

以下是 QueryInterface 的典型实现:

STDMETHODIMP COpcServer::QueryInterface(REFIID riid, void** ppvObject)

{

if (!ppvObject) return E_INVALIDARG;

*ppvObject = nullptr;

if (riid == IID_IUnknown || riid == IID_IOPCServer)

{

*ppvObject = static_cast(this);

AddRef();

return S_OK;

}

return E_NOINTERFACE;

}

逐行解读:

- 检查输出指针有效性;

- 初始化为

nullptr,防止野指针; - 判断是否请求

IUnknown或IOPCServer接口; - 若匹配,则返回当前对象地址并增加引用计数;

- 否则返回

E_NOINTERFACE,表示不支持该接口。

此模式确保了接口的可扩展性,未来可添加 IOPCBrowseServerAddressSpace 等其他接口。

3.1.3 服务启动时的资源分配与日志记录机制

服务器启动过程中应完成必要的资源初始化工作,包括线程池创建、定时器设置、设备通信通道建立及日志系统初始化。

BOOL COpcServerApp::InitInstance()

{

if (!AfxOleInit())

return FALSE;

m_pMainWnd = new CMainFrame;

// 初始化日志系统

m_logger.Open(L"OpcServer.log");

m_logger.Write(L"Starting OPC DA Server...");

// 创建后台数据采集线程

m_hDataThread = CreateThread(NULL, 0, DataPollingThread, this, 0, &m_dwThreadId);

// 注册 COM 类工厂

HRESULT hr = _Module.RegisterClassObjects(CLSCTX_LOCAL_SERVER, REGCLS_MULTIPLEUSE);

if (FAILED(hr)) {

m_logger.Write(L"Failed to register class objects.");

return FALSE;

}

m_logger.Write(L"OPC DA Server started successfully.");

return TRUE;

}

资源管理策略:

- 使用

AfxOleInit()初始化 MFC 的 OLE 子系统; - 日志采用异步写入方式,避免阻塞主线程;

- 数据轮询线程独立运行,每 100ms 扫描一次 PLC 寄存器;

-

_Module.RegisterClassObjects将 COM 类暴露给外部调用者。

| 资源类型 | 初始化时机 | 释放时机 |

|---|---|---|

| COM 接口 | 进程启动 | 进程退出 |

| 数据线程 | InitInstance | ExitInstance |

| 日志文件 | Open() | Close() |

| 设备连接 | StartDeviceComm() | StopDeviceComm() |

graph TD

A[启动进程] --> B{成功初始化OLE?}

B -->|否| C[终止启动]

B -->|是| D[创建主窗口]

D --> E[打开日志文件]

E --> F[创建数据采集线程]

F --> G[注册COM类对象]

G --> H[等待客户端连接]

该流程图清晰展示了服务器启动的顺序依赖关系,任何环节失败都将导致服务无法正常对外提供能力。

3.2 数据项管理与实时更新机制

OPC DA 的核心功能在于以高频率、低延迟的方式向客户端推送现场数据变化。为此,服务器必须具备完善的数据项管理体系和高效的刷新机制。

3.2.1 数据项的添加、激活与订阅逻辑

数据项(Item)是 OPC 中最小的数据单元,隶属于某个组(Group)。客户端通过 IOPCItemMgt::AddItems 添加感兴趣的变量。

struct OpcItemDefinition {

LPWSTR szItemID; // 如 "PLC1.DB100.INT4"

VARTYPE vtRequestedDataType;

DWORD dwAccessPath; // 保留字段,常设为0

OPCHANDLE hClient; // 客户端指定句柄

};

// 添加多个数据项

STDMETHODIMP CGroup::AddItems(

DWORD dwCount,

OPCITEMDEF* pItemArray,

OPCITEMRESULT** ppAddResults,

HRESULT** ppErrors

)

{

*ppAddResults = new OPCITEMRESULT[dwCount];

*ppErrors = new HRESULT[dwCount];

for (DWORD i = 0; i < dwCount; ++i)

{

auto& def = pItemArray[i];

auto item = new CDataItem(def.szItemID, def.vtRequestedDataType);

// 解析地址并绑定到物理设备

if (!item->BindToHardware()) {

(*ppErrors)[i] = E_FAIL;

delete item;

continue;

}

m_items.push_back(item);

(*ppAddResults)[i].hServer = item->GetHandle();

(*ppAddResults)[i].vtCanonicalDataType = item->GetDataType();

(*ppErrors)[i] = S_OK;

}

return S_OK;

}

参数说明:

-

dwCount:待添加项数量; -

pItemArray:数组指针,包含客户端请求的所有项; -

ppAddResults:返回服务器为每一项分配的句柄和数据类型; -

ppErrors:返回每项操作结果状态码。

此方法完成后,数据项处于“未激活”状态,需调用 ValidateInterfaces() 并由组控制是否参与刷新循环。

3.2.2 基于定时器驱动的周期性数据刷新策略

为了保证数据一致性,OPC 组通常基于固定时间间隔进行批量更新。服务器内部维护一个高精度定时器,触发 OnTimerTick() 回调。

void COpcServer::OnTimerTick()

{

for (auto& groupPair : m_groups)

{

auto group = groupPair.second;

if (!group->IsActive()) continue;

std::vector changedItems;

for (auto item : group->GetItems())

{

VARIANT oldValue = item->GetValue();

item->RefreshFromDevice(); // 读取最新值

if (VariantCompare(&oldValue, &item->GetValue()) != 0)

{

changedItems.push_back(item);

}

}

// 触发回调通知客户端

group->NotifyClients(changedItems);

}

}

性能优化建议:

- 使用

QueryPerformanceCounter提供微秒级精度; - 多个组可共享同一时钟源,按各自

UpdateRate分频执行; - 变化检测采用

VariantCompare函数,支持多种基本类型比较。

3.2.3 模拟量与开关量数据源的封装方法

不同类型的数据在处理逻辑上存在差异,应抽象出统一接口。

class CDataItem

{

public:

virtual bool RefreshFromDevice() = 0;

virtual VARIANT GetValue() const = 0;

protected:

std::wstring m_itemId;

VARIANT m_value;

bool m_isActive;

};

class CAnalogItem : public CDataItem

{

public:

bool RefreshFromDevice() override

{

float raw = ReadModbusRegister(m_address);

m_value.fltVal = raw * m_scale + m_offset;

m_value.vt = VT_R4;

return true;

}

};

class CDigitalItem : public CDataItem

{

public:

bool RefreshFromDevice() override

{

BYTE bit = ReadDigitalInput(m_port, m_bitIndex);

m_value.boolVal = (bit ? VARIANT_TRUE : VARIANT_FALSE);

m_value.vt = VT_BOOL;

return true;

}

};

特性对比表:

| 特性 | 模拟量 | 开关量 |

|---|---|---|

| 数据类型 | VT_R4 / VT_R8 | VT_BOOL |

| 更新频率 | 高(10~100ms) | 中等(50~500ms) |

| 存储格式 | 浮点数 | 布尔值 |

| 显示单位 | °C, MPa, RPM | ON/OFF, TRUE/FALSE |

此类设计提升了代码复用性和可维护性,便于后续扩展温度传感器、流量计等新型设备。

classDiagram

class CDataItem {

<>

+wstring m_itemId

+VARIANT m_value

+bool m_isActive

+RefreshFromDevice()

+GetValue()

}

class CAnalogItem

class CDigitalItem

CDataItem <|-- CAnalogItem

CDataItem <|-- CDigitalItem

3.3 错误处理与异常恢复机制

健壮的 OPC 服务器必须能优雅应对各种运行时异常,包括通信中断、内存不足、非法访问等。

3.3.1 HRESULT返回码的标准使用规范

所有 COM 接口方法必须返回 HRESULT 类型,用于传递执行状态。

| 返回值 | 含义 | 使用场景 |

|---|---|---|

S_OK | 成功 | 正常返回 |

E_FAIL | 一般性失败 | 内部错误 |

E_OUTOFMEMORY | 内存不足 | new 失败 |

E_INVALIDARG | 参数无效 | 空指针传入 |

OPC_E_UNKNOWNITEM | 项不存在 | 查询未知变量 |

STDMETHODIMP CGroup::SyncRead(

DWORD dwSource,

DWORD dwCount,

OPCHANDLE* phServer,

VARIANT** ppValues,

WORD** ppQualities,

FILETIME** ppTimestamps,

HRESULT** ppErrors

)

{

if (!phServer || !ppValues) return E_INVALIDARG;

if (dwCount == 0) return S_FALSE;

*ppValues = new VARIANT[dwCount];

*ppErrors = new HRESULT[dwCount];

for (DWORD i = 0; i < dwCount; ++i)

{

CDataItem* pItem = FindItemByHandle(phServer[i]);

if (!pItem) {

(*ppErrors)[i] = OPC_E_UNKNOWNITEM;

continue;

}

(*ppValues)[i] = pItem->GetValue();

(*ppErrors)[i] = S_OK;

}

return S_OK;

}

错误传播原则:

- 层级间错误应逐级上报,不得忽略;

- 自定义错误码可通过

MAKE_HRESULT(SEVERITY_ERROR, FACILITY_ITF, 0x200)构造; - 客户端可通过

GetErrorString获取可读描述。

3.3.2 异常捕获与故障上报机制设计

在 C++ 中推荐使用 RAII 和 SEH 结合方式进行异常保护。

void CDataItem::RefreshFromDevice()

{

__try {

ReadFromPLC(m_address, &m_buffer);

}

__except(EXCEPTION_EXECUTE_HANDLER)

{

m_lastError = GetLastError();

Log(L"Access violation when reading %s", m_itemId.c_str());

SetQuality(OPC_QUALITY_COMM_FAILED);

}

}

同时,服务器应维护一个全局错误队列,供客户端查询近期发生的严重事件。

struct ServerErrorInfo {

DWORD error;

FILETIME timestamp;

WCHAR description[256];

};

std::queue g_errorQueue;

// 客户端调用 IOPCServer::GetErrorString 获取文本

3.3.3 断线重连与状态同步的容错方案

当底层设备断开时,服务器不应崩溃,而应进入降级模式:

void CDeviceLink::MonitorConnection()

{

while (m_running)

{

if (!PingDevice())

{

m_status = DISCONNECTED;

ScheduleReconnect(5000); // 5秒后尝试重连

}

Sleep(1000);

}

}

void CDeviceLink::ScheduleReconnect(DWORD delay)

{

HANDLE hTimer = CreateWaitableTimer(NULL, TRUE, NULL);

LARGE_INTEGER li = {-delay * 10000LL}; // 百纳秒单位

SetWaitableTimer(hTimer, &li, 0, OnReconnectCallback, this, FALSE);

}

重连成功后,需重新同步所有活动项的状态,确保数据连续性。

stateDiagram-v2

[*] --> Running

Running --> Disconnected: Ping failed

Disconnected --> Reconnecting: Timer expired

Reconnecting --> Running: Connect success

Reconnecting --> Disconnected: Retry failed

3.4 OPC Foundation SDK在服务器开发中的集成实践

直接手写 COM 接口繁琐易错,OPC Foundation 提供的官方 SDK 可大幅简化开发流程。

3.4.1 SDK核心类库结构解析

SDK 主要包含以下组件:

- OSIComLib.dll :基础 COM 工具类

- OpsErr.DLL :标准错误码定义

- Opccomn_i.c :接口 IDL 头文件

- CTransactionObj :事务管理基类

项目结构示意:

MyOpcServer/

├── Server.cpp // 主入口

├── Group.cpp // 组管理

├── Item.cpp // 数据项

└── SDK/

├── include/

└── lib/

3.4.2 自定义服务器类继承与接口重写示例

class CMyServer : public Opclib::COpcServer

{

public:

CMyServer() : COpcServer(L"MyCompany.OpcServer") {}

virtual ~CMyServer() {}

// 重写创建组的方法

Opclib::COpcGroup* CreateGroup(const TCHAR* szName)

{

return new CMyGroup(szName, this);

}

};

SDK 提供了默认的 IOPCServer 实现,只需覆盖特定虚函数即可定制行为。

3.4.3 利用SDK简化COM注册与接口暴露过程

传统手动注册复杂,SDK 提供宏自动处理:

BEGIN_OBJECT_MAP(ObjectMap)

OBJECT_ENTRY(CLSID_MyOpcServer, CMyServer)

END_OBJECT_MAP()

int _tmain()

{

OleInitialize(NULL);

StartOpcServer(ObjectMap);

WaitForSingleObject(INFINITE);

}

StartOpcServer 内部完成类工厂注册、消息循环启动等工作,极大降低入门门槛。

| 功能 | 手动实现 | SDK 辅助 |

|---|---|---|

| COM 注册 | 编写 RGS | OBJECT_ENTRY |

| 接口暴露 | QueryInterface | 基类封装 |

| 日志输出 | fopen/write | COpcTrace |

| 错误映射 | switch-case | Opclib::ThrowError |

综上所述,合理利用 SDK 不仅提升开发效率,也有助于保证规范兼容性,是企业级 OPC 服务器开发的首选路径。

4. OPC DA客户端开发实现(连接、订阅、读写操作)

在工业自动化系统中,OPC DA客户端作为数据消费者,承担着与底层设备通信的关键任务。它通过标准接口访问远程或本地的OPC DA服务器,获取实时过程数据,并支持对控制变量进行写入操作,广泛应用于SCADA监控、MES数据采集、HMI界面驱动等场景。本章将深入探讨OPC DA客户端的核心功能模块——从建立与服务器的稳定连接,到高效管理数据订阅机制,再到同步与异步读写操作的编程模型设计,最终延伸至多线程环境下的资源协调与性能优化策略。整个实现过程依托COM/DCOM技术栈,要求开发者具备扎实的组件对象模型理解能力以及对Windows平台下分布式调用机制的掌握。

4.1 客户端与服务器的连接建立

OPC DA客户端要实现数据交互,首要任务是成功连接目标OPC服务器。该过程本质上是基于COM/DCOM架构的远程对象实例化操作,涉及ProgID或CLSID定位、安全上下文配置、网络可达性验证等多个环节。一个健壮的连接机制不仅需要正确调用系统API,还需具备完善的错误诊断与恢复能力,以应对复杂的现场部署环境。

4.1.1 使用ProgID或CLSID定位OPC服务器

在COM体系中,每个可创建的对象都由唯一的标识符唯一确定,即类标识符(CLSID),而ProgID则是其人类可读的别名形式。例如,Matrikon OPC仿真服务器的ProgID为 Matrikon.OPC.Simulation.1 ,对应的CLSID可通过注册表查询获得。客户端程序通常优先使用ProgID进行连接,因其更易于维护和配置;但在某些环境下(如跨语言调用或脚本环境),直接使用CLSID更为可靠。

以下是一个使用C++通过ProgID获取CLSID并创建实例的示例代码:

#include

#include

HRESULT ConnectToOPCServerByProgID(const char* progId, IUnknown** ppUnknown) {

CLSID clsid;

HRESULT hr = CLSIDFromProgID(_bstr_t(progId), &clsid);

if (FAILED(hr)) {

std::cerr << "无法解析ProgID: " << progId << std::endl;

return hr;

}

hr = CoCreateInstance(clsid, NULL, CLSCTX_REMOTE_SERVER,

IID_IUnknown, (void**)ppUnknown);

if (FAILED(hr)) {

std::cerr << "CoCreateInstance失败,HR=" << std::hex << hr << std::endl;

}

return hr;

}

逻辑分析与参数说明:

-

CLSIDFromProgID:将字符串形式的ProgID转换为二进制CLSID结构。若服务器未正确注册,则返回REGDB_E_CLASSNOTREG错误。 -

_bstr_t:COM字符串包装类,自动处理BSTR内存管理。 -

CoCreateInstance:核心COM API,用于创建指定CLSID的对象实例。关键参数包括: -

CLSCTX_REMOTE_SERVER:允许在远程机器上创建对象,启用DCOM通信; -

IID_IUnknown:请求返回IUnknown接口指针,作为后续QueryInterface的基础; -

ppUnknown:输出参数,接收创建成功的接口指针。

该函数封装了从ProgID到接口实例的完整路径,适用于大多数OPC DA客户端初始化流程。

| ProgID 示例 | 厂商 | 典型应用场景 |

|---|---|---|

Matrikon.OPC.Simulation.1 | Matrikon | 测试与教学 |

Siemens.Automation.SimaticHmi.OpcDaServer | 西门子 | HMI集成 |

Rockwell.Automation.OPCAccess | 罗克韦尔 | ControlLogix PLC通信 |

GE.Fanuc.IGS.RealTimeServer | GE Fanuc | 通用数据采集 |

注意 :ProgID必须在客户端机器的注册表中存在映射关系,否则需手动注册或使用DCOMCNFG工具配置远程激活权限。

4.1.2 CoCreateInstance远程调用实现连接

当目标OPC服务器运行于远程主机时, CoCreateInstance 会触发DCOM协议栈完成一系列复杂操作,包括身份验证、安全令牌传递、远程进程启动等。此过程依赖于DCOM配置的完整性,尤其是DComConfig键项中的AppID设置。

sequenceDiagram

participant Client

participant DCOM

participant ServerMachine

participant OPCServer

Client->>DCOM: CoCreateInstance(CLSID, REMOTE_SERVER)

DCOM->>ServerMachine: RPC调用至RPCSS服务

ServerMachine->>OPCServer: 启动OPC服务进程(如果未运行)

OPCServer-->>ServerMachine: 注册类工厂

ServerMachine-->>DCOM: 返回远程对象代理

DCOM-->>Client: 提供透明代理接口

Client->>OPCServer: 调用IOPCServer接口方法

上述流程图展示了DCOM远程实例化的典型交互序列。其中, RPCSS (Remote Procedure Call Service)负责协调跨机通信,而OPC服务器必须已在DCOM配置中启用“在此计算机上启动”和“本地激活”权限。

实际开发中,建议采用智能指针简化资源管理。以下是使用ATL智能指针改进后的连接代码:

CComPtr spServer;

HRESULT hr = spServer.CoCreateInstance(__uuidof(OPCServer));

if (FAILED(hr)) {

_com_error err(hr);

std::wcout << L"连接失败:" << err.ErrorMessage() << std::endl;

return false;

}

扩展说明:

- __uuidof(OPCServer) 是编译器扩展,自动提取类型对应的GUID;

- CComPtr 自动管理引用计数,在析构时调用 Release() ,避免内存泄漏;

- 此方式仅适用于本地服务器连接。对于远程连接,需配合 CoInitializeSecurity 和 COSERVERINFO 结构体显式指定目标主机。

4.1.3 连接失败常见原因与排查路径

尽管连接逻辑看似简单,但实践中常因安全策略限制导致失败。以下是典型的故障分类及解决方案:

| 故障现象 | 可能原因 | 解决方案 |

|---|---|---|

| RPC服务器不可用(0x800706BA) | 网络不通或DCOM服务未启动 | 检查防火墙、ping目标IP、确认DCOM服务运行 |

| 访问被拒绝(0x80070005) | 权限不足或DACL配置错误 | 在dcomcnfg中添加用户并授予本地/远程激活权限 |

| 类未注册(0x80040154) | ProgID未注册或CLSID缺失 | 运行 regsvr32 重新注册OPC服务器DLL |

| 服务器无法启动 | 服务依赖项缺失或路径错误 | 查看事件日志,检查服务可执行文件位置 |

此外,可借助 OLE/COM Object Viewer (oleview.exe)工具探测远程机器上的OPC服务器是否可见。具体步骤如下:

- 打开 oleview.exe;

- 导航至 “File → Connect to Computer”,输入远程主机名;

- 展开 “HKEY_CLASSES_ROOTAPPID” 查找对应ProgID条目;

- 验证其Launch Permission和Access Permission设置。

只有当这些权限明确包含当前登录用户且允许远程激活时, CoCreateInstance 才能成功建立连接。

4.2 数据订阅与异步事件处理机制

一旦客户端成功连接OPC服务器,下一步便是构建有效的数据订阅机制,以便实时接收变量更新。OPC DA采用“组+项”的分层结构来组织数据流,同时提供异步回调接口,使应用程序能够在不影响主线程的情况下响应数据变化。

4.2.1 创建组对象并添加监控数据项

OPC DA中的数据组织遵循三层结构:服务器 → 组(Group)→ 项(Item)。组的作用是对相关数据项进行逻辑分组,便于统一设置更新速率、死区和活跃状态。

CComPtr spItemMgt;

hr = spServer.QueryInterface(&spItemMgt);

if (FAILED(hr)) return hr;

// 创建新组

DWORD dwGroupHandle;

CComPtr spGroupState;

hr = spServer->AddGroup(

L"MyDataGroup", // 组名称

TRUE, // 是否活跃

1000, // 请求更新速率(ms)

0, // 客户端组句柄(可选)

NULL, // 深度缓冲比(默认)

0, // 固定波特率(忽略)

&dwGroupHandle, // 输出:服务器分配的组句柄

&spGroupState // 输出:组状态管理接口

);

参数详解:

- L"MyDataGroup" :Unicode字符串,标识组名;

- TRUE :表示立即激活该组,开始周期性刷新;

- 1000 :请求每秒一次更新,实际值由服务器裁决;

- dwGroupHandle :服务器侧唯一标识符,后续操作必需;

- spGroupState :用于后续调整组参数(如修改更新频率)。

添加数据项代码如下:

OPCITEMDEF itemDef = {0};

itemDef.szItemID = L"Random.Int4"; // 项ID(来自服务器命名空间)

itemDef.bActive = TRUE;

itemDef.hClient = 1; // 客户端自定义句柄

OPCITEMRESULT* pItemResult = nullptr;

DWORD* pErrors = nullptr;

hr = spItemMgt->AddItems(1, &itemDef, &pItemResult, &pErrors);

成功后, pItemResult->hServer 返回服务器为该项分配的句柄,用于后续读写。

4.2.2 实现IOPCDataCallback回调接口

为了接收数据变更通知,客户端必须实现 IOPCDataCallback 接口,并将其连接到组对象。这通常通过继承纯虚类完成:

class CMyCallback : public IOPCDataCallback {

public:

STDMETHODIMP QueryInterface(REFIID riid, void** ppv) {

if (riid == IID_IUnknown || riid == IID_IOPCDataCallback) {

*ppv = static_cast(this);

AddRef();

return S_OK;

}

*ppv = nullptr;

return E_NOINTERFACE;

}

STDMETHODIMP OnDataChange(

DWORD dwTransid, DWORD hGroup, HRESULT hrMasterquality,

HRESULT hrMastererror, DWORD dwCount, OPCHANDLE* phClientItems,

VARIANT* pvValues, WORD* pwQualities, FILETIME* pftTimeStamps,

HRESULT* pErrors) override {

for (DWORD i = 0; i < dwCount; ++i) {

std::wcout << L"值更新: " << V_I4(&pvValues[i]) << std::endl;

}

return S_OK;

}

// 其他方法省略...

};

回调逻辑说明:

- OnDataChange 在服务器检测到任意项变化时触发;

- dwCount 表示本次通知包含的数据项数量;

- pvValues 数组携带最新值,类型由VARIANT自动封装;

- 所有操作应在最短时间内完成,防止阻塞DCOM回调线程。

注册回调的代码片段:

CComPtr spCPC;

spGroupState.QueryInterface(&spCPC);

CComPtr spCP;

spCPC->FindConnectionPoint(IID_IOPCDataCallback, &spCP);

DWORD cookie;

spCP->Advise(static_cast(new CMyCallback()), &cookie);

4.2.3 异步通知响应与数据变更触发逻辑

OPC DA的数据推送基于“脏标记+扫描”机制。服务器定期轮询物理设备,当某项值超出死区阈值或质量状态改变时,将其标记为“dirty”,并在下一个更新周期批量发送给所有订阅客户端。

graph TD

A[设备数据源] --> B{是否变化?}

B -- 是 --> C[标记为Dirty]

B -- 否 --> D[保持原状]

C --> E[加入待发送队列]

E --> F[按组刷新周期发送]

F --> G[触发OnDataChange]

这种设计平衡了实时性与网络负载。开发中应注意:

- 设置合理的更新周期(不宜低于100ms);

- 合理配置死区(Deadband)以减少冗余传输;

- 避免在 OnDataChange 中执行耗时操作(如数据库写入),应转发至工作线程处理。

4.3 同步与异步读写操作的编程模型

除了被动接收数据外,客户端还经常需要主动发起读写请求,尤其在HMI写入设定值或调试工具中频繁使用。

4.3.1 SyncRead/SyncWrite接口调用流程

同步读取是最简单的模式,适合低频操作:

OPCHANDLE arrHandles[] = { hServerItem };

VARIANT arrValues[1];

WORD arrQualities[1];

FILETIME arrTimestamps[1];

HRESULT arrErrors[1];

hr = spSyncIO->SyncRead(OPC_DS_CACHE, 1, arrHandles,

arrValues, arrQualities, arrTimestamps, arrErrors);

-

OPC_DS_CACHE:从缓存读取(最快); -

OPC_DS_DEVICE:强制从设备读取(较慢但最新)。

同步写入类似:

VARIANT newValue;

VariantInit(&newValue);

V_I4(&newValue) = 100;

V_VT(&newValue) = VT_I4;

hr = spSyncIO->SyncWrite(1, &hServerItem, &newValue, arrErrors);

4.3.2 异步读写中的事务标识符(Transaction ID)管理

异步操作使用 AsyncRead / AsyncWrite ,通过 dwTransactionID 区分不同请求:

DWORD transactionId = GenerateUniqueID();

hr = spAsyncIO->AsyncRead(1, &hItem, transactionId, &cancelID, errors);

在 OnDataChange 中根据 dwTransid 匹配结果:

if (dwTransid == expectedId) {

ProcessResponse(pvValues);

}

推荐使用原子递增生成ID,确保并发安全。

4.3.3 多组并发访问时的数据一致性保障

当多个组订阅相同项时,需注意:

- 不同组可能设置不同更新周期,导致数据时间戳不一致;

- 写操作应锁定共享资源,防止竞态条件;

- 可引入中央缓存层统一管理最新值视图。

4.4 多线程与同步机制在OPC DA程序中的应用

4.4.1 主线程与回调线程的分离设计

DCOM回调运行在专用MTA线程中,不应直接更新UI。应使用消息队列或事件机制转发:

PostMessage(hWndMain, WM_OPC_UPDATE, wParam, lParam);

4.4.2 关键资源的临界区保护与互斥锁使用

共享数据结构需加锁:

CRITICAL_SECTION cs;

InitializeCriticalSection(&cs);

EnterCriticalSection(&cs);

// 操作共享变量

LeaveCriticalSection(&cs);

4.4.3 高频数据处理场景下的线程池优化策略

对于每秒数千次更新的应用,可结合I/O完成端口或使用Boost.Asio构建异步处理管道,提升吞吐量。

5. OPC DA源码分析与工业物联网融合拓展

5.1 典型服务器与客户端源码结构解析

在深入理解OPC DA的运行机制时,对典型服务器与客户端实现的源码进行剖析是掌握其底层行为的关键。以开源项目 OpenOPC 和 RSLinx Classic SDK 示例程序 为参考,结合前几章所述的COM/DCOM架构和接口定义,可以清晰地识别出核心组件间的调用关系。

5.1.1 第二章源码中COM组件注册与接口暴露细节

在OPC服务器开发中, DllRegisterServer() 函数负责将COM类注册到Windows注册表。关键代码如下:

STDAPI DllRegisterServer()

{

HRESULT hr = _Module.DllRegisterServer();

if (SUCCEEDED(hr)) {

// 注册 OPC Server 类别 (CATID_OPCDAServer2)

ICatRegister* pCatReg = NULL;

hr = CoCreateInstance(CLSID_StdComponentCategoriesMgr, NULL,

CLSCTX_LOCAL_SERVER, IID_ICatRegister, (void**)&pCatReg);

if (SUCCEEDED(hr)) {

CATEGORYINFO catInfo = { CATID_OPCDAServer2, LOCALE_NEUTRAL, L"OPC DA Server 2.0" };

pCatReg->RegisterCategories(1, &catInfo);

pCatReg->Release();

}

}

return hr;

}

该函数不仅完成CLSID注册,还通过 ICatRegister 将组件归类至 OPC DA Server 类别,使得客户端可通过 CoCreateInstanceEx 按类别查找可用服务器。同时,在对象创建过程中, CComClassFactory::CreateInstance() 调用 IUnknown::QueryInterface(IID_IOPCServer) 实现接口动态绑定,确保客户端能正确获取服务句柄。

| 接口名称 | 功能描述 | 是否必需 |

|---|---|---|

| IOPCServer | 主控接口,管理组对象 | 是 |

| IOPCItemMgt | 管理数据项添加与删除 | 是 |

| IOPCSyncIO | 支持同步读写操作 | 否 |

| IOPCAsyncIO2 | 提供异步数据访问支持 | 推荐 |

| IConnectionPointContainer | 支持事件回调订阅 | 推荐 |

5.1.2 第三章服务器数据更新循环的实现逻辑

OPC服务器通常使用独立线程执行周期性数据采集任务。以下是一个基于 std::thread 的模拟量更新示例:

void OPCServer::DataUpdateLoop() {

while (_running) {

for (auto& item : _activeItems) {

if (item.IsActive()) {

VARIANT newValue = GenerateSimulatedValue(item.Type); // 模拟生成值

FILETIME ft;

GetSystemTimeAsFileTime(&ft);

// 触发变更通知

NotifyClients(item.ID, newValue, OPCTIMESTAMP, ft, S_OK);

}

}

std::this_thread::sleep_for(std::chrono::milliseconds(_updateRateMs));

}

}

此循环每 100ms 执行一次(可配置),遍历所有激活的数据项并生成新值,随后调用 IOPCDataCallback::OnDataChange 回调客户端。 NotifyClients() 内部维护一个连接点容器( IConnectionPoint ),广播状态变化事件。

5.1.3 第四章客户端订阅回调函数的具体执行流程

客户端需实现 IOPCDataCallback 接口以接收异步通知。典型的 OnDataChange 方法实现如下:

HRESULT STDMETHODCALLTYPE OPCClient::OnDataChange(

DWORD dwTransid, OPCHANDLE hGroup,

HRESULT hrMasterquality, HRESULT hrMastererror,

DWORD dwCount, OPCHANDLE *phClientItems,

VARIANT *pvValues, WORD *pwQualities,

FILETIME *pftTimeStamps, HRESULT *pErrors)

{

for (DWORD i = 0; i < dwCount; ++i) {

auto it = _itemMap.find(phClientItems[i]);

if (it != _itemMap.end()) {

LogValue(it->second.Name, pvValues[i], pwQualities[i], pftTimeStamps[i]);

}

}

return S_OK;

}

当服务器推送变更时,DCOM运行时序列化参数并通过RPC传递至客户端线程池中的专用回调线程。开发者必须注意跨线程访问共享资源的安全性,常采用 CriticalSection 或 SRWLock 进行保护。

sequenceDiagram

participant Server

participant DCOM

participant Client

Server->>DCOM: Fire OnDataChange()

DCOM->>Client: Deserialize args

Client->>Client: Enter critical section

Client->>Client: Update local cache

Client->>Log: Write to history DB

该流程揭示了从数据触发到应用层响应的完整路径,强调了事件驱动模型在实时监控系统中的核心地位。

5.2 数据访问模块与事件驱动模型深度剖析

5.2.1 从数据采集到客户端推送的完整链路追踪

OPC DA系统的数据流遵循“采集 → 缓存 → 比较 → 触发 → 序列化 → 推送”六阶段模型。假设某温度传感器每 200ms 更新一次原始值,服务器端的处理流程如下:

- 采集层 :通过串口或以太网读取PLC寄存器。

- 缓存层 :存储当前值、品质(Quality)和时间戳。

- 变更检测 :比较新旧值差值是否超过Deadband阈值(如±0.5℃)。

- 触发判断 :若满足条件,则标记为“需通知”。

- 序列化打包 :构造包含多个变更项的VARIANT数组。

- 异步推送 :调用

IAdviseSink::OnDataChange分发给各订阅者。

这种设计有效减少冗余通信,尤其适用于高噪声环境下的模拟信号传输。

5.2.2 基于事件队列的状态变化传播机制

为避免阻塞主线程,OPC服务器普遍采用生产者-消费者模式管理变更事件。事件队列结构如下:

struct DataChangeEvent {

DWORD itemHandle;

VARIANT value;

WORD quality;

FILETIME timestamp;

};

std::queue _eventQueue;

std::mutex _queueMutex;

std::condition_variable _cv;

另一个后台线程持续监听队列:

void EventDispatchThread() {

while (_running) {

std::unique_lock lock(_queueMutex);

_cv.wait(lock, [this] { return !_eventQueue.empty() || !_running; });

while (!_eventQueue.empty()) {

auto evt = _eventQueue.front(); _eventQueue.pop();

BroadcastToSubscribers(evt); // 遍历所有连接点

}

}

}

该机制保障了高吞吐场景下系统的稳定性与响应性。

5.2.3 回调频率控制与反压处理策略

在极端情况下(如千点以上高速更新),客户端可能无法及时处理大量回调,导致内存堆积。为此应引入反压机制:

- 设置最大回调频率上限(如10Hz)

- 使用滑动窗口统计单位时间内的事件数量

- 当超出阈值时,自动切换为聚合发送模式(批量打包)

此外,可通过 IOPCGroupStateMgt::SetState() 调整组的更新速率,实现动态负载均衡。

| 参数 | 默认值 | 可调范围 | 影响维度 |

|---|---|---|---|

| UpdateRate (ms) | 1000 | 100 ~ 60000 | 网络负载、CPU占用 |

| TimeBias | 0 | -86400~86400 | 时间同步精度 |

| PercentDeadband | 0 | 0.0 ~ 100.0 | 数据冗余度 |

| LocaleID | 0x409 | Windows LCID集 | 字符编码兼容性 |

这些参数可通过客户端调用 SetState() 方法动态修改,体现了OPC DA灵活的运行时配置能力。

本文还有配套的精品资源,点击获取

简介:OPC DA是工业自动化领域中基于COM技术的标准数据访问接口,广泛应用于制造业、新能源和物联网等场景。本资源包含一本系统讲解OPC DA服务器与客户程序开发的指南书籍,以及第二章、第三章和第四章的配套源码,涵盖OPC DA架构、服务器与客户端开发核心技术。通过理论学习与代码实践,开发者可掌握OPC DA组件设计、数据读写、订阅机制、事件处理及性能优化等关键技能,为构建高效、互操作的自动化系统奠定基础。

本文还有配套的精品资源,点击获取