Ascend 910B 服务器深度解析:国产 AI 大模型训练的最强底座

目录

Ascend 910B 服务器深度解析:国产 AI 大模型训练的最强底座

⭐ 一、什么是 Ascend 910B?

🔧 二、Ascend 910B 的硬件规格(对标 A100/H100)

🧠 三、910B 的核心架构:Da Vinci + HCCS

1)Da Vinci 计算架构

2)HCCS 高速互联

🧩 四、软件栈:CANN、MindSpore、PyTorch 全面兼容

✔ 1)CANN(Compute Architecture for Neural Networks)

✔ 2)MindSpore(华为深度学习框架)

✔ 3)PyTorch + Ascend NPU 插件

✔ 4)TensorFlow + Ascend 插件

📈 五、910B 的训练能力(真实场景表现)

✔ 1)大模型训练(LLaMA / Qwen / GLM)

✔ 2)推理性能强(尤其是吞吐场景)

✔ 3)大规模集群效果优异

🔍 六、生态兼容性(论文模型基本都能跑)

✔ NLP 大模型

✔ 多模态/图像模型

✔ 量化方案

🔧 七、910B 服务器有哪些典型配置?

1)Atlas 800 训练服务器(最常见)

2)Atlas 300 卡(插卡)

3)Atlas 900 大模型集群

🆚 八、与 NVIDIA A100/H100 对比

🏭 九、适用场景(非常实用)

✔ 1)国产化场景(政府、金融、制造业)

✔ 2)大模型公司从零开始搭建训练集群

✔ 3)推理服务(LLM Serving)

✔ 4)企业内部 AI 平台

✔ 5)高校科研

💡 十、购买与部署建议(经验总结)

✔ 1)必须提前确认的软件栈

✔ 2)推荐的场景选型

✔ 3)配套依赖

📌 十一、未来趋势:910B → 910C → 下一代昇腾

🏁 十二、全文总结(给读者的 30 秒版本)

Ascend 910B 服务器深度解析:国产 AI 大模型训练的最强底座

近年来,随着 ChatGPT、LLaMA、Qwen、GLM 等大模型爆发,超大规模 AI 计算能力成为核心竞争力。然而 NVIDIA A100/H100 的供给、价格与政策因素,使得企业、高校与科研机构急需替代方案。

在国产算力方向中,华为昇腾 910B(Ascend 910B) 是当前最强的 AI 训练芯片,而基于 910B 构建的 Ascend 服务器(Atlas 800/900 系列) 已被广泛用于大模型训练和部署。

本文将从 架构、性能、软件栈、生态兼容性、使用体验、场景、部署建议 多维度,深入解析 Ascend 910B 服务器。

⭐ 一、什么是 Ascend 910B?

Ascend 910B 是华为推出的第二代旗舰 AI 训练芯片,是国产最强的 NPU(Neural Processing Unit)之一,用于大模型训练、推理和高性能计算。

它的定位类似:

-

NVIDIA A100/H100 的国产替代方案

-

大模型训练的核心算力芯片

910B 广泛用于华为 Atlas 系列服务器,例如:

-

Atlas 800 训练服务器(单机 8×910B)

-

Atlas 900 大规模集群(数百~数千张 910B)

这些服务器已经用于:

-

大模型训练(百亿〜千亿参数)

-

多模态模型、图像模型、语音模型

-

金融、电信、科研超算中心

🔧 二、Ascend 910B 的硬件规格(对标 A100/H100)

下面是 官方典型指标(训练场景):

| 指标 | Ascend 910B |

|---|---|

| 架构 | Da Vinci Core(自研) |

| FP16/BF16 算力 | > 2000 TFLOPS |

| INT8 算力 | > 4000 TOPS |

| 片上内存 | 32GB HBM |

| 内存带宽 | ~900 GB/s |

| 互联技术 | HCCS(高带宽互联) |

| 功耗 | 350W〜450W |

| 工艺 | 7nm |

总结:

-

训练算力接近 A100,部分场景超过 A100。

-

在国产自研芯片中性能最强,生态持续完善。

🧠 三、910B 的核心架构:Da Vinci + HCCS

1)Da Vinci 计算架构

这是华为自研的 AI 计算单元,特点:

-

针对矩阵计算深度优化

-

针对 Transformer 结构大量优化

-

Tensor Core 类似单元可高速运行 GEMM

-

强化 AI 模型训练与推理的高能效比

2)HCCS 高速互联

用于多 NPU 之间互联,类似 NVIDIA NVLink。

特点:

-

单机 8 卡带宽直连

-

延迟低,利于大模型训练

-

多机可扩展成超大规模集群(Atlas 900)

在规模化集群中表现稳定。

🧩 四、软件栈:CANN、MindSpore、PyTorch 全面兼容

Ascend 的软件栈是国产 AI 中最成熟的一套:

✔ 1)CANN(Compute Architecture for Neural Networks)

相当于:

-

华为版本的 CUDA

-

底层 AI 加速框架

-

提供算子、编译器、调优工具

CANN = Ascend 平台的灵魂。

✔ 2)MindSpore(华为深度学习框架)

专门为 Ascend 优化:

-

支持动态图/静态图

-

并行策略丰富

-

大模型训练性能很强

GLM、华为盘古模型等都基于 MindSpore。

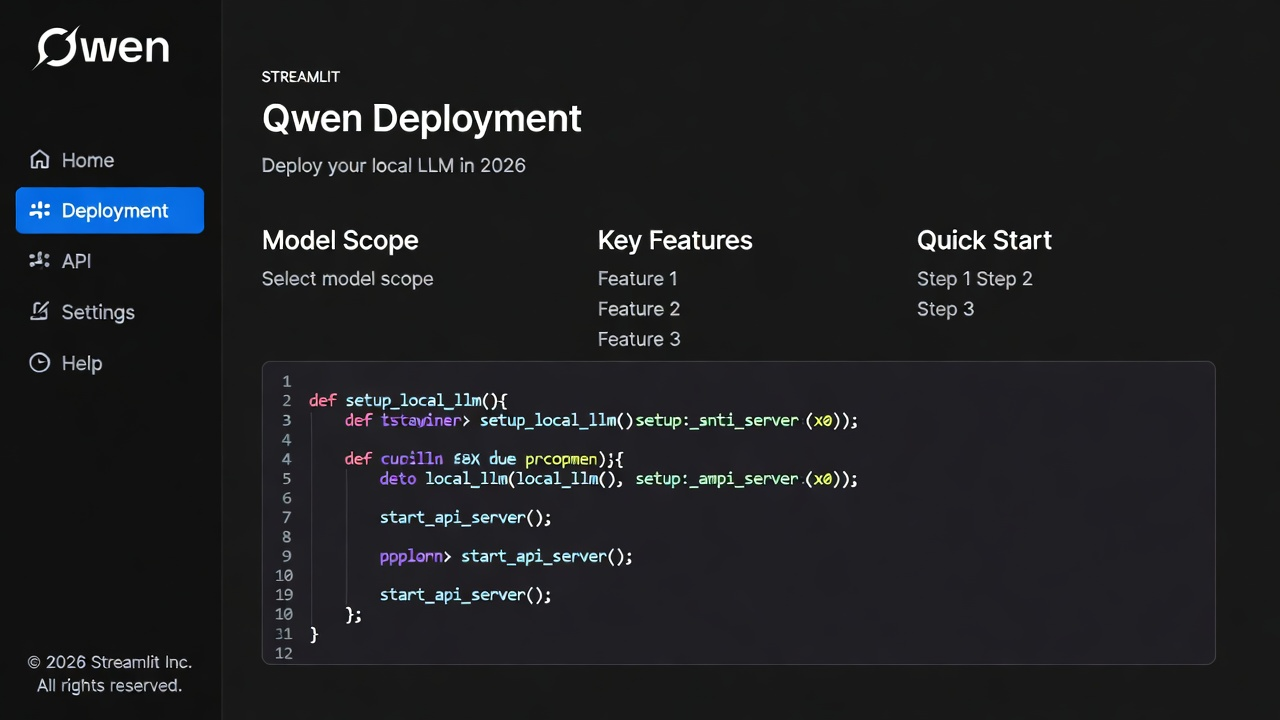

✔ 3)PyTorch + Ascend NPU 插件

近年来兼容性升级非常大:

-

已支持 Llama、Qwen、GLM 全流程训练

-

已支持 Transformer、FlashAttention、Embedding、RMSNorm

-

HuggingFace 官方支持 Ascend

-

Diffusers(SD)也可直接跑

PyTorch + Ascend 现在体验已经非常接近 NVIDIA。

✔ 4)TensorFlow + Ascend 插件

也可用于训练 CV/NLP 模型。

📈 五、910B 的训练能力(真实场景表现)

✔ 1)大模型训练(LLaMA / Qwen / GLM)

官方实测:

-

70B LLM 可在 几十张 910B 上高效训练

-

130B/175B 大模型可在 Atlas 900 集群 上运行

-

支持 FP16/BF16 混合精度

100B 模型训练吞吐量可与 A100 集群接近。

✔ 2)推理性能强(尤其是吞吐场景)

910B 的 FP16 和 INT8 推理性能非常好,适合:

-

大模型推理

-

多并发服务(LLM Serving)

-

在线问答/ChatBot

-

搜索、推荐推理

✔ 3)大规模集群效果优异

Atlas 900 超级集群采用数百〜数千台 910B:

-

已创造 Imagenet、ResNet-269 记录

-

训练速度全球领先

-

在业内高性能榜单中名列前茅

🔍 六、生态兼容性(论文模型基本都能跑)

Ascend 已支持:

✔ NLP 大模型

-

LLaMA 1/2/3

-

Qwen 1/2/2.5

-

ChatGLM 3/4

-

Mistral

-

Bloomz

-

Baichuan

✔ 多模态/图像模型

-

Stable Diffusion

-

CLIP

-

SAM

-

Whisper

-

VITS

✔ 量化方案

-

QLoRA

-

LoRA

-

GPTQ(推理)

-

RTN/PTQ(推理)

兼容性已基本覆盖主流 AI 模型。

🔧 七、910B 服务器有哪些典型配置?

1)Atlas 800 训练服务器(最常见)

-

单机:8×Ascend 910B

-

内部高速互联

-

适合 7B〜70B 模型训练

-

适合科研机构和大模型公司

2)Atlas 300 卡(插卡)

-

单卡版本

-

用于推理或训练小模型

3)Atlas 900 大模型集群

-

数百〜数千张 910B

-

用于千亿〜万亿参数模型训练

这是华为用于盘古大模型的核心集群。

🆚 八、与 NVIDIA A100/H100 对比

下面是简化对比(训练场景):

| 对比项 | Ascend 910B | NVIDIA A100/H100 |

|---|---|---|

| 架构 | Da Vinci | Ampere/Hopper |

| 精度 | FP16/BF16 | BF16/FP8 |

| 算力 | ≈A100,弱于 H100 | A100 中上,H100 最强 |

| 生态 | CANN/MindSpore 强 | CUDA 最强 |

| PyTorch | 兼容好,持续优化 | 完美 |

| 大模型支持 | 全覆盖 | 全覆盖 |

| 国产替代 | ✔ 强 | ✘ |

| 集群 | 强(Atlas 900) | 强(DGX/HGX) |

总结:

-

在国产平台中,910B 最强

-

在国际市场中,可接近 A100

-

综合生态仍在快速进化

🏭 九、适用场景(非常实用)

✔ 1)国产化场景(政府、金融、制造业)

无需依赖国外 GPU 生态。

✔ 2)大模型公司从零开始搭建训练集群

可训练 7B〜100B 的全流程模型。

✔ 3)推理服务(LLM Serving)

高吞吐、低成本。

✔ 4)企业内部 AI 平台

如图像识别、OCR、语音识别、推荐模型等。

✔ 5)高校科研

适用于大规模科学计算。

💡 十、购买与部署建议(经验总结)

✔ 1)必须提前确认的软件栈

-

CANN 版本

-

驱动版本

-

PyTorch NPU 插件版本

-

固件版本

-

MindSpore 版本

-

是否需要 Atlas I/II 代服务器

版本匹配至关重要,否则容易报算子错误或训练中断。

✔ 2)推荐的场景选型

| 场景 | 推荐配置 |

|---|---|

| LLM 7B~13B 微调 | 1–2 台 Atlas 800(8×910B) |

| LLM 30B~70B 训练 | 4–16 台 Atlas 800 |

| 千亿参数训练 | Atlas 900 集群 |

✔ 3)配套依赖

-

高带宽网络(100G/200G IB 或 HCCS)

-

足够的散热

-

大容量存储(NVMe / 分布式存储)

-

集群管理(KubeSphere、MindX、OpenEuler)

📌 十一、未来趋势:910B → 910C → 下一代昇腾

华为正在加速更新:

-

910B 大批量部署

-

第三代 AI 芯片(更接近 H100/H200)

-

MindSpore 3.0 + CANN 新版

-

大模型训练专用算子优化(FlashAttention、MoE)

-

更高效的集群通讯

国产 AI 算力正在快速追赶国际水平。

🏁 十二、全文总结(给读者的 30 秒版本)

Ascend 910B 是目前国产最强的 AI 训练芯片,算力接近 A100,支持所有主流大模型,生态日趋成熟,是国产算力和大模型训练的核心底座。

如果你的公司:

-

做大模型

-

想降低算力成本

-

需要国产化适配

-

想搭建私有云或 AI 平台

那么 910B 是目前最值得选择的国产 AI 服务器平台。