12GB显存也能“起飞”!RTX 3060服务器上的7B LLM“边缘”部署与功耗优化实战

本文将带你深入探索,如何在NVIDIA RTX 3060 (12GB) 服务器上,通过4-bit量化和vLLM推理引擎,成功部署70亿参数的Qwen1.5-7B-Chat模型。我将详细拆解从模型优化、高性能推理到功耗实时监控的全过程,并分享在资源受限环境下实现LLM高效推理的关键策略与实战经验,最终展示RTX 3060作为“高性能边缘节点”的强大潜力。

一、消费级GPU,大模型边缘部署的“潜力股”

各位AI爱好者们,大家好!随着大模型技术的飞速发展,将LLM部署到离用户更近的“边缘”设备,以实现低延迟、高隐私、节省云成本的需求日益增长。然而,真正的边缘设备(如Jetson系列)性能有限,而云端服务器又过于昂贵。

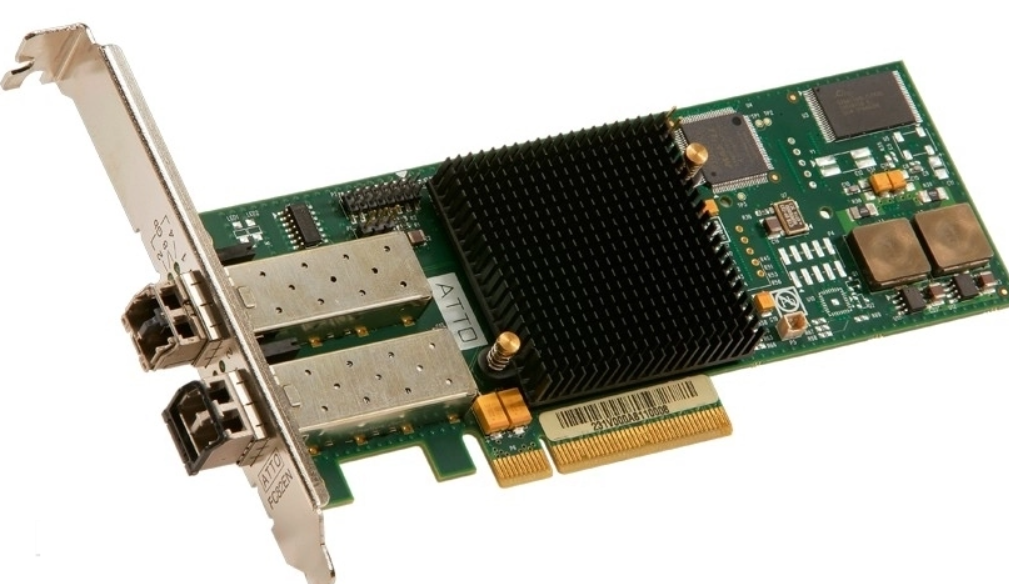

那么,像我们手中的 NVIDIA RTX 3060 (12GB) 这样的消费级GPU服务器,能否在两者之间找到一个平衡点,成为一个理想的“高性能边缘节点”呢?它拥有比嵌入式设备更强的计算力,同时又比数据中心更具成本效益和部署灵活性。

本周,我便在恒源云的RTX 3060服务器上,挑战了这一命题:部署一个70亿参数的LLM,并实现高性能推理与功耗监控。

二、核心挑战:12GB显存,如何驾驭7B大模型?

70亿参数的Qwen1.5-7B-Chat模型,即使是半精度FP16,也需要约14GB的显存。对于12GB的RTX 3060来说,这无疑是巨大的挑战。

我的解决方案:4-bit量化 + vLLM推理引擎

4-bit量化: 我采用了 BitsAndBytes的4-bit量化技术。它能将7B模型的权重从约14GB压缩到约3.5-4GB,使其能够完全加载到12GB的R