AI智能棋盘通过Kontron SMARC-sAMX8部署边缘服务器AI

AI智能棋盘通过Kontron SMARC-sAMX8部署边缘服务器AI

你有没有想过,一张普通的棋盘,也能“看”懂你的每一步走法?甚至还能在你犹豫时悄悄亮起LED提示最佳落子位置——不是靠云端来回传输数据,而是 就在这块巴掌大的嵌入式模块上,本地完成所有AI推理 。🤖✨

这听起来像科幻?其实它已经来了。而且核心硬件,正是来自工业级嵌入式领域的“隐形冠军”—— Kontron SMARC-sAMX8 。

想象这样一个场景:一个孩子正在家里的国际象棋棋盘前思考下一步该怎么走。他刚把“马”跳到某个格子,棋盘边缘的摄像头瞬间捕捉画面,不到0.1秒后,对面角落的一颗小灯亮了——那是AI建议的回应走法。整个过程 没有联网、没有延迟卡顿、也没有隐私泄露风险 。这一切的背后,是一套高度集成的 边缘AI系统 在默默运行。

而支撑这套系统的“大脑”,就是那块只有名片大小的 SMARC-sAMX8 模块 。

为什么非得是边缘AI?

传统做法是把图像传到云端,让强大的GPU集群跑模型识别棋子,再把结果返回设备。听上去很美,但现实很骨感:

- 🕳️ 网络延迟动辄几百毫秒,用户体验像在和机器人“打电话下棋”;

- 🔐 用户对弈数据上传存在隐私隐患,尤其涉及儿童或专业选手;

- 🌐 一旦断网,整套系统直接“瘫痪”。

所以,真正的智能化设备必须做到: 看得清、算得快、离得近 。这就引出了我们今天的主角—— 边缘AI计算平台 。

而 Kontron 的 SMARC-sAMX8,恰好踩中了这个技术趋势的关键节点。

这块模块到底有什么特别?先来看它的“硬实力”👇

它基于 NXP i.MX8M Plus 处理器打造,别看体积只有 82mm × 50mm ,却集成了四核 Cortex-A53 + 单核 Cortex-M7 实时控制器,最关键的是——自带一个 2.3 TOPS 算力的专用NPU(神经网络处理单元) !💥

这意味着什么?意味着你可以在这个功耗仅 2~4W 的小家伙上,流畅运行轻量级 CNN 模型,比如用于图像分类的 MobileNetV2 或定制化 ResNet 变体,完全不需要外挂 GPU。

更贴心的是,它原生支持 TensorFlow Lite 和 OpenVINO 推理框架,并可通过 Vela 工具链对模型进行量化优化,完美匹配其 NPU 架构。换句话说,开发者不用从零造轮子,拿来就能跑 AI。

💡 小知识:很多开发者以为边缘AI只能靠树莓派+USB加速棒,但实际上这类消费级方案稳定性差、生命周期短。相比之下,SMARC-sAMX8 是工业级设计,承诺 10年以上供货周期 ,EMC抗干扰强,适合产品化落地。

那么问题来了:这块“神U”是怎么在一个智能棋盘里施展拳脚的?

我们来拆解一下整个系统的运作流程:

当用户移动一枚棋子时,棋盘内置的 MIPI CSI 接口摄像头(如 OV5640) 被触发拍摄当前画面。图像数据通过 DMA 直接送入内存,避免 CPU 干预。紧接着,一段 GStreamer pipeline 完成去噪、ROI裁剪和透视校正,确保输入模型的画面规整统一。

然后重点来了——预处理后的图像被送入一个 8-bit量化的TFLite模型 ,这个模型只有约 5MB大小 ,却能在 NPU 加速下实现 <80ms 的端到端推理延迟 !🎯

输出结果是一个 8x8 的类别矩阵(每个格子对应“空”、“黑兵”、“白后”等),结合上一帧状态,系统就能判断出本次移动是从哪到哪。之后调用本地 MiniMax 引擎生成应对策略,最后通过 GPIO 控制 LED 高亮目标格,或者通过 I2S 输出语音提示。

整个闭环, 全部发生在设备本地 ,连 Wi-Fi 都可以关闭!

当然,理想很丰满,实际工程中总有各种“坑”。比如:

🌞 光照不均怎么办?

→ 解决方案:加入环境光传感器 + 补光LED闭环控制,配合多帧平均与自适应直方图均衡,显著提升识别鲁棒性。

🧠 边缘设备算力不够?

→ 模型压缩三件套:剪枝 + 量化 + 知识蒸馏。最终使用 int8 量化模型,启用 NPU delegate,推理速度直接起飞。

👶 孩子频繁误触怎么办?

→ 加入手势过滤逻辑:短时间内连续多次触发视为无效操作,防止状态错乱。

🔄 固件升级失败变砖?

→ 底层支持 A/B 分区 OTA,升级失败自动回滚,保障系统可靠性。

这些细节看似琐碎,却是决定产品能否走出实验室、走进千家万户的关键。

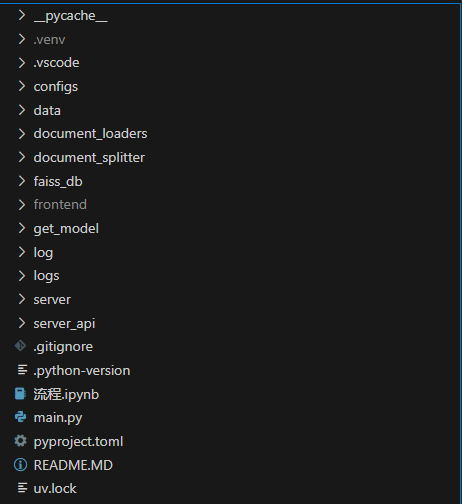

再来看看整体架构,三层结构清晰分明:

graph TD

A[感知层] -->|图像/信号输入| B(边缘计算层)

B -->|控制指令| C[应用与通信层]

subgraph A [感知层]

A1(MIPI摄像头)

A2(磁阻传感器阵列)

A3(环境光传感器)

end

subgraph B [边缘计算层]

B1[Kontron SMARC-sAMX8]

B2[Yocto Linux + Wayland GUI]

B3[TensorFlow Lite + NPU Delegate]

B4[GStreamer 视频流水线]

end

subgraph C [应用与通信层]

C1[BLE 5.0 → 手机App]

C2[Wi-Fi → 私有云同步]

C3[HTTP Server REST API]

C4[UART调试接口]

end

是不是有种“麻雀虽小,五脏俱全”的感觉?📷📡💡

而且扩展性极强。今天是国际象棋,明天换套模型就能变成围棋盘;加个麦克风阵列,还能实现语音交互;接上 PoE 供电,连电源线都省了,直接网线取电搞定。

说到这儿,不得不提几个让人眼前一亮的设计实践:

🔧 模型转换实战示例 :

如果你有一个训练好的 Keras 模型,想让它在 SMARC-sAMX8 上跑得飞快,记得这么做:

tflite_convert

--keras_model_file=model.h5

--output_file=model_quant.tflite

--quantize_to_int8

--inference_input_type=uint8

--inference_output_type=uint8

--representative_dataset=rep_data_gen

接着用 NXP 官方的 Vela 编译器 进一步优化,生成专为 i.MX8M Plus NPU 定制的二进制文件,性能提升可达 3 倍以上!

💾 内存管理技巧 :

- 把 AI 模型常驻 DDR,避免反复从 eMMC 加载;

- 使用 Linux cgroups 限制日志服务等后台进程资源占用;

- 开启 CPUFreq 动态调频,在待机时降频节能。

🔥 散热小心机 :

虽然最大功耗才 3.8W,但为了长期稳定运行,建议底板至少双层 PCB,关键区域大面积铺铜散热。测试表明,良好散热能让 NPU 持续满负荷工作而不降频。

🔐 安全也不能马虎 :

- 启用 Secure Boot 防止固件被篡改;

- 关闭默认开启的 SSH 服务;

- 所有对外接口加 iptables 防火墙规则;

- 若需更高安全等级,可模拟 TPM 存储密钥。

这种“小而精”的边缘AI模式,带来的不仅是技术突破,更是应用场景的无限延展。

试想:

- 在特殊教育学校,视障学生可以通过语音导航+震动反馈,在物理棋盘上独立对弈;

- 在商场角落设置无人值守的“AI对战亭”,扫码即可挑战不同难度AI;

- 在智慧零售场景,类似架构可用于自动识别货架商品摆放是否合规;

- 工业质检一线,微型缺陷检测终端随时待命,无需连接中心服务器。

未来,随着 TinyML 技术的发展,我们甚至可能看到 指甲盖大小的AI模组 ,嵌入更多日常物品中。而像 SMARC-sAMX8 这样的标准化模块,正在为这场变革铺路搭桥。

说到底,真正的智能,不该依赖云端的“施舍”,而应扎根于设备本身。🌟

Kontron SMARC-sAMX8 不只是一个硬件模块,它代表了一种理念: 把AI的能力下沉到最靠近用户的终端,用工业级的可靠性和能效比,打造出真正可用、好用、耐用的智能产品 。

或许不久的将来,每一副棋盘、每一块黑板、每一个玩具,都能拥有自己的“思考能力”。而这一切的起点,也许就是你现在手中这块小小的 SoM 模块。🔌🧠♟️

“边缘不是边缘,而是未来的中心。” —— 当AI学会在本地“睁眼”,世界才真正开始智能化。