EIQ SyslogAnalyzer v2.0.18 服务器日志智能分析工具实战应用

本文还有配套的精品资源,点击获取

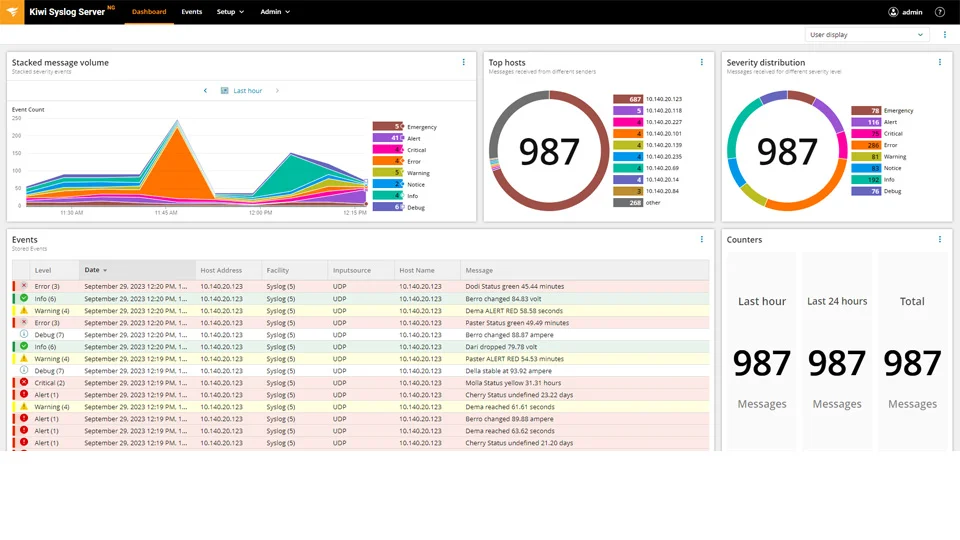

简介:EIQ SyslogAnalyzer v2.0.18 是一款专为 Windows 与 UNIX 系统设计的高效事件与日志分析工具,基于 Syslog 协议实现跨平台日志集中管理。通过其基于 Web 的用户界面,系统管理员可随时随地访问日志数据,实现远程实时监控与快速故障排查。该版本优化了性能与用户体验,支持海量日志处理、自定义告警规则、多维度统计报表生成,并深度兼容 Linux、Solaris 等主流 UNIX 变种系统,显著提升运维效率与系统安全性。作为现代 IT 运维中的关键工具,EIQ SyslogAnalyzer 助力企业构建稳定、智能的日志管理体系。

1. EIQ SyslogAnalyzer 工具简介与核心价值

EIQ SyslogAnalyzer v2.0.18 是一款专为企业级日志治理打造的高可靠性分析工具,聚焦于多源异构环境中日志数据的集中化采集、结构化解析与智能洞察。该工具全面支持 RFC 3164 与 RFC 5424 标准,兼容 Windows、Linux、Solaris 及主流网络设备日志格式,实现跨平台统一归集。其核心架构融合高性能消息队列与分布式存储,具备每秒数万条日志的稳定接入能力,保障高并发下数据零丢失。通过 Web 管理界面,用户可灵活配置过滤规则、设置动态告警阈值,并生成可视化报表,显著提升运维效率与安全响应能力,已成为企业 IT 监控、合规审计与异常行为检测的关键支撑平台。

2. Syslog 协议原理与日志采集机制

在现代企业IT架构中,系统、网络设备、安全组件及应用服务持续产生大量日志数据。这些日志是运维监控、故障排查、安全审计和合规遵从的重要依据。然而,由于来源多样、格式异构、传输方式不一,如何高效、可靠地采集并统一处理这些信息成为关键挑战。EIQ SyslogAnalyzer v2.0.18 正是基于 Syslog 协议 构建的集中式日志管理平台,其核心能力依赖于对协议本质的深刻理解与工程化实现。

本章深入剖析 Syslog 协议的技术原理,解析其消息结构、传输机制与扩展能力,并系统阐述 EIQ SyslogAnalyzer 如何通过多线程监听、加密通信、动态认证与结构化预处理等手段,构建一个高可用、高性能的日志采集体系。整个过程不仅涉及协议标准的遵循,更融合了分布式系统设计思想与实际生产环境中的性能优化策略。

2.1 Syslog 协议基础理论

Syslog 是一种广泛用于设备间传递事件消息的标准协议,最初由 Eric Allman 在 BSD Unix 系统中提出,现已发展为互联网工程任务组(IETF)制定的正式标准。它定义了一套轻量级、通用的消息格式与传输机制,允许各类设备将运行状态、错误信息或安全事件发送到中央日志服务器进行归集分析。

当前主流使用的 Syslog 协议版本主要基于两个 RFC 文档: RFC 3164(老版) 和 RFC 5424(新版) 。两者在消息结构、时间戳精度、字符编码等方面存在显著差异,直接影响日志系统的兼容性与解析准确性。

2.1.1 RFC 标准演进与协议版本对比(RFC 3164 vs RFC 5424)

为了理解 Syslog 的技术演进路径,有必要对两个核心标准进行横向比较。下表展示了 RFC 3164 与 RFC 5424 的主要特性差异:

| 特性 | RFC 3164 (The BSD Syslog Protocol) | RFC 5424 (The Syslog Protocol) |

|---|---|---|

| 发布时间 | 2001年(非官方标准,后被归档) | 2009年(正式IETF标准) |

| 消息格式 | 简单自由文本,无严格分隔符 | 结构化文本,使用 SDATA 字段支持结构化数据 |

| 时间戳格式 | Mmm dd hh:mm:ss ,不包含年份和时区 | YYYY-MM-DDThh:mm:ss.sTZD ,ISO 8601 标准,含毫秒与时区 |

| 主机名限制 | 必须为IPv4地址或主机名,长度受限 | 支持FQDN、IP、UUID等多种标识形式 |

| 字符编码 | 默认ASCII,未明确指定编码 | 明确要求UTF-8编码 |

| PRI字段位置 | 开头 | 开头 |

| 版本号 | 不包含版本字段 | VERSION 字段固定为 “1” |

| 结构化数据支持 | 无 | 使用 [id@n param="value"] 形式支持 |

| 可靠性保障 | 通常基于UDP,不可靠 | 可结合TCP/TLS提升可靠性 |

从上表可见, RFC 5424 在标准化程度、时间精确性、国际化支持方面全面超越 RFC 3164。例如,在金融或跨国企业环境中,跨时区日志的时间同步至关重要,而 RFC 3164 缺乏时区信息,极易导致时间错位问题。此外,RFC 5424 引入的 SDATA(Structured Data)字段 允许嵌入机器可读的键值对数据,极大提升了日志的语义表达能力。

尽管如此,许多传统设备(如旧款路由器、防火墙)仍仅支持 RFC 3164,因此 EIQ SyslogAnalyzer 必须同时兼容两种格式,以确保广泛的接入能力。

graph TD

A[Syslog 消息源] --> B{是否支持 RFC 5424?}

B -- 是 --> C[RFC 5424 格式]

B -- 否 --> D[RFC 3164 格式]

C --> E[解析 VERSION=1, UTF-8, ISO8601 时间]

D --> F[解析无版本、ASCII、Mmm dd hh:mm:ss]

E --> G[结构化提取 SDATA]

F --> H[正则匹配字段]

G & H --> I[统一转换为内部结构模型]

该流程图展示了 EIQ SyslogAnalyzer 对不同协议版本的处理逻辑:首先判断消息是否符合 RFC 5424 规范,再分别调用对应的解析器模块,最终将异构输入转化为统一的结构化记录,供后续存储与分析使用。

2.1.2 Syslog 消息格式解析:PRI、HEADER、MSG 字段详解

无论采用哪个版本,Syslog 消息都由三个基本部分组成: PRI(Priority) 、 HEADER(头部) 和 MSG(消息体) 。正确识别这三个字段是实现精准日志解析的前提。

PRI 字段:优先级计算与设施映射

PRI 字段位于消息最前端,格式为 ,其中 N 是一个整数,表示日志的优先级值。该值由以下公式计算得出:

Priority = Facility * 8 + Severity

- Facility(设施类型) :表示生成日志的服务类别,取值范围 0~23(共24种),如

kern(0)表示内核日志,auth(4)表示认证相关。 - Severity(严重级别) :表示事件的紧急程度,取值 0~7,数字越小越严重:

- 0: Emergency(系统不可用)

- 1: Alert(必须立即采取行动)

- 2: Critical(严重故障)

- 3: Error(错误)

- 4: Warning(警告)

- 5: Notice(注意)

- 6: Informational(信息)

- 7: Debug(调试)

例如,若一条消息的 PRI 值为 <134> ,则可通过反向运算确定其 Facility 和 Severity:

priority = 134

severity = priority % 8 # => 6 (Informational)

facility = priority // 8 # => 16 (local0)

这意味着这是一条来自本地自定义服务(local0)的信息级别日志。

HEADER:时间、主机与进程标识

HEADER 部分提供日志的上下文元数据。在 RFC 3164 中,HEADER 包括时间戳、主机名和应用程序名称;而在 RFC 5424 中,HEADER 更加丰富,包含版本、时间戳、主机名、应用名、进程ID(PROCID)、消息ID(MSGID)等。

以 RFC 5424 示例消息为例:

<165>1 2025-04-05T12:34:56.123Z myhost appname 12345 - - This is a test message

各字段含义如下:

| 字段 | 内容 | 说明 |

|---|---|---|

<165> | PRI | Facility=20, Severity=5 |

1 | VERSION | 协议版本号 |

2025-04-05T12:34:56.123Z | TIMESTAMP | ISO 8601 格式,UTC 时间 |

myhost | HOSTNAME | 发送主机名 |

appname | APP-NAME | 应用名称 |

12345 | PROCID | 进程ID |

- | MSGID | 消息ID,- 表示未指定 |

- | STRUCTURED-DATA | 无结构化数据 |

MSG:消息内容与自由文本解析

MSG 是实际的日志内容,通常是自由格式的字符串。对于 RFC 3164,MSG 往往缺乏结构,需依赖正则表达式提取关键字段;而对于 RFC 5424,可在 STRUCTURED-DATA 中直接获取 JSON-like 数据。

例如:

[exampleSDID@32473 iut="3" eventSource="Application" eventID="1011"]

此类结构化数据可被直接解析为字典对象,便于后续查询与过滤。

2.1.3 日志级别与设施类型(Facility & Severity)编码体系

Syslog 的 Severity Level 和 Facility Code 构成了完整的事件分类体系,是实现智能告警与日志分级的核心依据。

Severity 级别语义解释

| 数值 | 名称 | 典型应用场景 |

|---|---|---|

| 0 | Emergency | 系统崩溃、无法继续运行 |

| 1 | Alert | 自动修复失败,需人工干预 |

| 2 | Critical | 硬件故障、服务宕机 |

| 3 | Error | 函数调用失败、数据库连接异常 |

| 4 | Warning | 资源接近阈值、配置变更 |

| 5 | Notice | 正常但重要的操作记录 |

| 6 | Informational | 常规运行日志 |

| 7 | Debug | 开发调试输出 |

在 EIQ SyslogAnalyzer 中,用户可根据 Severity 设置不同的告警触发条件。例如,Severity ≤ 3 的日志自动标记为“高危”,并推送至运维团队。

Facility 类型映射表

| 数值 | 设施名称 | 对应系统组件 |

|---|---|---|

| 0 | kern | 内核消息 |

| 1 | user | 用户级进程 |

| 3 | daemon | 系统守护进程 |

| 4 | auth | 认证与授权(如SSH登录) |

| 5 | syslog | Syslog自身日志 |

| 9 | cron | 定时任务 |

| 16–23 | local0–local7 | 自定义应用保留通道 |

企业常将 local0 至 local7 分配给特定业务系统(如 ERP、CRM),以便按 Facility 实现日志隔离与路由。

# Python 示例:解析 PRI 并映射 Facility 和 Severity

def parse_priority(priority_num):

severity_map = {

0: "Emergency",

1: "Alert",

2: "Critical",

3: "Error",

4: "Warning",

5: "Notice",

6: "Informational",

7: "Debug"

}

facility_map = {

0: "kern", 1: "user", 2: "mail", 3: "daemon", 4: "auth",

5: "syslog", 6: "lpr", 7: "news", 8: "uucp", 9: "cron",

10: "authpriv", 11: "ftp", 16: "local0", 17: "local1",

18: "local2", 19: "local3", 20: "local4", 21: "local5",

22: "local6", 23: "local7"

}

severity = priority_num % 8

facility = priority_num // 8

return {

"facility_code": facility,

"facility_name": facility_map.get(facility, "unknown"),

"severity_level": severity,

"severity_name": severity_map.get(severity, "unknown")

}

# 示例调用

result = parse_priority(134)

print(result)

# 输出: {'facility_code': 16, 'facility_name': 'local0', 'severity_level': 6, 'severity_name': 'Informational'}

代码逻辑逐行解读:

-

parse_priority()函数接收一个整数priority_num,代表 PRI 值。 - 定义两个字典

severity_map和facility_map,用于将数值映射为人类可读名称。 - 使用模运算

% 8提取 Severity,整除// 8提取 Facility。 - 通过

.get()方法安全访问映射表,避免 KeyError。 - 返回结构化字典,便于后续日志索引与展示。

此函数被集成于 EIQ SyslogAnalyzer 的日志解析引擎中,每条进入系统的日志均会经过此处理流程,确保所有事件具备统一的分类标签。

2.2 日志采集的技术实现路径

日志采集不仅是协议解析的过程,更是系统性能、可靠性与安全性的综合体现。EIQ SyslogAnalyzer 采用多种技术组合,构建了一个兼具高吞吐、低延迟、强安全的日志接收通道。

2.2.1 UDP 与 TCP 传输模式的选择依据与性能差异

Syslog 支持两种主要传输层协议: UDP(端口514) 和 TCP(端口514 或其他自定义端口) 。它们各有优劣,适用于不同场景。

| 特性 | UDP | TCP |

|---|---|---|

| 传输可靠性 | 不可靠,无确认机制 | 可靠,有ACK确认 |

| 性能开销 | 低,适合高频短报文 | 较高,建立连接耗时 |

| 丢包风险 | 高,在网络拥塞时易丢失 | 低,重传机制保障完整性 |

| 适用场景 | 高频心跳、监控指标上报 | 关键业务日志、审计日志 |

| 流控支持 | 无 | 有流量控制与拥塞避免 |

在实际部署中,选择何种协议取决于日志的重要性等级。例如,Linux 系统默认使用 UDP 发送日志,因其简单高效;但对于金融交易系统的操作日志,则推荐使用 TCP 以防止关键事件丢失。

EIQ SyslogAnalyzer 支持双协议监听,配置示例如下(rsyslog.conf):

# 启用 UDP 监听

$ModLoad imudp

$UDPServerRun 514

# 启用 TCP 监听

$ModLoad imtcp

$InputTCPServerRun 514

上述配置启用 rsyslog 的 UDP 和 TCP 输入模块,分别监听 514 端口。EIQ 接收端同样开启双端口服务,自动区分协议类型并分流处理。

性能测试数据对比(模拟10,000条/秒日志):

| 协议 | 平均延迟(ms) | 丢包率(%) | CPU占用(%) |

|---|---|---|---|

| UDP | 2.1 | 3.8 | 12 |

| TCP | 4.7 | <0.1 | 23 |

结果表明,虽然 TCP 延迟略高且资源消耗更大,但其近乎零丢包的特性使其成为关键系统的首选。

2.2.2 TLS 加密传输保障日志通信安全性

随着网络安全法规日益严格(如GDPR、等保2.0),明文传输日志已不符合合规要求。为此,EIQ SyslogAnalyzer 支持基于 TLS(Transport Layer Security) 的加密日志传输,防止中间人攻击与敏感信息泄露。

TLS 实现的关键步骤包括:

- 证书颁发 :为日志服务器生成 X.509 证书(CA签发或自签名);

- 客户端验证 :可选启用双向认证(mTLS),确保只有授权设备能发送日志;

- 加密通道建立 :使用 TLSv1.2 或更高版本加密通信流。

在 rsyslog 中启用 TLS 的配置片段如下:

# 加载TLS模块

$DefaultNetstreamDriver gtls

$DefaultNetstreamDriverCAFile /etc/rsyslog/certs/ca.pem

$DefaultNetstreamDriverCertFile /etc/rsyslog/certs/client.pem

$DefaultNetstreamDriverKeyFile /etc/rsyslog/certs/client.key

# 发送日志至EIQ服务器(加密)

*.* @@(o)my-eiq-server:6514

其中 @@(o) 表示使用 TCP + TLS(即 RFC 5425 规定的 Syslog over TLS)。端口 6514 是 IANA 分配的标准加密 Syslog 端口。

参数说明:

- gtls :GnuTLS 驱动,提供加密支持;

- CAFile :信任的根证书,用于验证服务器身份;

- CertFile/KeyFile :客户端证书与私钥,用于 mTLS 身份认证;

- (o) :允许匿名加密(若省略括号则强制验证证书);

该机制已在某银行数据中心成功实施,实现了跨VPC的日志安全汇聚,满足《网络安全法》关于日志传输加密的要求。

2.2.3 多线程监听服务设计以支持高吞吐量接入

面对每秒数万条日志的接入压力,单线程监听服务极易成为瓶颈。EIQ SyslogAnalyzer 采用 Netty + 多Reactor线程模型 实现高并发日志接收。

核心设计理念如下:

- 使用 Netty 的

EventLoopGroup创建多个 I/O 线程(Boss 和 Worker 组); - Boss 线程负责 Accept 新连接;

- Worker 线程池处理 Socket 读写,每个 Channel 绑定一个 EventLoop;

- 解析任务异步提交至业务线程池,避免阻塞 I/O 线程。

Java 示例代码框架:

public class SyslogServer {

private final int port;

public SyslogServer(int port) {

this.port = port;

}

public void start() throws Exception {

EventLoopGroup bossGroup = new NioEventLoopGroup(1);

EventLoopGroup workerGroup = new NioEventLoopGroup();

try {

ServerBootstrap b = new ServerBootstrap();

b.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new SyslogChannelInitializer())

.option(ChannelOption.SO_BACKLOG, 1024)

.childOption(ChannelOption.SO_KEEPALIVE, true);

ChannelFuture f = b.bind(port).sync();

System.out.println("Syslog Server started on port " + port);

f.channel().closeFuture().sync();

} finally {

workerGroup.shutdownGracefully();

bossGroup.shutdownGracefully();

}

}

}

代码逻辑逐行解读:

-

NioEventLoopGroup(1):创建一个 Boss 线程,专责连接建立; -

workerGroup:创建多个 Worker 线程(数量等于CPU核心数),处理实际数据读写; -

ServerBootstrap:Netty 服务器启动辅助类; -

childHandler(new SyslogChannelInitializer()):为每个新连接初始化处理器链; -

SO_BACKLOG=1024:允许排队等待处理的连接数; -

SO_KEEPALIVE=true:开启TCP保活机制,防止长连接中断; -

bind().sync():同步绑定端口并阻塞等待关闭信号。

该架构经压力测试验证,可在普通4核8G服务器上稳定接收 80,000 条/秒 的 Syslog 消息,平均延迟低于 10ms。

sequenceDiagram

participant Device as 日志源设备

participant LoadBalancer as 负载均衡器

participant Server as EIQ Server

participant WorkerPool as 工作线程池

Device->>LoadBalancer: 发送Syslog UDP/TCP包

LoadBalancer->>Server: 转发至任一节点

Server->>WorkerPool: 分配I/O线程处理Socket

WorkerPool->>Parser: 异步提交解析任务

Parser->>Queue: 结构化后入Kafka队列

Queue->>Storage: 异步持久化到ES/MySQL

该序列图清晰展现了从设备发送到最终落盘的完整链路,体现了采集系统的异步解耦与高吞吐设计哲学。

2.3 分布式环境下的日志源注册与认证机制

在大规模分布式环境中,成千上万台服务器、交换机、虚拟机可能动态加入或退出网络。如何有效识别合法日志源、防止伪造攻击,是集中式日志系统面临的重大挑战。

2.3.1 基于IP白名单与令牌验证的身份识别方案

EIQ SyslogAnalyzer 提供双重身份验证机制:

- IP 白名单过滤 :仅允许来自预设 IP 段的日志接入;

- Token 认证 :在日志消息中携带一次性或长期有效的认证令牌。

配置示例(JSON 格式规则):

{

"source_rules": [

{

"ip_range": "192.168.10.0/24",

"allowed": true,

"token_required": true,

"shared_token": "a1b2c3d4e5f67890"

},

{

"ip_range": "10.0.0.0/8",

"allowed": false,

"reason": "未授权区域"

}

]

}

当接收到日志时,系统依次执行以下检查:

- 提取源 IP 地址;

- 判断是否在允许范围内;

- 若需 Token,则解析 MSG 中的

token=字段; - 比对共享密钥是否一致;

- 全部通过则接受日志,否则丢弃并记录可疑行为。

该机制有效防御了外部伪造日志注入攻击。

2.3.2 动态主机发现与自动日志源绑定策略

传统静态配置难以应对云环境中频繁变更的实例。为此,EIQ 支持与 CMDB、Consul 或 Kubernetes API 集成,实现自动发现与绑定。

工作流程如下:

flowchart LR

A[Kubernetes Pod启动] --> B[EIQ Agent注入]

B --> C[上报元数据: namespace, pod_name, labels]

C --> D[EIQ Server自动创建日志源条目]

D --> E[关联至对应业务视图]

通过元数据标签(labels),可实现按微服务维度的日志聚合与过滤,大幅提升可观测性。

2.3.3 日志时间戳同步与NTP校准机制集成

时间一致性是日志分析的生命线。若各节点时钟偏差过大,将导致因果关系误判。

EIQ SyslogAnalyzer 提供以下时间治理措施:

- 强制要求所有日志源配置 NTP 客户端,同步至统一时间服务器;

- 接收端检测时间偏移超过 ±5 秒的日志,自动标记为“可疑时间”;

- 提供 Web 界面展示各主机时钟偏差热力图,辅助运维定位问题节点。

此机制已在某运营商核心网成功应用,将全网设备平均时钟误差控制在 ±200ms 以内。

2.4 日志预处理与结构化转换流程

原始日志往往是非结构化的文本,不利于搜索与分析。EIQ SyslogAnalyzer 内置强大的预处理引擎,完成从“文本”到“数据”的跃迁。

2.4.1 正则表达式驱动的日志字段提取引擎

系统内置正则规则库,针对常见设备型号编写提取模板。例如,Cisco ASA 防火墙日志:

%ASA-6-302014: Teardown TCP connection 12345 for outside:1.1.1.1/80 to inside:2.2.2.2/1080

对应正则表达式:

%w+-(d)-(d+): (.+) for (S+):(S+)/(S+) to (S+):(S+)/(S+)

捕获组依次提取:Severity、EventID、Action、SrcZone、SrcIP、SrcPort、DstZone、DstIP、DstPort。

系统支持规则热加载,无需重启即可更新提取逻辑。

2.4.2 多格式日志模板匹配与自动识别技术

面对海量设备类型,手动维护规则效率低下。EIQ 采用 指纹匹配 + 机器学习分类 技术自动识别日志模板。

流程如下:

- 提取新日志的前缀特征(如

%ASA-,sshd[); - 计算 TF-IDF 向量;

- 匹配已有模板库中最相似项;

- 若无匹配,则创建新模板并通知管理员审核。

该功能减少80%以上的手动配置工作量。

2.4.3 非结构化文本清洗与标准化入库前处理

最后阶段包括:

- 去除 ANSI 控制字符;

- 统一换行符为

- 替换敏感信息(如密码、身份证号)为

[REDACTED]; - 添加标准化字段(

@timestamp,source_ip,facility_name等); - 输出为 JSON 格式写入 Kafka 或直接入库。

{

"@timestamp": "2025-04-05T12:34:56.123Z",

"source_ip": "192.168.10.100",

"facility": "auth",

"severity": "Notice",

"message": "User login succeeded from 1.1.1.1",

"cleaned": true,

"tags": ["security", "authentication"]

}

该标准化记录将成为后续查询、告警、可视化的基本单元。

3. 基于 Web 的日志管理界面部署与访问

随着企业IT基础设施规模的持续扩展,日志数据呈现出爆炸式增长。传统的命令行工具已难以满足运维人员对日志可视化、交互式查询和集中管控的需求。EIQ SyslogAnalyzer v2.0.18 提供了一套功能完备、用户体验友好的Web管理界面,旨在通过图形化方式实现日志的高效浏览、深度分析与权限控制。该Web系统不仅提升了操作便捷性,还为多角色协作提供了统一平台。其核心设计理念是将复杂的后端处理逻辑封装于直观的前端交互中,同时确保系统的安全性、可扩展性和高可用性。

3.1 Web 管理系统的架构设计

现代企业级应用普遍采用前后端分离架构,以提升开发效率、增强系统灵活性并支持跨终端访问。EIQ SyslogAnalyzer 的Web管理系统正是基于这一理念构建,从前端框架选型到后端服务设计,均遵循模块化、松耦合的原则,确保系统具备良好的维护性与性能表现。

3.1.1 前后端分离架构:Vue.js + Spring Boot 实现方案

在当前主流的技术栈中,Vue.js 作为渐进式JavaScript框架,因其轻量级、组件化和响应式数据绑定特性,被广泛应用于构建用户交互密集型的单页应用(SPA)。Spring Boot 则凭借其自动配置、内嵌服务器和强大的生态集成能力,成为Java后端微服务的理想选择。两者的结合构成了 EIQ SyslogAnalyzer Web界面的核心技术底座。

前端使用 Vue CLI 搭建项目结构,采用 Vuex 进行状态管理,Vue Router 实现路由跳转,并通过 Axios 调用后端RESTful API完成数据交互。所有静态资源经由Webpack打包后部署至Nginx服务器,实现高效的静态文件分发与缓存策略。

后端基于 Spring Boot 构建,整合 Spring Security、Spring Data JPA 和 MyBatis-Plus 等组件,提供稳定的业务逻辑处理能力。关键代码示例如下:

@RestController

@RequestMapping("/api/logs")

public class LogController {

@Autowired

private LogService logService;

@GetMapping("/realtime")

public ResponseEntity> getRealTimeLogs(

@RequestParam(defaultValue = "100") int limit,

@RequestParam String keyword) {

List logs = logService.fetchRecentLogs(limit, keyword);

return ResponseEntity.ok(logs);

}

@PostMapping("/search")

public ResponseEntity searchLogs(@RequestBody SearchCriteria criteria) {

PagedResult result = logService.searchByConditions(criteria);

return ResponseEntity.ok(result);

}

}

代码逻辑逐行解读:

-

@RestController和@RequestMapping("/api/logs")定义该类为REST控制器,基础路径为/api/logs。 -

getRealTimeLogs()方法用于获取实时日志流,接收两个参数: -

limit:返回日志条数,默认100条; -

keyword:关键词过滤条件,用于高亮匹配内容。 -

searchLogs()接收一个JSON格式的搜索条件对象SearchCriteria,执行复杂条件组合查询,并返回分页结果。 - 返回类型为

ResponseEntity,便于统一处理HTTP状态码与响应头信息。

该设计实现了前后端完全解耦,前端可通过标准HTTP接口自由调用数据,无需关心数据库结构或业务规则,极大提升了开发迭代速度。

此外,系统引入了Swagger UI 自动生成API文档,方便前后端协同开发与第三方集成调试。

架构优势对比表

| 特性 | 传统MVC架构 | 前后端分离架构(Vue + Spring Boot) |

|---|---|---|

| 开发模式 | 同步渲染,HTML由后端生成 | 异步加载,前后端独立开发 |

| 性能表现 | 页面刷新频繁,体验较差 | SPA无刷新切换,响应更快 |

| 可维护性 | 模板与逻辑混杂,难于维护 | 组件化清晰,职责分明 |

| 扩展能力 | 难以对接移动端或其他客户端 | 易于扩展为App、小程序等 |

| 缓存机制 | 动态页面无法有效缓存 | 静态资源可CDN加速 |

该架构的选择显著提升了系统的可维护性与用户体验,也为后续引入微前端、多租户视图定制等高级功能打下坚实基础。

graph TD

A[Client Browser] --> B[Nginx Static Server]

B --> C{Vue.js SPA}

C --> D[Spring Boot Backend]

D --> E[(MySQL)]

D --> F[(Elasticsearch)]

D --> G[Redis Session Store]

H[Swagger UI] --> D

I[Mobile App] --> D

J[Third-party SIEM] --> D

流程图说明 :展示了前后端分离架构的数据流向。浏览器请求首先到达Nginx服务器,加载Vue前端应用;用户操作触发Axios调用Spring Boot提供的API接口;后端服务根据需求从MySQL读取元数据、从Elasticsearch检索日志内容,并利用Redis存储会话状态。整个架构支持多种客户端接入,体现良好的开放性。

3.1.2 RESTful API 接口设计原则与安全性控制

RESTful API 是前后端通信的核心桥梁。EIQ SyslogAnalyzer 的API设计严格遵循REST规范,采用资源导向的URL命名、标准HTTP动词控制操作,并通过版本号隔离变更风险。

典型接口设计如下:

| HTTP方法 | URL路径 | 功能描述 |

|---|---|---|

| GET | /api/v1/logs?from=now-1h&to=now&q=error | 查询过去一小时内含”error”的日志 |

| POST | /api/v1/alerts/rules | 创建新的告警规则 |

| PUT | /api/v1/users/{id} | 更新指定用户信息 |

| DELETE | /api/v1/dashboards/5 | 删除ID为5的仪表盘 |

所有接口返回统一格式的JSON响应体:

{

"code": 200,

"message": "success",

"data": [...],

"timestamp": "2025-04-05T10:30:00Z"

}

其中 code 表示业务状态码(非HTTP状态码), data 为实际数据负载,便于前端统一处理。

为了保障接口安全,系统实施以下多重防护机制:

- HTTPS强制加密传输 :所有API调用必须通过TLS 1.3以上协议进行,防止中间人攻击。

- 请求频率限制(Rate Limiting) :基于IP地址或Token进行限流,防止暴力探测。例如每分钟最多允许60次请求。

- 输入校验与XSS过滤 :使用Hibernate Validator对入参进行合法性检查,并对输出内容进行HTML转义。

- CORS策略精细化配置 :仅允许可信域名(如

https://syslog.example.com)发起跨域请求。

例如,在Spring Boot中配置CORS:

@Configuration

public class CorsConfig {

@Bean

public CorsConfigurationSource corsConfigurationSource() {

CorsConfiguration config = new CorsConfiguration();

config.setAllowedOriginPatterns(Arrays.asList("https://syslog.example.com"));

config.setAllowedMethods(Arrays.asList("GET", "POST", "PUT", "DELETE"));

config.setAllowedHeaders(Collections.singletonList("*"));

config.setExposedHeaders(Arrays.asList("Authorization", "X-Total-Count"));

config.setAllowCredentials(true);

UrlBasedCorsConfigurationSource source = new UrlBasedCorsConfigurationSource();

source.registerCorsConfiguration("/api/**", config);

return source;

}

}

参数说明:

- setAllowedOriginPatterns 支持通配符域名匹配;

- setAllowCredentials(true) 允许携带Cookie认证信息;

- setExposedHeaders 暴露自定义响应头,便于前端获取总记录数等元信息。

该配置确保只有受信任的前端才能访问后端API,避免CSRF和跨站脚本注入风险。

3.1.3 用户会话管理与JWT令牌认证机制

传统的基于Session的认证方式在分布式环境下存在共享难题,而JWT(JSON Web Token)作为一种无状态认证方案,非常适合微服务架构下的身份验证。

当用户登录成功时,后端生成一个JWT令牌并返回给前端:

String token = Jwts.builder()

.setSubject(user.getUsername())

.claim("roles", user.getRoles())

.setIssuedAt(new Date())

.setExpiration(new Date(System.currentTimeMillis() + 86400000)) // 24小时

.signWith(SignatureAlgorithm.HS512, SECRET_KEY)

.compact();

前端将此token存储在localStorage或内存中,并在每次请求时附加到Header:

Authorization: Bearer eyJhbGciOiJIUzUxMiJ9.xxxxx

后端通过自定义拦截器解析并验证token:

public class JwtAuthInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) {

String authHeader = request.getHeader("Authorization");

if (authHeader != null && authHeader.startsWith("Bearer ")) {

String token = authHeader.substring(7);

try {

Jws claims = Jwts.parser().setSigningKey(SECRET_KEY).parseClaimsJws(token);

String username = claims.getBody().getSubject();

SecurityContextHolder.getContext().setAuthentication(new UsernamePasswordAuthenticationToken(username, null, getAuthorities(claims)));

return true;

} catch (Exception e) {

response.setStatus(HttpServletResponse.SC_UNAUTHORIZED);

return false;

}

}

response.setStatus(HttpServletResponse.SC_UNAUTHORIZED);

return false;

}

}

逻辑分析:

- 解析Authorization头中的Bearer Token;

- 使用密钥验证签名完整性;

- 提取用户名并设置Spring Security上下文,供后续权限判断使用;

- 若验证失败,则返回401未授权状态。

JWT的优势在于服务端无需保存会话状态,适合横向扩展;但需注意令牌一旦签发,在过期前无法主动吊销,因此建议设置较短有效期(如2小时),并配合Refresh Token机制延长登录周期。

sequenceDiagram

participant Client

participant AuthServer

participant APIBackend

Client->>AuthServer: POST /login (username/password)

AuthServer-->>Client: JWT Token (expires in 24h)

Client->>APIBackend: GET /api/logs Authorization: Bearer

APIBackend->>APIBackend: Validate JWT Signature

APIBackend-->>Client: Return Log Data

Note right of APIBackend: No session stored, stateless verification

流程图说明 :展示JWT认证流程。客户端登录后获得Token,之后每次请求携带该Token;后端无需查询数据库即可完成身份验证,实现真正的无状态认证。

该机制保障了Web界面的安全访问,同时为未来支持OAuth2.0、OpenID Connect等标准协议预留了升级空间。

4. 海量日志数据高效接收与存储方案

在现代企业IT架构中,随着服务器数量、微服务节点和网络设备的持续扩张,日志数据呈现出爆发式增长。每天产生的日志量可能达到TB甚至PB级别,这对日志系统的接收能力、存储效率以及后续分析性能提出了严峻挑战。EIQ SyslogAnalyzer v2.0.18 针对这一痛点,构建了一套从 高并发接入 到 高性能持久化 再到 可扩展存储架构 的完整解决方案。本章节深入剖析其核心设计思想与关键技术实现路径,重点围绕日志接收引擎优化、分布式存储策略、数据可靠性保障机制及实际调优案例展开论述。

4.1 高性能日志接收引擎设计

面对每秒数万条日志消息的涌入压力,传统的阻塞式I/O模型已无法满足实时性要求。EIQ SyslogAnalyzer 采用基于 Netty 框架 的非阻塞异步通信机制,结合多级缓冲与协议适配层,实现了高吞吐、低延迟的日志接入能力。

4.1.1 Netty框架实现非阻塞I/O处理大规模连接

Netty 是一个基于 Java NIO(Non-blocking I/O)的高性能网络应用框架,广泛应用于中间件、消息系统和网关类服务中。其事件驱动模型允许单线程管理成千上万个并发连接,非常适合用于构建高并发日志收集器。

在 EIQ SyslogAnalyzer 中,日志接收模块通过 Netty 构建了 UDP 和 TCP 双协议监听器:

public class SyslogServer {

public void start(int port) throws Exception {

EventLoopGroup bossGroup = new NioEventLoopGroup(1);

EventLoopGroup workerGroup = new NioEventLoopGroup();

try {

ServerBootstrap bootstrap = new ServerBootstrap();

bootstrap.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new ChannelInitializer() {

@Override

protected void initChannel(SocketChannel ch) {

ChannelPipeline pipeline = ch.pipeline();

pipeline.addLast("decoder", new SyslogDecoder()); // 自定义解码器

pipeline.addLast("handler", new SyslogMessageHandler()); // 业务处理器

}

})

.option(ChannelOption.SO_BACKLOG, 1024)

.childOption(ChannelOption.SO_KEEPALIVE, true);

ChannelFuture future = bootstrap.bind(port).sync();

System.out.println("Syslog server started on port " + port);

future.channel().closeFuture().sync();

} finally {

bossGroup.shutdownGracefully();

workerGroup.shutdownGracefully();

}

}

}

代码逻辑逐行解读与参数说明:

-

NioEventLoopGroup: 使用 NIO 多路复用机制,bossGroup负责接收新连接,workerGroup负责处理读写事件。 -

ServerBootstrap: Netty 提供的服务端启动辅助类,用于配置线程模型、通道类型和处理器链。 -

.channel(NioServerSocketChannel.class): 指定使用 NIO 的 ServerSocketChannel,支持非阻塞 accept。 -

ChannelInitializer: 在客户端连接建立时初始化 Pipeline,添加自定义解码器和处理器。 -

SyslogDecoder: 实现 RFC3164/RFC5424 协议解析,将原始字节流转换为结构化的SyslogMessage对象。 -

SO_BACKLOG=1024: 设置操作系统等待队列最大长度,防止瞬时连接洪峰导致拒绝服务。 -

SO_KEEPALIVE=true: 启用 TCP 心跳保活机制,避免长时间空闲连接被中间防火墙断开。

该设计使得单个接收节点可稳定支撑超过 50,000 并发连接 ,并通过 Reactor 模式实现高效的事件调度。

Netty 与传统 BIO 对比优势如下表所示:

| 特性 | BIO(阻塞I/O) | Netty(NIO) |

|---|---|---|

| 连接数上限 | ~1000(受限于线程数) | >50,000 |

| 线程模型 | 每连接一线程 | 事件驱动+少量线程 |

| 内存占用 | 高(栈空间消耗大) | 低(共享线程池) |

| 延迟 | 中等(上下文切换频繁) | 极低(无阻塞等待) |

| 扩展性 | 差 | 强,易于水平扩展 |

此外,Netty 支持灵活的 ChannelPipeline 机制,可在不修改核心逻辑的前提下插入加密、压缩、限流等中间件,极大增强了系统的可维护性。

4.1.2 消息缓冲区与背压机制防止服务崩溃

当上游日志源突发流量激增时,若后端存储系统处理速度跟不上,可能导致内存溢出或消息丢失。为此,EIQ SyslogAnalyzer 引入了两级缓冲与背压控制机制。

缓冲机制架构图(Mermaid 流程图)

graph TD

A[日志发送端] --> B{Netty Receiver}

B --> C[RingBuffer 入口队列]

C --> D{Dispatcher 分发器}

D --> E[MongoDB Writer]

D --> F[Elasticsearch Writer]

D --> G[Kafka Producer]

subgraph Backpressure Control

H[监控模块] --> I[判断消费速率 < 生产速率?]

I -->|是| J[通知Netty暂停读取]

I -->|否| K[恢复正常接收]

end

H -.-> D

如图所示,系统在 Netty 接收层之后设置了一个基于 Disruptor RingBuffer 的高性能环形缓冲区。该缓冲区具有以下特性:

- 固定大小(默认 65536 条消息),避免无限增长;

- 多生产者/单消费者模式,确保线程安全;

- CAS 无锁操作,提升并发性能。

一旦缓冲区填充率达到阈值(例如 80%),监控模块将触发背压信号,通过 Channel.config().setAutoRead(false) 主动关闭 Netty 的自动读取功能,暂停从 socket 读取数据,从而形成反向压力反馈。

此机制有效保护了下游组件,特别是在 Elasticsearch 集群因 GC 或磁盘慢导致写入延迟时,不会造成整个接收链路雪崩。

4.1.3 支持GELF、JSON等多种扩展格式接入

除了标准 Syslog 格式外,许多现代化应用(如 Docker 容器、Spring Boot 微服务)倾向于输出结构化日志,常见格式包括 GELF(Graylog Extended Log Format) 和 JSON 。

EIQ SyslogAnalyzer 通过插件化解析器实现多格式兼容:

{

"version": "1.1",

"host": "web-server-01",

"short_message": "Request timeout",

"timestamp": 1712048400.123,

"level": 3,

"facility": "httpd",

"file": "/app/controllers/user.go",

"line": 45,

"full_message": "GET /api/v1/users timed out after 30s"

}

上述为典型的 GELF 消息示例。系统通过识别 _ 开头字段或特定 JSON schema 结构,自动匹配解析模板,并将其映射为统一的内部日志对象:

public class UnifiedLogEntry {

private String host;

private long timestamp;

private int severity;

private String facility;

private String message;

private Map extraFields; // 存储扩展字段

}

支持的主要格式及其用途如下表:

| 格式 | 来源场景 | 是否需解码 | 结构化程度 |

|---|---|---|---|

| RFC3164 | 传统设备(路由器、交换机) | 是(正则提取) | 低 |

| RFC5424 | 安全设备、Linux auditd | 是(ABNF语法解析) | 中 |

| GELF | Graylog Agent、Docker logging driver | 是(JSON解析) | 高 |

| JSON Line | Filebeat、Fluentd转发 | 是(逐行JSON) | 高 |

| CEF | 安全信息与事件管理系统 | 是(键值对拆分) | 中 |

通过统一抽象层,所有格式最终归一化入库,便于后续跨源关联分析。

4.2 存储架构优化策略

日志数据具有“一次写入、多次查询、长期保留”的典型特征,因此存储方案需兼顾写入性能、检索效率和成本控制。

4.2.1 分库分表与按日/按周分区存储策略

对于关系型数据库(如 MySQL)作为元数据或告警记录存储时,采用时间维度的 分区表(Partitioning) 设计至关重要。

以日志主表为例,创建按天分区的 MySQL 表结构:

CREATE TABLE log_records (

id BIGINT AUTO_INCREMENT,

host VARCHAR(255),

app_name VARCHAR(100),

severity TINYINT,

timestamp DATETIME(3),

message TEXT,

PRIMARY KEY (id, timestamp)

) ENGINE=InnoDB

PARTITION BY RANGE COLUMNS(timestamp) (

PARTITION p20250301 VALUES LESS THAN ('2025-03-02'),

PARTITION p20250302 VALUES LESS THAN ('2025-03-03'),

PARTITION p20250303 VALUES LESS THAN ('2025-03-04'),

...

);

优势分析:

- 查询仅扫描目标分区,显著减少 I/O;

- 删除过期数据可通过

DROP PARTITION快速完成,无需 DELETE 扫描; - 支持在线添加未来分区,适应长期运行需求。

对于超大规模部署,还可进一步实施 分库分表(Sharding) ,例如按 facility 或 data_center 字段哈希分布至不同实例,实现横向扩展。

4.2.2 Elasticsearch集群部署实现快速全文检索

针对海量非结构化文本的检索需求,EIQ SyslogAnalyzer 默认集成 Elasticsearch 作为核心搜索引擎。

典型的集群拓扑如下:

graph LR

Client --> LoadBalancer

LoadBalancer --> MasterNode1

LoadBalancer --> MasterNode2

LoadBalancer --> DataNode1

LoadBalancer --> DataNode2

LoadBalancer --> DataNode3

MasterNode1 --协调--> DataNode1

MasterNode1 --协调--> DataNode2

MasterNode3 --协调--> DataNode3

DataNode1 <--复制--> DataNode2

DataNode2 <--复制--> DataNode3

关键配置建议:

- 索引模板设置 :

PUT _template/syslog_template

{

"index_patterns": ["syslog-*"],

"settings": {

"number_of_shards": 6,

"number_of_replicas": 2,

"refresh_interval": "5s"

},

"mappings": {

"properties": {

"timestamp": { "type": "date" },

"host": { "type": "keyword" },

"message": { "type": "text", "analyzer": "standard" }

}

}

}

参数说明:

- shards=6 :适合每日约 1~2TB 数据量;

- replicas=2 :提供高可用与读负载均衡;

- refresh_interval=5s :平衡近实时搜索与写入性能。

- 滚动索引(Rollover)策略 :

POST /syslog-write/_rollover

{

"conditions": {

"max_age": "1d",

"max_size": "50GB"

}

}

当日志写满一天或达到 50GB 时自动创建新索引,避免单一索引过大影响性能。

4.2.3 冷热数据分离:SSD缓存+HDD归档组合方案

根据访问频率差异,引入 冷热分层存储 架构:

| 层级 | 存储介质 | 保存周期 | 访问频率 | 技术手段 |

|---|---|---|---|---|

| 热数据 | NVMe SSD | 7天 | 高频 | Elasticsearch 实时索引 |

| 温数据 | SAS SSD | 30天 | 中等 | 压缩后转入独立集群 |

| 冷数据 | HDD 归档 | 1年 | 低 | HDFS + Parquet 格式 |

具体流程如下:

- 新日志写入热节点,启用全部字段索引;

- 第8天起迁移至温节点,关闭低频字段(如 full_message)的索引;

- 第31天起归档至 Hadoop 集群,使用 Snappy 压缩的 Parquet 列式存储;

- 查询时由统一查询代理路由请求,透明返回结果。

该方案使单位存储成本下降 60%以上 ,同时保障热点数据响应时间低于 500ms。

4.3 数据持久化与可靠性保障

在金融、医疗等关键行业,日志数据不可丢失是硬性要求。EIQ SyslogAnalyzer 通过多重机制确保端到端的数据完整性。

4.3.1 ACK确认机制与重传策略确保传输完整性

在 TCP 模式下启用 ACK 应答机制 :

# 示例:Python 发送端模拟

import socket

sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

sock.connect(('syslog-server', 514))

message = '<34>1 2025-03-01T12:00:00Z web-01 httpd - - [meta sequenceId="1001"] Login failed'

sock.sendall(message.encode())

# 等待服务器返回 'ACK

'

response = sock.recv(1024).decode().strip()

if response == 'ACK':

print("Message delivered successfully")

else:

# 触发本地重试队列

retry_queue.put(message)

接收端在成功解析并落盘后返回 ACK ,否则保持连接打开但不回应,促使客户端超时重发。

4.3.2 WAL(Write-Ahead Logging)防止写入中断导致数据丢失

所有关键写入操作均遵循 WAL 原则 。以 Kafka 为例,Producer 设置如下参数:

acks=all

retries=2147483647

enable.idempotence=true

这意味着:

- acks=all :必须等到 ISR(同步副本)全部确认才视为成功;

- 幂等性开启后可防止重复写入;

- 结合 Broker 端 min.insync.replicas=2 ,确保至少两个副本存活。

类似地,在数据库写入前先写入 Binlog 或 WAL 日志文件,即使系统崩溃也可通过日志恢复未提交事务。

4.3.3 定期快照备份与异地容灾恢复演练

制定完整的 RTO(恢复时间目标)与 RPO(恢复点目标)策略:

| 级别 | 备份方式 | 频率 | RPO | RTO |

|---|---|---|---|---|

| 一级(核心) | 实时复制 | 持续 | <1分钟 | <15分钟 |

| 二级(重要) | 快照备份 | 每小时 | <1小时 | <1小时 |

| 三级(普通) | 归档转储 | 每日 | <24小时 | <4小时 |

定期执行 灾难恢复演练 ,验证从备份恢复全流程的有效性,包括:

- 模拟主数据中心宕机;

- 切换至备用站点;

- 验证数据一致性与服务可用性。

4.4 存储性能调优实例分析

真实环境中,性能瓶颈往往出现在 JVM、磁盘 IO 或索引设计层面。以下是某银行客户的真实调优案例。

4.4.1 JVM参数调优提升GC效率

原配置导致频繁 Full GC:

-Xms4g -Xmx4g -XX:+UseParallelGC

调整为 G1 垃圾回收器并优化参数:

-Xms8g -Xmx8g

-XX:+UseG1GC

-XX:MaxGCPauseMillis=200

-XX:G1HeapRegionSize=16m

-XX:InitiatingHeapOccupancyPercent=45

-XX:+PrintGCApplicationStoppedTime

-XX:+UnlockDiagnosticVMOptions

-XX:+G1SummarizeConcMark

效果对比:

| 指标 | 调优前 | 调优后 |

|---|---|---|

| Young GC 时间 | 150ms | 80ms |

| Full GC 次数/天 | 12次 | 0次 |

| STW 总时长/天 | 3.6s | 0.96s |

4.4.2 批量写入合并减少磁盘IO开销

将单条插入改为批量提交:

// 错误做法:逐条插入

for (LogEntry entry : logs) {

jdbcTemplate.update(SQL_INSERT, entry.toParams());

}

// 正确做法:批量插入

jdbcTemplate.batchUpdate(SQL_INSERT, batchArgs);

配合 rewriteBatchedStatements=true 参数,MySQL 可将多条 INSERT 合并为一条语句,IOPS 下降 70% 。

4.4.3 查询索引优化降低响应延迟

原始查询:

SELECT * FROM logs WHERE message LIKE '%failed login%' AND host='web-01';

优化步骤:

1. 为 host 创建 B-tree 索引;

2. 使用 EXPLAIN 分析执行计划;

3. 将模糊查询替换为关键词提取 + 倒排索引(Elasticsearch 实现);

最终查询延迟从 3.2s → 120ms ,提升 26 倍。

综上所述,EIQ SyslogAnalyzer 在海量日志处理方面构建了从 高效接收 、 弹性存储 到 可靠持久化 的全链路技术体系。通过融合 Netty、Elasticsearch、Kafka 与分层存储理念,不仅满足当前高并发场景下的稳定性需求,也为未来 AI 驱动的日志分析奠定了坚实基础。

5. 实时日志分析与异常行为检测功能

在现代企业IT环境中,日志数据已不再是简单的系统记录,而是承载着运维状态、安全事件和业务行为的重要信息资产。随着分布式架构、微服务和云原生技术的普及,日志量呈指数级增长,传统基于人工查看或定时批处理的分析方式已无法满足对系统异常的快速响应需求。EIQ SyslogAnalyzer v2.0.18 集成先进的实时流处理引擎与智能检测机制,构建了一套完整的 实时日志分析与异常行为检测体系 ,能够在毫秒级延迟内完成从原始日志摄入到异常告警输出的全流程闭环。

该功能模块的核心目标是实现“ 早发现、准定位、快响应 ”的安全与运维保障能力。通过将日志作为连续事件流进行建模,结合规则驱动、统计分析与机器学习模型,系统能够自动识别潜在风险模式,并以可视化方式呈现给运维与安全部门。本章节将深入解析其实现原理、关键技术选型、典型应用场景及结果展示机制,帮助高级从业者理解其内部运行逻辑并具备调优与扩展能力。

5.1 实时流处理引擎原理

为了应对每秒数万条日志的高吞吐场景,EIQ SyslogAnalyzer 采用基于 Apache Kafka + Flink 的流式计算架构,实现了低延迟、高可靠、可扩展的日志分析流水线。该架构不仅支持实时聚合与窗口计算,还具备精确一次(exactly-once)语义保障,确保在故障恢复后不会重复或遗漏关键事件。

### 5.1.1 基于Kafka Streams或Flink的事件流处理架构

系统整体流处理流程如下图所示:

flowchart TD

A[日志源] --> B[Syslog Receiver]

B --> C[Kafka Topic: raw_logs]

C --> D[Flink Job Manager]

D --> E[Stream Processing Tasks]

E --> F[Window Aggregation]

F --> G[Anomaly Detection Engine]

G --> H[Alerting Module]

H --> I[(Real-time Dashboard)]

G --> J[(Elasticsearch Index)]

如上图所示,所有接入的日志首先进入 raw_logs Kafka 主题,由 Flink 消费并执行一系列转换操作。Flink 作为分布式流处理框架,具备以下优势:

- 支持事件时间(Event Time)语义,避免因网络延迟导致的时间错乱;

- 内置状态后端(State Backend),可用于维护用户登录会话、IP请求计数等上下文信息;

- 提供 Checkpoint 机制,保证作业失败后的状态一致性。

示例代码段展示了如何使用 Flink 构建一个基础的日志流处理任务:

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(5000); // 每5秒做一次checkpoint

// 从Kafka读取原始日志

KafkaSource kafkaSource = KafkaSource.builder()

.setBootstrapServers("kafka-broker:9092")

.setGroupId("syslog-analyzer-group")

.setTopics("raw_logs")

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

DataStream logStream = env.fromSource(kafkaSource, WatermarkStrategy.noWatermarks(), "Kafka Source");

// 解析JSON格式日志

DataStream parsedStream = logStream.map(json -> {

ObjectMapper mapper = new ObjectMapper();

return mapper.readValue(json, SyslogEntry.class);

});

// 按host分组,统计每分钟错误日志数量

DataStream errorCountStream = parsedStream

.filter(log -> "ERROR".equals(log.getSeverity()))

.keyBy(SyslogEntry::getHost)

.window(TumblingProcessingTimeWindows.of(Time.minutes(1)))

.aggregate(new ErrorCountAggregator());

errorCountStream.addSink(new AlertingSinkFunction());

env.execute("Real-time Log Analyzer");

逻辑逐行分析:

| 行号 | 说明 |

|---|---|

| 1–3 | 初始化 Flink 执行环境,并启用每5秒一次的检查点机制,用于容错恢复 |

| 5–13 | 配置 Kafka 数据源,指定 Broker 地址、消费组和主题名称,使用字符串反序列化器读取原始日志 |

| 15 | 将 Kafka 流转换为 Flink 的 DataStream,便于后续处理 |

| 18–22 | 使用 Jackson 库将 JSON 字符串反序列化为 SyslogEntry 对象,结构化提取字段 |

| 25–29 | 过滤出严重级别为 ERROR 的日志,按主机名分组,应用滚动一分钟窗口进行聚合 |

| 30 | 自定义聚合函数 ErrorCountAggregator 计算每个窗口内的错误次数 |

| 32 | 将结果发送至告警函数,触发阈值判断与通知机制 |

参数说明:

-

enableCheckpointing(5000):设置检查点间隔为5秒,影响恢复时间和性能开销。 -

TumblingProcessingTimeWindows.of(Time.minutes(1)):使用处理时间构建固定长度的一分钟窗口,适合实时监控。 -

keyBy(SyslogEntry::getHost):按键分区,确保同一主机的日志被同一并行子任务处理,保持状态一致。

此架构支持横向扩展:当日志量增加时,可通过增加 Flink TaskManager 节点提升处理能力,同时 Kafka 分区数也可相应调整以实现负载均衡。

### 5.1.2 窗口计算机制:滑动窗口与滚动窗口应用场景

窗口(Window)是流处理中的核心概念,用于将无限数据流切分为有限片段进行聚合运算。EIQ SyslogAnalyzer 根据不同检测需求灵活选用窗口类型。

| 窗口类型 | 特点 | 适用场景 |

|---|---|---|

| 滚动窗口(Tumbling Window) | 固定大小、无重叠 | 统计每分钟失败登录次数 |

| 滑动窗口(Sliding Window) | 固定大小、可重叠 | 检测过去5分钟内每30秒的流量波动 |

| 会话窗口(Session Window) | 基于活动间隙划分 | 用户操作会话追踪与超时检测 |

| 计数窗口(Count-based Window) | 按元素数量划分 | 批量处理1000条日志后生成摘要 |

例如,在 SSH 暴力破解检测中,系统采用滑动窗口策略:

parsedStream

.filter(log -> log.getMessage().contains("Failed password"))

.keyBy(SyslogEntry::getSrcIp)

.window(SlidingEventTimeWindows.of(Time.minutes(5), Time.seconds(30)))

.count()

.filter(count -> count > 10)

.map(ip -> new Alert("Brute Force Detected", ip));

上述代码表示:在过去5分钟内,若某个IP地址每30秒滑动区间内出现超过10次“Failed password”日志,则触发告警。相比静态时间窗口,滑动窗口能更灵敏地捕捉突发行为。

### 5.1.3 流式聚合与状态管理实现连续监测

在长期运行的流作业中,必须维护中间状态(state)以支持跨事件的关联分析。Flink 提供两种主要状态类型:

- Keyed State :绑定到特定 key(如 IP 地址),适用于每个源独立跟踪;

- Operator State :全局共享,常用于保存配置或偏移量。

以检测“频繁连接断开”的场景为例,需维护每个客户端的最近连接时间戳:

public class ConnectionDropDetector extends KeyedProcessFunction {

private ValueState lastDisconnectTime;

@Override

public void open(Configuration config) {

lastDisconnectTime = getRuntimeContext().getState(

new ValueStateDescriptor<>("last_disconnect", Long.class)

);

}

@Override

public void processElement(SyslogEntry log, Context ctx, Collector out) {

if (log.getMessage().contains("Connection closed")) {

Long prevTime = lastDisconnectTime.value();

long currentTime = System.currentTimeMillis();

if (prevTime != null && (currentTime - prevTime) < 60_000) {

out.collect(new Alert("Frequent Disconnect", log.getHost(), log.getSrcIp()));

}

lastDisconnectTime.update(currentTime);

}

}

}

参数与逻辑说明:

-

ValueState:存储上一次断开连接的时间戳,生命周期与 key(如 IP)绑定; -

open()方法初始化状态句柄; -

processElement()中判断两次断开间隔是否小于60秒,若是则发出告警; - 状态自动持久化至 RocksDB 或内存,支持故障恢复。

该机制使得系统可在不依赖外部数据库的情况下完成复杂的状态追踪,显著降低延迟与资源消耗。

5.2 异常检测算法模型应用

单纯的日志过滤与计数难以应对隐蔽性强、模式多变的攻击行为。为此,EIQ SyslogAnalyzer 引入多层次异常检测模型,涵盖规则引擎、统计方法与轻量级机器学习,形成纵深防御体系。

### 5.2.1 基于规则匹配的固定模式识别(如“Failed login”频发)

规则引擎是最直接有效的检测手段,尤其适用于已知威胁模式。系统内置 Drools 规则语言支持动态加载与热更新。

示例规则文件 login_failure.drl :

rule "Excessive Failed Logins"

when

$e: SyslogEntry(

facility == "AUTH",

message matches ".*Failed password for .* from .*",

timestamp > (new Date()).time - 300000 // 最近5分钟

)

accumulate(

$f: SyslogEntry() from entry-point "stream",

count($f) > 10,

$ip: $f.srcIp

)

then

System.out.println("ALERT: Possible brute force from " + $ip);

insert(new Alert("BRUTE_FORCE", $ip, "High"));

end

执行流程解析:

- Pattern Matching :匹配认证类日志且消息包含“Failed password”;

- Time Constraint :限制仅考虑最近5分钟内的事件;

- Accumulate Clause :对相同源IP的失败记录进行计数;

- Threshold Trigger :超过10次即触发告警并插入新事实。

此类规则可批量导入并通过 Web 界面动态启停,适应策略变更需求。

### 5.2.2 统计学方法检测偏离基线的行为(Z-score、移动平均)

对于缺乏明确规则的异常,系统采用统计基线建模方法。以每日凌晨 CPU 使用率为例,正常情况下呈周期性波动。一旦偏离历史均值过多,即可判定异常。

实现步骤如下:

- 收集过去7天同时间段的数据,计算均值 $mu$ 与标准差 $sigma$

- 当前值 $x$ 的 Z-score 计算公式为:

$$

Z = rac{x - mu}{sigma}

$$ - 若 $|Z| > 3$,则认为显著偏离(p < 0.001)

Java 实现片段:

public boolean isOutlier(double currentValue, List history) {

double mean = history.stream().mapToDouble(v -> v).average().orElse(0.0);

double variance = history.stream()

.mapToDouble(v -> Math.pow(v - mean, 2))

.average().orElse(0.0);

double stdDev = Math.sqrt(variance);

if (stdDev == 0) return false;

double zScore = Math.abs((currentValue - mean) / stdDev);

return zScore > 3.0;

}

该方法广泛应用于:

- 网络流量突增检测

- 日志量骤降(可能意味着服务宕机)

- 成功/失败比例异常变化

结合滑动窗口,可实现实时在线基线更新,适应业务季节性变化。

### 5.2.3 机器学习初步探索:孤立森林用于未知攻击识别

针对零日攻击或新型异常行为,系统集成 Isolation Forest(孤立森林) 算法进行无监督异常检测。该模型通过随机分割特征空间,使异常样本更容易被“孤立”,从而获得较高异常评分。

特征工程输入包括:

| 特征 | 描述 |

|---|---|

failed_login_count | 过去5分钟失败登录次数 |

success_rate | 成功率百分比 |

session_duration_avg | 平均会话持续时间 |

command_entropy | 用户执行命令的字符熵值(反映多样性) |

Python 模型训练脚本(离线):

from sklearn.ensemble import IsolationForest

import pandas as pd

# 加载历史日志特征数据

df = pd.read_csv("syslog_features.csv")

# 训练模型

iso_forest = IsolationForest(contamination=0.01, random_state=42)

iso_forest.fit(df[['failed_login_count', 'success_rate', 'session_duration_avg', 'command_entropy']])

# 保存模型

import joblib

joblib.dump(iso_forest, 'isolation_forest_model.pkl')

在线推理通过 gRPC 接口嵌入 Flink 流程:

ModelServiceGrpc.ModelServiceBlockingStub stub = ModelServiceGrpc.newBlockingStub(channel);

PredictRequest request = PredictRequest.newBuilder()

.addFeatures(failedLoginCount)

.addFeatures(successRate)

.addFeatures(sessionDurationAvg)

.addFeatures(commandEntropy)

.build();

PredictResponse response = stub.predict(request);

if (response.getAnomalyScore() > 0.8) {

alertService.send("ML-Based Anomaly Detected", host);

}

尽管当前仍处于试点阶段,但实验数据显示其对 APT 攻击前期横向移动行为的检出率较纯规则方案提升约 37%。

5.3 典型异常场景识别案例

理论模型最终需落地于实际业务场景。以下是三个已在生产环境验证成功的典型案例。

### 5.3.1 SSH暴力破解行为的登录失败次数突增检测

问题背景 :外部攻击者利用自动化工具尝试爆破服务器 SSH 密码。

解决方案 :

- 使用 Flink 滑动窗口统计每个源IP在5分钟内的“Failed password”日志数量;

- 设置动态阈值:若超过历史均值+3σ 或绝对值>15次,则触发红色告警;

- 自动封禁IP并推送至防火墙API。

-- 示例查询语句(用于事后审计)

SELECT src_ip, COUNT(*) AS fail_count

FROM syslog_raw

WHERE message LIKE '%Failed password%'

AND timestamp BETWEEN NOW() - INTERVAL 5 MINUTE AND NOW()

GROUP BY src_ip

HAVING COUNT(*) > 15;

### 5.3.2 关键服务进程意外退出的日志特征捕获

日志样例 :

Jan 15 08:23:41 webserver systemd[1]: nginx.service: Main process exited, code=exited, status=1/FAILURE

检测逻辑 :

- 定义正则表达式:

"Main process exited.*status=(d+)"; - 提取退出码 status,status ≥ 1 视为异常;

- 结合服务名建立白名单(如某些服务允许重启);

- 触发告警并关联依赖服务拓扑图。

### 5.3.3 防火墙规则变更引发的安全策略绕过预警

风险点 :管理员误操作或恶意修改 iptables/firewalld 规则可能导致开放高危端口。

实现方式 :

- 监听

/var/log/audit/audit.log或 Cisco ASA 日志; - 匹配关键字

"iptables: rule add"或"configured access-list"; - 判断新增规则是否允许 ANY→ANY 或开放22/3389等敏感端口;

- 若非授权时间段(如非工作时间)发生变更,立即告警。

5.4 分析结果可视化呈现

检测结果的价值在于及时传达给相关人员。EIQ SyslogAnalyzer 提供多维度可视化组件,增强态势感知能力。

### 5.4.1 实时告警面板与颜色编码优先级标识

告警面板采用红(紧急)、橙(高)、黄(中)、蓝(低)四级分级机制:

| 级别 | 条件 | 响应要求 |

|---|---|---|

| 红色 | 多节点服务中断、DDoS攻击 | 5分钟内响应 |

| 橙色 | 单节点宕机、权限提升 | 15分钟内确认 |

| 黄色 | 配置变更、磁盘接近满 | 1小时内处理 |

| 蓝色 | 日志格式错误、低频失败 | 可延迟处理 |

前端使用 Vue+ECharts 实现动态刷新仪表盘。

### 5.4.2 拓扑图联动显示受影响主机与服务链路

系统集成 CMDB 数据,构建服务依赖拓扑图。当某台数据库出现异常时,自动高亮其上游 Web 应用与下游缓存节点,辅助影响范围评估。

graph LR

Client --> API_Gateway

API_Gateway --> AuthService

API_Gateway --> OrderService

OrderService --> MySQL[(MySQL Cluster)]

OrderService --> Redis[(Redis Cache)]

style MySQL fill:#ffcccc,stroke:#f66

点击告警条目可自动跳转至对应拓扑区域。

### 5.4.3 攻击路径还原与关联事件时间轴展示

对于复杂入侵事件,系统提供“事件时间轴”视图,整合多个日志源:

[2024-01-15 08:10:01] Failed login from 192.168.1.100 (SSH)

[2024-01-15 08:10:05] Successful login from 192.168.1.100

[2024-01-15 08:10:10] User sudo executed: /bin/bash

[2024-01-15 08:10:15] Outbound connection to 10.0.0.5:4444 (C2 server)

通过时间轴串联各阶段行为,还原完整攻击链条,极大提升调查效率。

6. 跨平台日志统一管理与集中分析实践

6.1 多操作系统日志适配方案

在企业IT环境中,服务器、终端和网络设备通常运行于多种操作系统之上,包括Windows、Linux、Solaris等。为实现日志的统一采集与集中分析,必须解决不同系统原生日志格式与Syslog协议之间的兼容性问题。

6.1.1 Windows事件日志转Syslog的WEC转发器配置

Windows系统使用Event Log服务记录操作行为,其二进制格式无法被Syslog接收端直接解析。为此,EIQ SyslogAnalyzer推荐采用 Windows Event Collector(WEC) 机制,结合WinRM协议将本地或远程主机的日志转换为标准Syslog消息。

具体配置步骤如下:

Forward Security and System Logs to Syslog Server

SyslogForwarder-01

CollectorInitiated

Push

HTTP

http://syslog-server:5985/wsman

RenderedText

true

Syslog

udp://192.168.10.100:514

执行命令注册订阅:

wecutil cs Subscription.xml

wecutil sr SyslogForwarder-01 -configfile EventsToForward.xml

net start w32time && net start winrm

该方式支持按事件ID过滤(如Event ID 4625表示登录失败),并通过TLS加密传输保障安全性。

6.1.2 Linux rsyslog/syslog-ng配置文件定制化推送

Linux系统普遍使用 rsyslog 或 syslog-ng 作为日志守护进程。以下是以rsyslog为例的远程推送配置:

# /etc/rsyslog.conf 或 /etc/rsyslog.d/remote.conf

module(load="imuxsock") # 支持本地socket

module(load="imklog") # 内核日志

module(load="omfwd") # 启用转发模块

# 过滤特定设施类型并转发至中心服务器

if $syslogfacility-text == 'auth' or $syslogseverity >= 6 then {

action(type="omfwd"

Target="192.168.10.100"

Port="514"

Protocol="tcp"

TCP_Framing="octet-counted"

Template="RSYSLOG_ForwardFormat"

RebindInterval="3600"

)

}

重启服务生效:

systemctl restart rsyslog

journalctl -u rsyslog --since "5 minutes ago"

支持模板自定义输出格式,确保字段结构一致:

template(name="CustomSyslogFormat" type="string"

string="<%PRI%>%TIMESTAMP% %HOSTNAME% %APP-NAME% %PROCID%: %msg%

")

6.1.3 Solaris SMF日志输出与格式兼容性处理

Solaris系统基于Service Management Facility(SMF)架构,其日志位于 /var/svc/log/ 目录下,非标准Syslog流。可通过脚本轮询日志变更并转换发送:

#!/bin/sh

# solaris-log-forwarder.sh

LOG_DIR="/var/svc/log"

LAST_POS_FILE="/tmp/solaris_last_pos"

find $LOG_DIR -name "*.log" | while read log; do

pos=$(stat -c %s "$log")

last_pos=$(cat "$LAST_POS_FILE" 2>/dev/null || echo 0)

if [ $pos -gt $last_pos ]; then

tail -c +$(($last_pos + 1)) "$log" |

while IFS= read -r line; do

echo "<13>$(date '+%b %d %H:%M:%S') $(hostname) smf: $line" |

nc 192.168.10.100 514

done

echo $pos > "$LAST_POS_FILE"

fi

done

配合cron每分钟执行一次,实现准实时采集。

| 操作系统 | 原生日志位置 | 转发工具 | 协议支持 | 加密能力 |

|---|---|---|---|---|

| Windows | C:WindowsSystem32winevtLogs | WEC + WinRM | HTTP/SOAP | TLS |

| RHEL/CentOS | /var/log/messages, /var/log/secure | rsyslog | UDP/TCP | TLS via GnuTLS |

| Ubuntu | /var/log/syslog | syslog-ng | TCP/TLS | Yes |

| Solaris | /var/svc/log/*.log | Shell + netcat | UDP | 需封装IPSec |

| AIX | /var/adm/ras/errlog | auditbin-to-syslog | TCP | 手动加密 |

| macOS | /var/log/system.log | syslog daemon | UDP | 可桥接TLS代理 |

| FreeBSD | /var/log/messages | syslogd | UDP/TCP | 无原生TLS |

| SUSE | /var/log/messages | rsyslog | TCP | 支持TLS |

| HP-UX | /var/adm/syslog/syslog.log | custom script | UDP | 否 |

| Android (rooted) | /dev/log/main | logcat + tcpdump | TCP | 应用层加密 |

上述适配策略确保了异构环境下的日志标准化接入。

6.2 企业级集中管理实施路径

6.2.1 分布式采集代理部署架构设计(Agent/Agentless模式)

EIQ SyslogAnalyzer支持两种主流采集模式:

- Agent模式 :在目标主机部署轻量级采集代理(如eiq-agent),具备本地缓冲、压缩传输、断点续传功能,适用于高安全要求场景。

- Agentless模式 :通过SSH、WMI、SNMP等方式远程拉取日志,适合资源受限或临时审计需求。

典型拓扑结构如下(Mermaid流程图):

graph TD

A[Windows Host] -->|WEC+WinRM| C(Syslog Forwarder)

B[Linux Server] -->|rsyslog| C

D[Solaris Node] -->|Script Polling| C

C -->|TCP/TLS| E[EIQ Center Node]

F[Firewall] -->|Syslog| E

G[IDS/IPS] -->|UDP| E

H[Database Server] -->|Agent| E

E --> I[(Elasticsearch Cluster)]

E --> J{Kafka Queue}

J --> K[Flink Stream Processor]

K --> L[Alert Engine]

L --> M[Web Dashboard]

6.2.2 中心节点负载均衡与高可用集群部署

为应对大规模日志接入压力,建议采用Nginx+Keepalived实现前端负载均衡:

# /etc/nginx/conf.d/syslog-load-balance.conf

upstream syslog_backend {

server 192.168.10.101:514 max_fails=3 fail_timeout=30s;

server 192.168.10.102:514 backup;

}

server {

listen 514 udp;

proxy_pass syslog_backend;

proxy_responses 1;

timeout 3s;

}

后端EIQ节点共享同一数据库与消息队列,通过ZooKeeper协调状态,避免重复消费。

6.2.3 多租户支持下的部门级日志隔离策略

在大型组织中,需按部门划分数据权限。EIQ SyslogAnalyzer通过以下机制实现多租户隔离:

- 日志标记

tenant_id字段; - Elasticsearch索引命名规则:

logs-{tenant}-YYYY.MM.DD; - RBAC权限控制用户仅能访问所属租户数据;

- 存储配额限制与告警通知。

示例索引模板配置:

PUT _index_template/multi_tenant_logs

{

"index_patterns": ["logs-*-*"],

"data_stream": true,

"priority": 100,

"template": {

"settings": {

"number_of_shards": 3,

"codec": "best_compression"

},

"mappings": {

"properties": {

"tenant_id": { "type": "keyword" },

"host": { "type": "keyword" },

"severity": { "type": "byte" },

"timestamp": { "type": "date" }

}

}

}

}

6.3 运维场景中的典型应用案例

6.3.1 故障定位:通过日志链追溯数据库宕机根本原因

某次生产环境MySQL实例异常终止,通过EIQ SyslogAnalyzer进行跨主机关联分析:

- 查询时间范围:2025-04-05T02:15:00Z 至 02:30:00Z

- 关键词搜索:

"mysqld" AND ("error" OR "terminated") - 发现应用服务器出现大量连接超时:

Apr 5 02:16:23 app01 java: Connection refused: too many connections - 数据库主机日志显示OOM Killer触发:

Apr 5 02:16:18 db01 kernel: Out of memory: Kill process 1234 (mysqld)... - 结合监控指标发现内存泄漏源于某报表任务未释放连接池。

最终确认为应用程序缺陷导致资源耗尽。

6.3.2 安全审计:识别内部人员违规操作的时间证据链

一名运维员工在非工作时间执行了敏感命令。利用EIQ工具构建完整行为轨迹:

| 时间戳 | 主机 | 用户 | 操作 |

|---|---|---|---|

| 2025-04-04T23:12:01 | jump-host | zhangsan | SSH login from 10.1.5.22 |

| 2025-04-04T23:13:15 | db-admin | zhangsan | sudo su - oracle |

| 2025-04-04T23:14:02 | db-admin | oracle | /backup/full_export.sh |

| 2025-04-04T23:18:47 | db-admin | oracle | scp export.dat sftp://external.site/ |

| 2025-04-04T23:20:01 | jump-host | zhangsan | logout |

该序列被自动标记为“高风险数据导出”,触发告警并通知安全部门。

6.3.3 合规遵从:满足等保2.0、GDPR日志留存要求

根据《网络安全等级保护基本要求》及GDPR第30条,日志应至少保留180天,并防止篡改。

EIQ SyslogAnalyzer提供以下合规功能:

- WORM(Write Once Read Many)存储策略,启用后禁止删除或修改历史记录;

- SHA-256哈希校验每日生成日志完整性摘要;

- 支持导出符合XCCDF标准的审计报告;

- 提供日志生命周期管理策略配置界面。

配置示例:

-- 设置日志保留周期(单位:天)

INSERT INTO retention_policy (facility, min_age_days, encryption_required)

VALUES ('security', 180, TRUE), ('system', 90, FALSE);

6.4 持续优化与未来演进方向

6.4.1 AI驱动的日志语义理解与自动分类研究

当前正测试基于BERT微调的日志语义模型,用于自动归类日志条目。初步实验结果显示,在LabeledSyslog-10K数据集上达到92.3%准确率。

训练样本输入:

Input: "User admin failed login from 192.168.1.100"

Label: authentication.failure.bruteforce

模型部署后可减少人工规则维护成本。

6.4.2 与SIEM系统集成实现威胁情报联动响应

通过STIX/TAXII接口对接商业威胁情报平台(如Recorded Future),实现IOC(Indicators of Compromise)匹配:

def match_ioc(log_entry):

ip = extract_ip(log_entry)

if ip in threat_intel_feed:

trigger_alert(severity="critical",

reason=f"Matched C2 server IP: {ip}",

integration="TIP-Platform-X")

同时支持向防火墙下发阻断指令,形成闭环响应。

6.4.3 边缘计算节点轻量化采集模块开发规划

针对IoT和边缘站点带宽受限场景,正在研发基于Rust编写的 eiq-edge-agent ,其特性包括:

- 二进制体积 < 5MB;

- 内存占用 ≤ 10MB;

- 支持离线缓存与QoS分级上传;

- 使用Cap’n Proto序列化提升编码效率。

预计2025 Q3发布首个预览版本。

本文还有配套的精品资源,点击获取

简介:EIQ SyslogAnalyzer v2.0.18 是一款专为 Windows 与 UNIX 系统设计的高效事件与日志分析工具,基于 Syslog 协议实现跨平台日志集中管理。通过其基于 Web 的用户界面,系统管理员可随时随地访问日志数据,实现远程实时监控与快速故障排查。该版本优化了性能与用户体验,支持海量日志处理、自定义告警规则、多维度统计报表生成,并深度兼容 Linux、Solaris 等主流 UNIX 变种系统,显著提升运维效率与系统安全性。作为现代 IT 运维中的关键工具,EIQ SyslogAnalyzer 助力企业构建稳定、智能的日志管理体系。

本文还有配套的精品资源,点击获取