保姆级教程:Qwen Code+vLLM+Qwen3-Coder打造纯内网私服级AI编程助手

本文详细介绍了如何通过Qwen Code+vLLM+Qwen3-Coder-30B-A3B-Instruct构建纯内网环境下的私服级开发辅助引擎。内容包括:使用modelscope下载模型,通过vLLM部署API服务,配置Qwen Code组件连接本地模型,以及测试Vibe Coding功能开发H5小游戏和前端页面。文章提供了完整的部署流程、参数配置说明和代码示例,帮助开发者在内网环境中搭建高性能的AI编程助手,提升开发效率。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

一、Qwen Code

Qwen Code 是一款类似于 Claude Code的AI编程助手,由阿里通义千问团队推出,一定程度上可以作为 Claude Code的平替工具,本文通过 Qwen Code + vLLM + Qwen3-Coder-30B-A3B-Instruct 构建纯内网下私服级开发辅助引擎,主要流程如下所示:

实验主要依赖的版本如下:

torch==2.6.0transformers==4.51.3modelscope==1.23.1vllm==0.8.4

二、vLLM 部署 Qwen3-Coder-30B-A3B-Instruct

使用 modelscope 下载 Qwen3-Coder-30B-A3B-Instruct 模型到本地:

modelscope download --model="Qwen3-Coder-30B-A3B-Instruct" --local_dir Qwen3-Coder-30B-A3B-Instruct

然后使用 vLLM 读取模型启动API服务。

export CUDA_VISIBLE_DEVICES=0,1vllm serve "Qwen3-Coder-30B-A3B-Instruct" --host 0.0.0.0 --port 8060 --dtype bfloat16 --tensor-parallel-size 2 --cpu-offload-gb 0 --gpu-memory-utilization 0.8 --max-model-len 65536 --api-key token-abc123 --enable-prefix-caching --enable-auto-tool-choice --tool-call-parser hermes --trust-remote-code

关键参数说明:

- •

export CUDA_VISIBLE_DEVICES=0,1:指定所使用的GPU。 - •

dtype: 数据类型,其中bfloat16,16位浮点数,适合NVIDIA A100等设备。 - •

tensor-parallel-size:Tensor并行的数量,当多GPU分布式推理时使用,建议和GPU的数量一致。 - •

cpu-offload-gb:允许将部分模型权重或中间结果卸载到CPU的内存中,单位为GB,模拟GPU内存扩展,如果部署的模型大于了显存大小可以设置该参数,但是推理速度会大大下降。 - •

gpu-memory-utilization:设置GPU内存利用率的上限。 - •

max-model-len:允许模型最大处理的Token数,该参数越大占用显存越大。 - •

enable-prefix-caching:启用前缀缓存减少重复计算。 - •

enable-auto-tool-choice:启用 function call 模式。 - •

tool-call-parser hermes:设置 function call 的解析器。

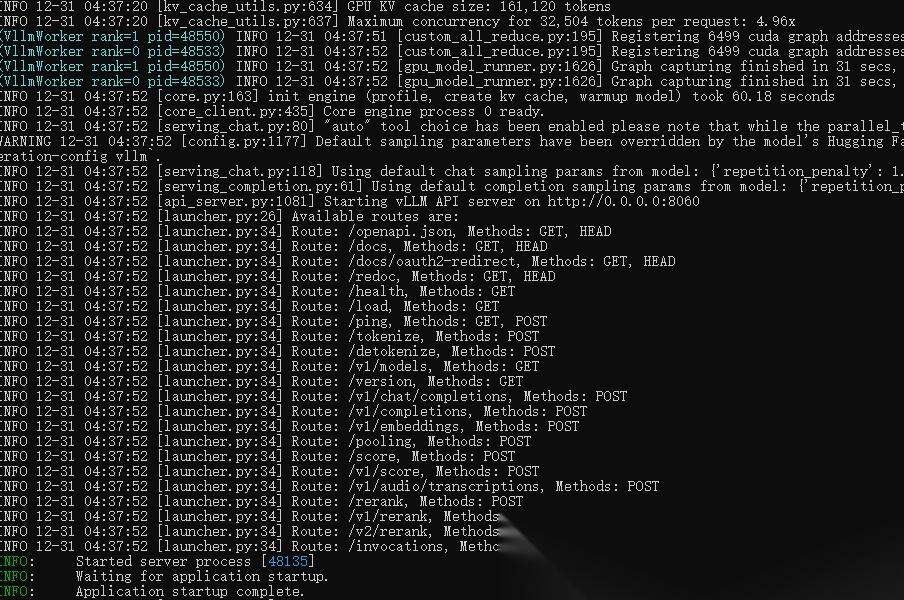

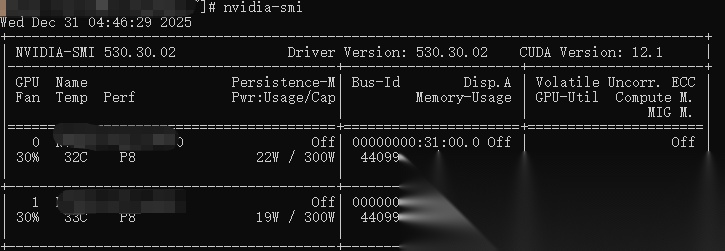

显存占用情况:

如果启动显存不足,可适当调整 gpu-memory-utilization 和 max-model-len 参数,或通过 cpu-offload-gb 将部分模型权重卸载到内存中(速度会大大折扣)。

启动成功后,可通过 /v1/models 接口可查看模型列表:

curl http://127.0.0.1:8060/v1/models -H "Authorization: Bearer token-abc123"

```

测试`API`交互:

```plaintext

curl http://127.0.0.1:8060/v1/chat/completions -H "Content-Type: application/json" -H "Authorization: Bearer token-abc123" -d '{ "model": "Qwen3-Coder-30B-A3B-Instruct", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "你是谁"} ] }'

```

三、安装和配置 Qwen Code

-----------------

首先安装 Qwen Code 组件,这里采用 npm:

```plaintext

npm install -g @qwen-code/qwen-code@latest

```

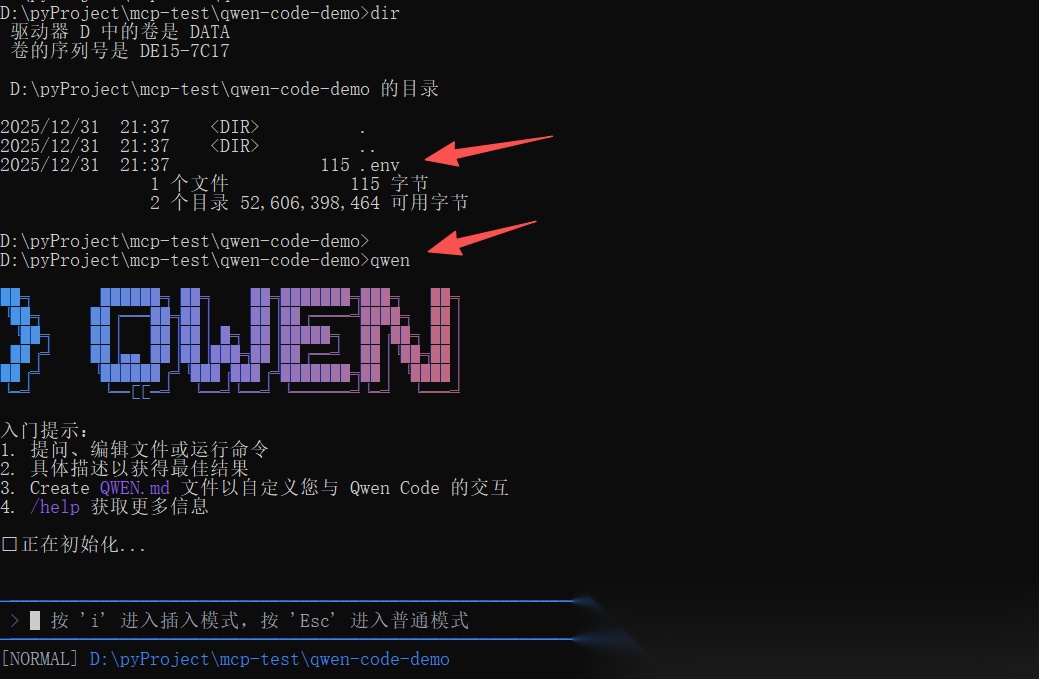

安装好后,可以输入 `qwen` 进入窗口:

配置上面部署的私有模型:

在项目目录下创建 `.env` 文件, 内容如下所示:

```plaintext

OPENAI_BASE_URL=http://127.0.0.1:8060/v1/OPENAI_API_KEY=token-abc123OPENAI_MODEL=Qwen3-Coder-30B-A3B-Instruct

然后在 .env 文件同级的目录下唤醒 qwen:

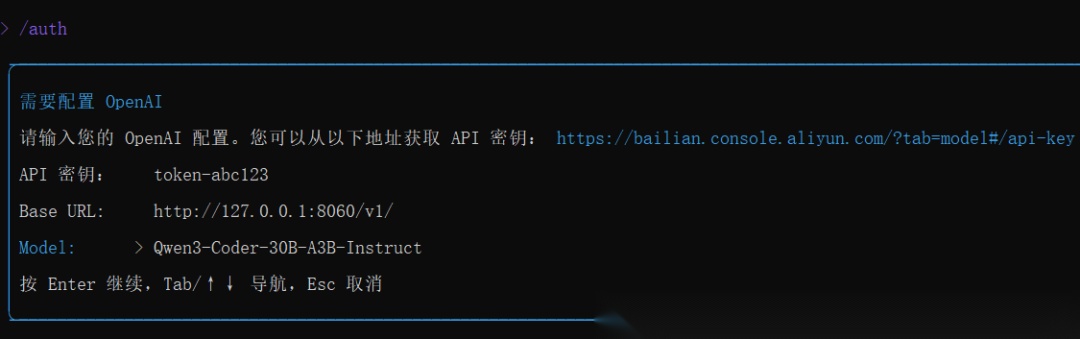

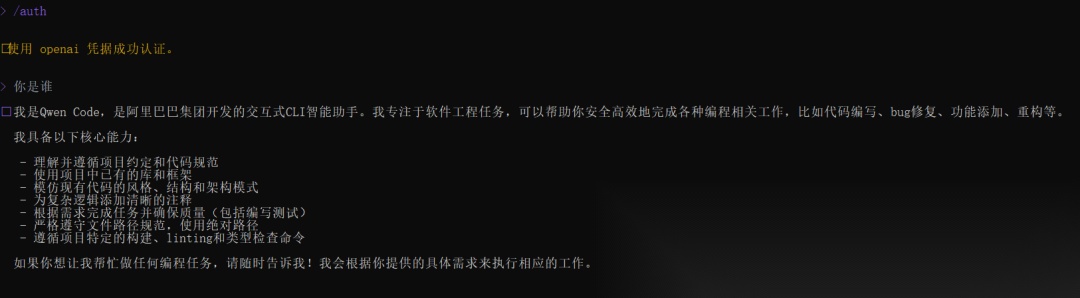

按 i 进入插入模式,然后输入 /auth 切换认证方式,选择 OpenAI ,确认信息后即配置成功:

四、 Vibe Coding 测试

这里简单测试下 Vibe Coding ,开发一个H5小游戏和一个前端页面。

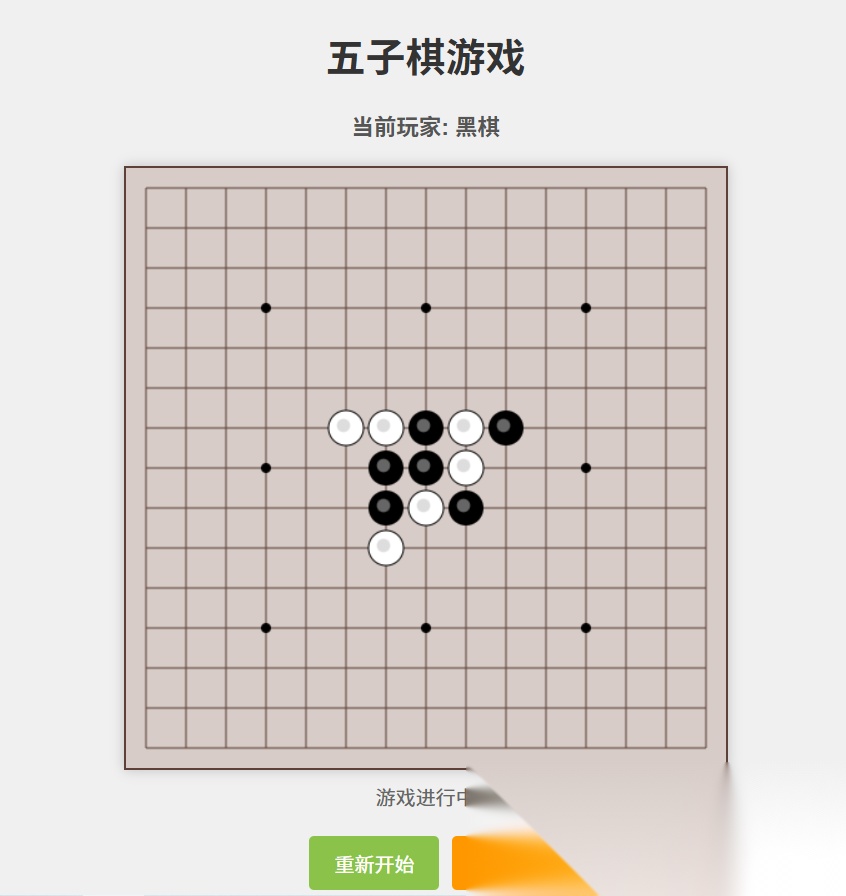

4.1 测试 h5 小游戏开发

输入指令:创建一个H5五子棋小游戏

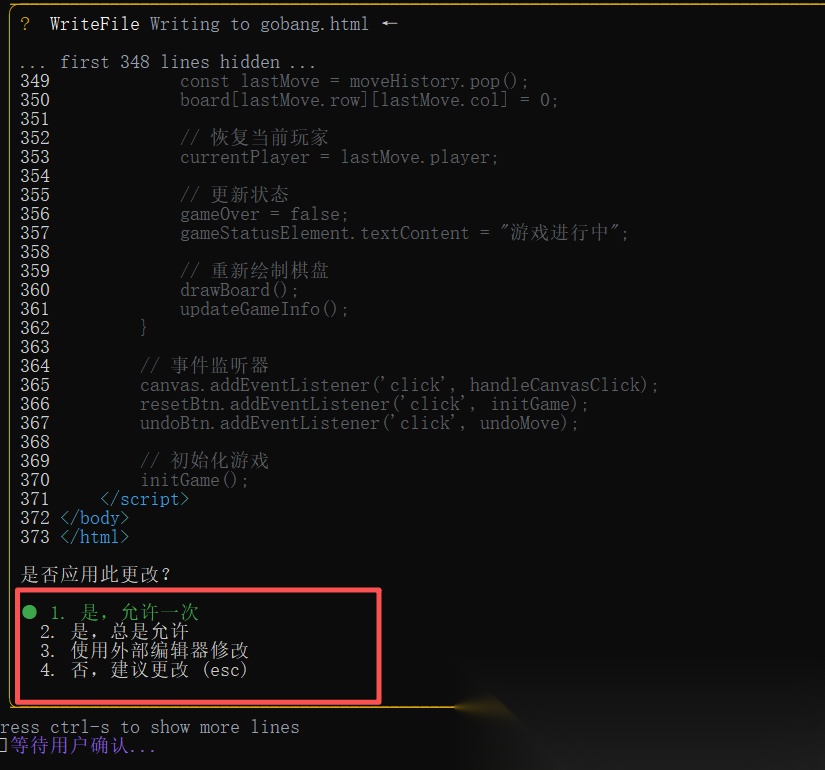

默认情况下,对文件的修改都要用户授权,这里可以先选择 是,总是允许:

最终运行使用效果:

4.2 测试 前端页面开发

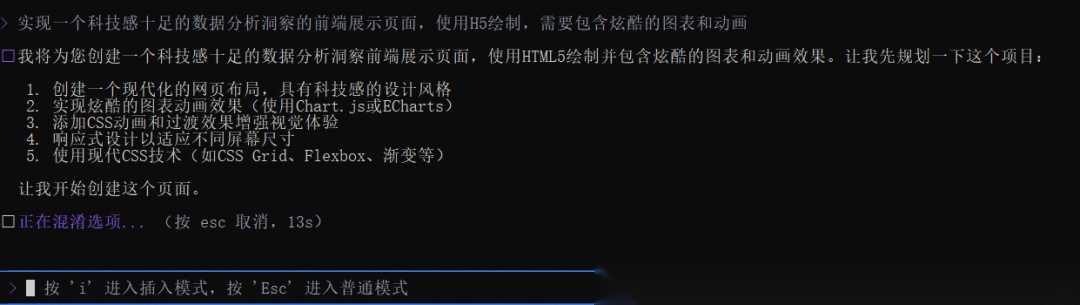

输入指令:实现一个科技感十足的数据分析洞察的前端展示页面,使用H5绘制,需要包含炫酷的图表和动画

最终运行使用效果:

CSDN独家福利

最后,感谢每一个认真阅读我文章的人,礼尚往来总是要有的,下面资料虽然不是什么很值钱的东西,如果你用得到的话可以直接拿走: