硬件-服务器-一种8U机架式液冷GPU服务器的硬件架构总览:从机箱布局到核心单板索引

引言:极致密度时代的硬件范式

在AI大模型训练与高性能计算领域,算力需求正以前所未有的速度增长。为在有限的数据中心空间和电力预算内提供最大算力,高密度、液冷、异构集成 已成为新一代GPU服务器的核心设计理念。一台标准的8U液冷GPU服务器,可在单机内集成多达8颗乃至更多的高功耗GPU,其硬件架构的复杂性与集成度远超传统服务器。

本文旨在提供一份清晰的“地图”,通过剖析其宏观物理布局与核心单板索引,系统性地理解这一复杂系统的构成与互连逻辑。掌握此总览,是深入分析任一子模块设计细节的前提。

8U机箱与整体布局

一台8U液冷服务器并非简单的部件堆叠,而是一个遵循严格热、电、信号设计规范的高度集成系统。其内部可划分为前、中、后三个功能区。

机箱分区纵览

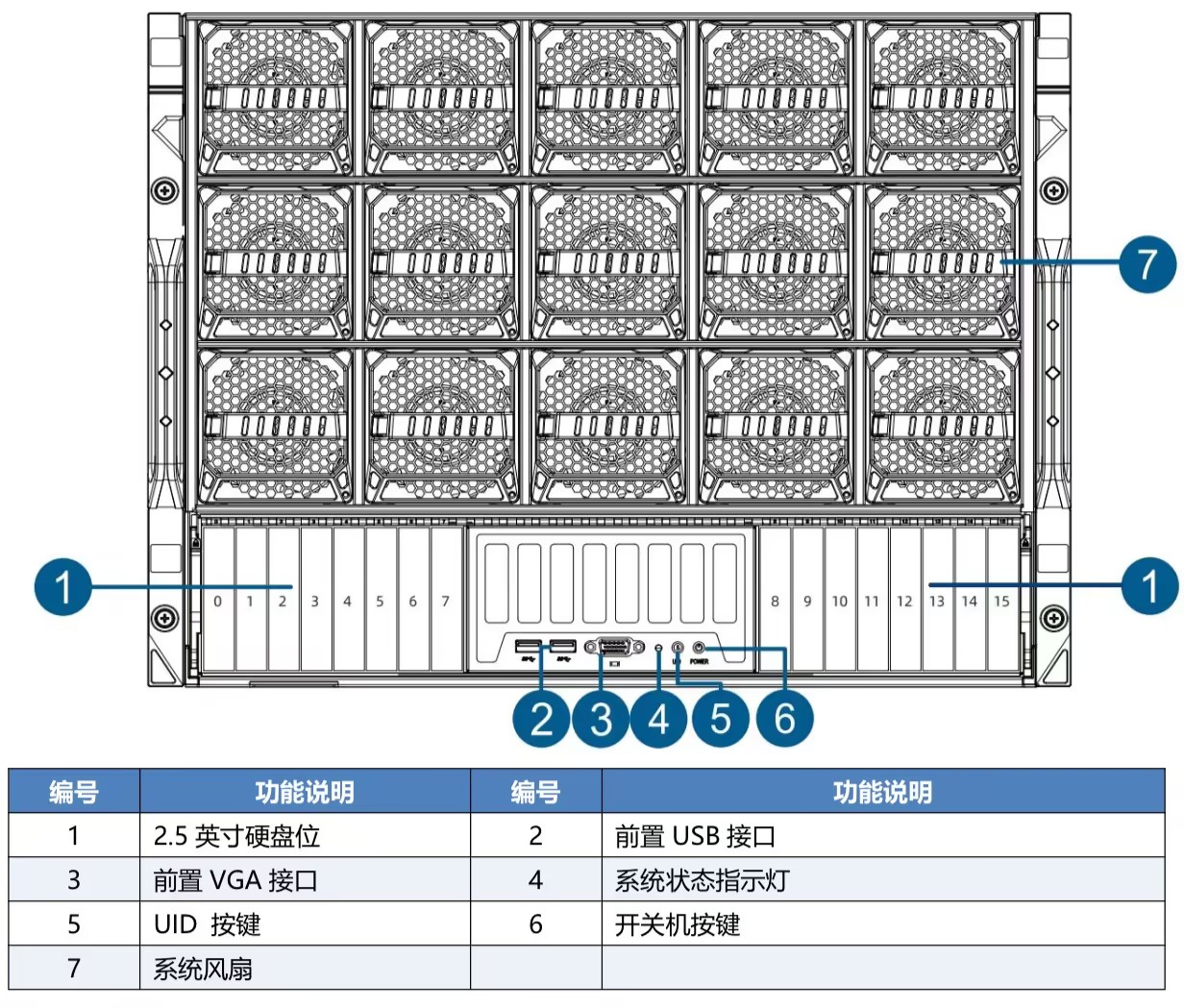

- 前部区域(存储与风扇接口):通常配备NVMe存储背板,支持热插拔NVMe SSD,提供高速本地存储。同时,作为系统的主要进风口,也为中部散热风墙提供冷空气通道。

- 中部区域(核心计算与混合散热区):作为系统的“热力核心”,此区域承载了最主要的计算与互连组件。关键单板(如UBB板、主板及PCIe Switch板)均安装于此,并通过中置背板实现互连。该背板同时集成高密度风扇墙,为未采用液冷的部件(如供电模块、Switch芯片及内存)提供精准的强制风冷。

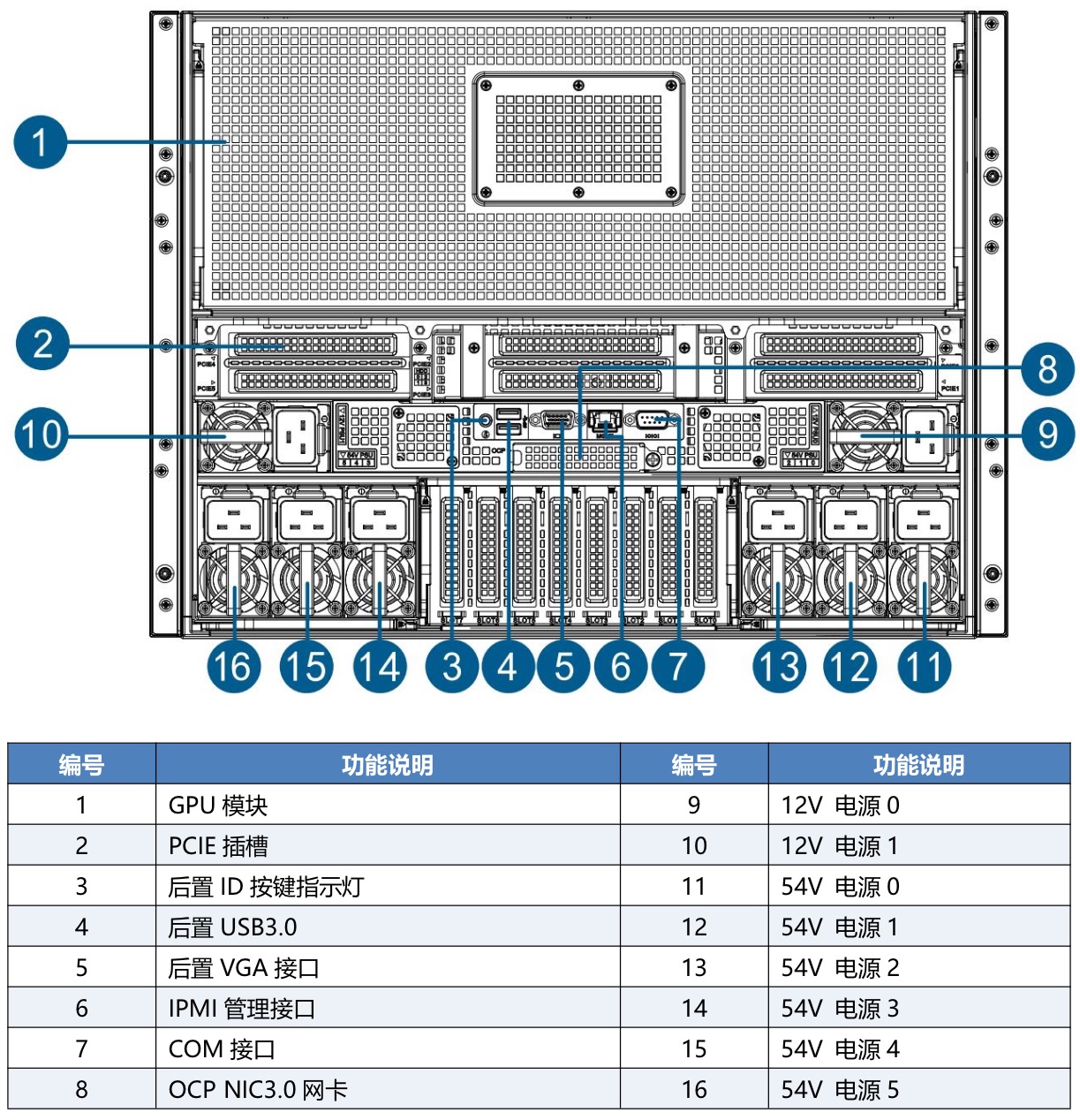

- 后部区域(供电、网络、管理与液冷接口):此区域是系统动力、数据交换及热量排出的核心枢纽。主要布局包括:冗余的54V/12V PSU供电模块;网络子系统(如OCP网卡板、4LP网卡转接板及GPU网卡);管理与扩展单元(各类Riser卡及BMC管理板)。此外,液冷系统的主管路快拆接头亦位于此,作为冷却液的集中出口。

(上图为一种 前面板 的示意图,摘自“TG988V3-产品手册”)

(上图为一种 后面板 的示意图,摘自“TG988V3-产品手册”)

核心结构示意图与互连关系(逻辑透视图)

上图为一种8U机架式液冷GPU服务器的主要核心组件的结构示意图,及主要的数据和控制链路的互联关系展示。其中,蓝色线条 为单板内的互联关系,红色线条 为线缆连接,绿色双箭头 为板对板对插。

注意:上图中 组件的比例及位置关系存在一些失真,仅大致示意供参考;省略了Retimer等中间器件,只展示主要的互联关系;未展示液冷所用的冷管和冷却路径。

核心单板与组件功能索引

以下按功能类别,对构成系统的关键“积木”进行简述。

计算与高速互连核心单板

- UBB板:通用基板,承载所有GPU模组。其核心功能包括:

- 供电网络:将高压直流电(如54V)分配并转换为GPU所需的各级电压。

- 信号互连:提供PCIe x16通道连接每个GPU,并物理上实现GPU间全互联或分组互联拓扑。

- 液冷集成:集成液冷管路接口,与GPU模组冷板紧密耦合。

- GPU模组:插在UBB板上的计算单元。包含GPU裸片、HBM显存、供电模块等,是热密度最高的部件。

(上图为UBB板及已安装的GPU模组示例)

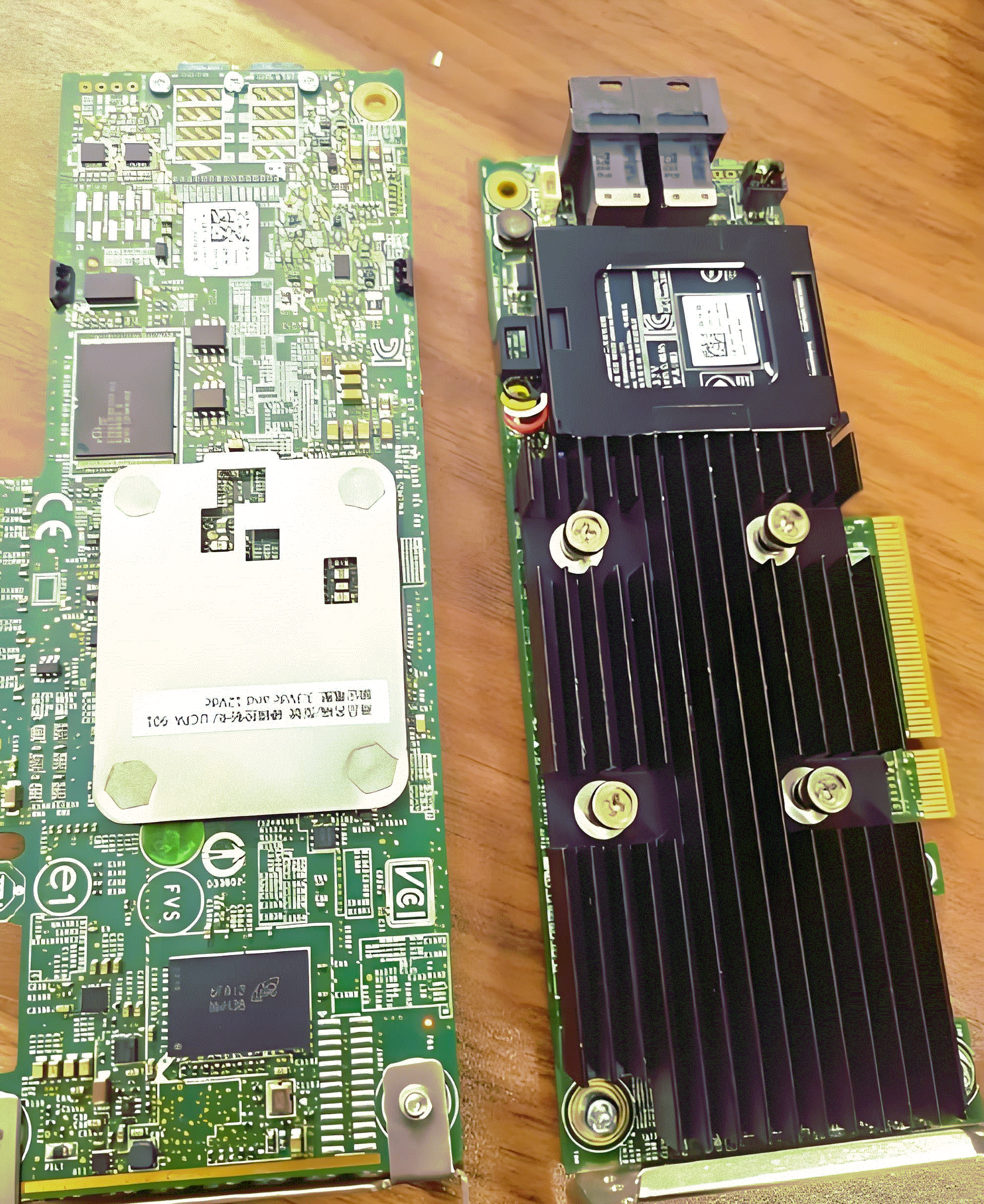

- PCIe Switch板:系统的数据十字路口。由于CPU的PCIe通道数有限,需通过此板载的多个PCIe Switch芯片,对通道进行扩展和交换,以同时连接大量GPU、网卡及存储控制器。另外,在此系统架构中,PCIe Switch板还负责将54V PSU的电源提供给UBB板。

(上图为PCIe Switch板示例)

- 主板:搭载CPU和内存的系统控制中心。负责初始化、管理整个系统,并通过专用接口与PCIe Switch板、UBB板协同工作。

(上图为主板示例)

网络、扩展与管理单板

- BMC管理板:独立或集成的基础板管理控制器模块(本文系统架构的应用为独立单板)。实现服务器的带外管理,监控温度、功耗、风扇、电源状态,并提供远程控制界面。

(上图为BMC管理板示例)

- OCP网卡板:符合OCP NIC 3.0规范的专用网卡。通常提供最高带宽如400GbE/800GbE,是服务器对上行交换机的核心数据门户。

(上图为OCP网卡板示例)

- PCIe转接板-4LP:支持4个Lower Profile尺寸网卡的PCIe转接板。位于后部,作为物理转接器,将PCIe Switch板输出的高速通道,转换为4个标准的Low Profile尺寸的PCIe插槽,用于安装多种网卡(如E810双端口100G/200G光口卡)。

(上图为PCIe转接板示例)

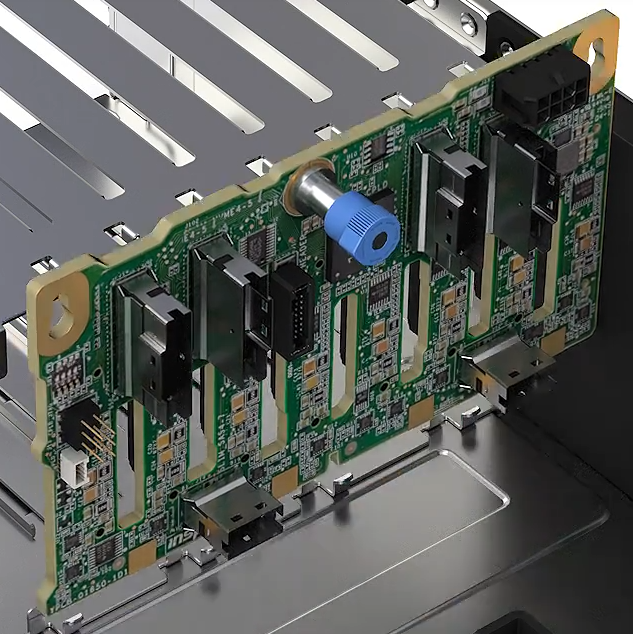

- Riser卡:用于在空间受限的后部区域,将主板或PCIe Switch板的PCIe接口进行转向和扩展,以安装各类功能卡。

(上图为已安装到支架上的Riser卡示例)

- 网卡:安装在4LP转接板或Riser卡上的标准PCIe网络适配器,可配备光模块(如QSFP-DD, SFP28)以实现光口连接。

(上图为已安装在Riser卡上的网卡示例)

- RAID卡:通过Riser卡安装,为连接8SFF背板上的NVMe SSD或SATA/SAS硬盘提供硬件RAID功能或直接连接能力。

(上图为RAID卡示例)

供电与配电单板

- PDB板:电源分配板。此系统架构中的核心功能是配电与信号中继。

- 接收来自54V PSU的直流电,并通过专用插座和线缆将其直接分配给耗电大户UBB板和PCIe Switch板。

- 同时,负责将PSU的I2C管理总线、电源指示(PG)信号、在位信号、使能信号等传递至PCIe Switch板及BMC管理板,实现智能电源管理。

(上图为PDB板示例)

- 54V / 12V PSU:冗余电源模块。54V PSU为主计算部件(GPU、Switch)供电,以减小电流、降低传输损耗;12V PSU则为传统主板、风扇、硬盘背板等供电。

(上图为PSU示例)

存储、散热与结构组件

- 8SFF NVMe存储背板:位于前部,支持8个热插拔2.5英寸NVMe SSD。通过背板转接板与主板或RAID卡的PCIe/SAS接口相连,提供极高带宽的本地存储。

(上图为8SFF存储背板示例)

- 背板转接板:连接8SFF背板与系统内部PCIe/SAS控制器的桥梁。

(上图为背板转接板示意图)

- 中置背板:承担着双重关键职能:

- 系统互连枢纽:作为PCIe Switch板、UBB板及背板转接板的核心连接平台,负责为这些关键组件提供电源与信号直连,确保电源、高速数据及控制信号的互通。

- 风扇接口:承载并连接所有系统风扇,提供统一的供电和控制接口。

(上图为中置背板示例)

- 左/右挂耳: 智能机箱面板。通常集成了系统状态指示灯、ID按钮、管理网口、USB调试口等,是物理运维的主要接口。

(上图为左/右挂耳示例)

总结与展望

通过以上总览,可以清晰地看到,一台现代8U液冷GPU服务器是一个多层次、模块化的精密系统。其设计精髓在于:

- 解耦与集成:将计算(UBB+GPU)、网络(PCIe Switch+网卡)、供电(PDB+PSU)、管理(BMC)等模块解耦设计,再通过高速连接器和标准接口高度集成。

- 能效优先:采用液冷处理主要热源,配合精准的分区强制风冷,实现最佳的散热能效比。

- 信号与电源完整性为核心:应对PCIe等超高速信号以及千瓦级瞬态功率的挑战,是单板设计的重中之重。

展望未来,架构将持续向更高性能、更低能耗和更强扩展性演进:

- 多元异构计算:除GPU外,将更广泛集成ASIC、FPGA乃至CIPU等专用加速单元,形成协同、高效的多元算力体系。

- 光电混合互连:在机箱背板乃至芯片封装内引入硅光技术,利用光互连突破电气互连在带宽、功耗和距离上的根本性瓶颈。

- 散热范式革新:从当前的冷板式液冷,向单相乃至相变浸没式液冷演进,迈向极致能效与器件密度。

- 开放标准化加速:OCP、ODCC等开放社区标准将更深度地定义GPU模组、液冷接口与管理规范,驱动全行业互操作性提升与生态成熟。