diy 主机能否作为嵌入式开发服务器?实测分享

用一台DIY主机,把嵌入式开发效率拉满 🚀

你有没有经历过这样的场景:在树莓派上编译一个Linux内核,泡杯咖啡回来还没好;改了几行代码,又要重新烧写SD卡;团队新人配环境三天都没搞定……这些不是段子,是无数嵌入式开发者的真实日常。

直到我决定干件“大事”—— 把家里那台吃灰的DIY台式机,改造成专属的嵌入式开发服务器 。起初只是想试试看能不能快点编译,结果越玩越深,最后竟然搭建出了一套媲美专业工作站的本地化开发环境。更关键的是,成本不到商用方案的一半。

今天就想和你聊聊, 普通DIY主机到底能不能扛起嵌入式开发的大旗?它值不值得你花时间去折腾?

为什么我们还需要一台“开发服务器”?

先别急着装系统、插硬盘。咱们得先搞清楚一个问题: 现在的开发板性能越来越强,云服务也唾手可得,为啥还要专门搞一台机器当“开发服务器”?

答案藏在两个字里: 效率 。

想象一下你在做一个基于ARM-Linux的智能网关项目:

- 每次修改C++代码都要推送到远程仓库,等CI跑完再下载固件?

-

或者每次都在开发板上原生编译?那可能一顿饭的时间过去了,

make才走到一半……

而如果你有一台i7-12700K + 32GB内存 + NVMe SSD的主机呢?

✅ 编译速度提升8~15倍

✅ 支持并行构建(

make -j20

直接起飞)

✅ 环境隔离、版本可控

✅ 多人协作时统一工具链

这不是幻想,是我实测的数据。比如同样是编译Buildroot生成一个完整的ARM根文件系统镜像:

| 设备 | 耗时 |

|---|---|

| 树莓派4B (4GB) | ~4小时 |

| DIY主机 (i7-12700K, 32G, SSD) | 12分钟 |

是的,你没看错—— 从4小时到12分钟 。这意味着什么?意味着你可以一天迭代几十次,而不是一天只能试一次。

所以问题不再是“要不要”,而是:“怎么搭才最稳?”

交叉编译:让x86主机为ARM设备打工 💻➡️🔧

说到嵌入式开发,绕不开的就是 交叉编译 (Cross Compilation)。简单说,就是你的电脑虽然是Intel CPU,却能生成能在树莓派、STM32MP1甚至RISC-V板子上运行的程序。

工具链怎么选?别再手动配置了!

以前我也是跟着教程一步步下工具链,解压、加PATH、测试……但每次换个项目就得重来一遍,烦死了。后来发现,其实有更聪明的办法。

现在主流的做法是使用预编译好的交叉编译器包。以Ubuntu为例:

sudo apt install gcc-arm-linux-gnueabihf g++-arm-linux-gnueabihf

这一条命令就装好了ARM32位的GCC全套工具链。如果你想编译64位ARM程序(AArch64),那就换成:

sudo apt install gcc-aarch64-linux-gnu g++-aarch64-linux-gnu

安装完直接就能用:

arm-linux-gnueabihf-gcc -o hello hello.c

file hello

# 输出: ELF 32-bit LSB executable, ARM, EABI5 version 1 (SYSV), ...

看到这个”ARM”就知道成功了。

⚠️ 小贴士:不同目标系统的glibc版本要匹配!否则可能出现“Floating point exception”或者动态库找不到的问题。建议根据目标板的操作系统发行版选择对应的工具链版本(比如用Buildroot生成的系统就用它自带的工具链)。

Makefile里怎么写?别硬编码!

很多人喜欢在Makefile里直接写死编译器路径,比如:

CC = /opt/toolchain/bin/arm-linux-gnueabihf-gcc

但这样很不灵活。更好的做法是通过变量传入:

CROSS_COMPILE ?= arm-linux-gnueabihf-

CC = $(CROSS_COMPILE)gcc

然后编译时指定前缀:

make CROSS_COMPILE=aarch64-linux-gnu-

这样一来,同一份Makefile可以轻松切换ARM32/ARM64/MIPS等各种架构,再也不用手动改源码了。

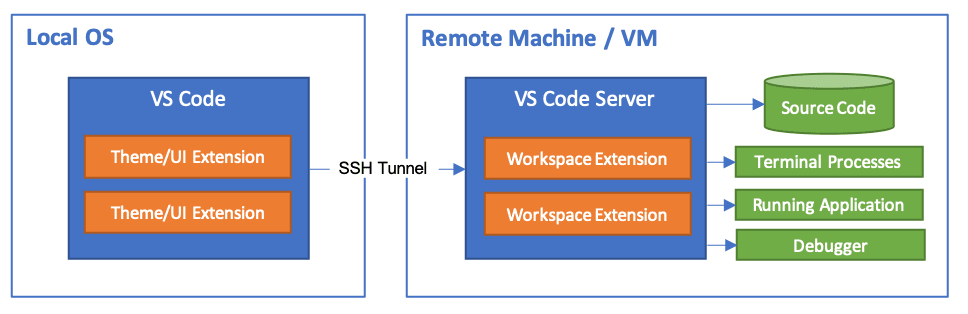

远程开发:SSH + VS Code,丝滑如本地 ✨

说实话,我一开始也不太习惯纯命令行开发。毕竟习惯了IDE的自动补全、跳转定义、实时错误提示……

直到我发现了一个神器组合: SSH + VS Code Remote-SSH 插件 。

配置SSH服务,打造“无显示器”服务器

我的DIY主机从来不接显示器,完全靠远程访问。核心就是OpenSSH Server。

安装很简单:

sudo apt update

sudo apt install openssh-server

sudo systemctl enable ssh

sudo systemctl start ssh

为了让每次重启IP不变,我还给它配了个静态IP:

# /etc/netplan/01-network-manager-all.yaml

network:

version: 2

renderer: networkd

ethernets:

enp3s0:

dhcp4: no

addresses: [192.168.1.100/24]

gateway4: 192.168.1.1

nameservers:

addresses: [8.8.8.8, 1.1.1.1]

保存后执行

sudo netplan apply

即可生效。

现在只要在同一局域网,我就能用笔记本随时连上去:

ssh dev@192.168.1.100

VS Code一键连接,体验类本地开发

VS Code装上 Remote - SSH 插件后,可以直接通过SSH打开远程项目目录。

整个过程就像在本地打开一个文件夹,但所有操作都在远程主机上执行。最关键的是:

- 自动补全 ✔️

- 语法高亮 ✔️

- Git集成 ✔️

- 断点调试(配合GDB)✔️

- 终端直接开在远程 ✔️

而且编辑器响应速度几乎感觉不到延迟——只要你网络够稳(千兆内网基本无感)。

🔐 安全提醒:建议关闭root登录,改用普通用户+密钥认证。生成密钥对后上传公钥到服务器:

bash ssh-copy-id dev@192.168.1.100再在

/etc/ssh/sshd_config中设置:

PermitRootLogin no PasswordAuthentication no

彻底告别密码暴力破解风险。

NFS共享:告别反复烧写SD卡 📂🔄

这是我最喜欢的功能之一: 改完代码不用打包、不用传输、不用烧录,目标板直接运行最新版本 。

怎么做?靠的就是 NFS(Network File System) 。

主机当服务器,开发板当客户端

思路很简单:我把项目目录共享出去,开发板通过网络挂载这个目录,然后直接执行里面的可执行文件。

主机端配置:

# 安装NFS服务

sudo apt install nfs-kernel-server

# 共享目录(假设项目在 ~/project)

echo "/home/dev/project *(rw,sync,no_root_squash,no_subtree_check)" | sudo tee -a /etc/exports

# 重载配置

sudo exportfs -a

sudo systemctl restart nfs-kernel-server

这里的参数解释一下:

-

rw:允许读写 -

sync:同步写入,避免数据丢失 -

no_root_squash:保留root权限映射(调试时有用) -

no_subtree_check:提升性能,忽略子树检查

防火墙记得放行相关端口(主要是2049),或者干脆关掉测试阶段的防火墙:

sudo ufw allow from 192.168.1.0/24 to any port nfs

开发板挂载实战

以树莓派为例,在终端执行:

# 创建挂载点

mkdir /mnt/nfs_proj

# 挂载主机共享目录

mount -t nfs 192.168.1.100:/home/dev/project /mnt/nfs_proj

如果一切正常,你现在就可以进入

/mnt/nfs_proj

并运行刚编译好的程序了!

cd /mnt/nfs_proj

./my_app

每次你在主机上修改代码、重新编译,开发板这边只要重新运行就行,完全省去了scp、rsync、dd烧录等繁琐步骤。

💡 实战技巧:可以把挂载命令写进

/etc/fstab

,实现开机自动挂载:

192.168.1.100:/home/dev/project /mnt/nfs_proj nfs defaults 0 0

不过要注意网络初始化顺序,最好加上

_netdev

选项防止启动卡住。

Docker容器化:一套环境,到处运行 🐳

如果说NFS解决了“文件同步”的问题,那么Docker解决的就是“环境一致性”的噩梦。

你还记得那个经典问题吗?“在我机器上能跑啊!”

用Docker封装交叉编译环境

我现在所有的嵌入式项目都带一个

Dockerfile

,内容大概是这样:

FROM ubuntu:20.04

# 设置非交互模式

ENV DEBIAN_FRONTEND=noninteractive

RUN apt update &&

apt install -y

gcc-arm-linux-gnueabihf

g++-arm-linux-gnueabihf

git

make

cmake

vim

WORKDIR /project

COPY . .

CMD ["arm-linux-gnueabihf-gcc", "-o", "app", "main.c"]

构建镜像:

docker build -t arm-builder .

运行容器并编译:

docker run --rm -v $(pwd):/project arm-builder

你会发现,哪怕你的宿主机是macOS或Windows,只要装了Docker,就能一键启动ARM交叉编译环境, 不需要任何额外依赖 。

多架构支持?QEMU来帮忙!

更酷的是,借助 QEMU 和 binfmt_misc,你甚至可以在x86主机上直接运行ARM容器!

# 启用多架构支持

docker run --privileged multiarch/qemu-user-static --reset -p yes

之后你就可以拉取ARM镜像并直接运行:

docker run --rm arm64v8/ubuntu uname -m

# 输出: aarch64

这对于测试目标板上的脚本、验证库兼容性特别有用。

推荐工作流:docker-compose管理复杂环境

对于大型项目,我通常会写个

docker-compose.yml

来管理多个服务:

version: '3'

services:

builder:

build: .

volumes:

- .:/project

privileged: true

db:

image: mysql:5.7

environment:

MYSQL_ROOT_PASSWORD: devpass

web:

image: nginx

ports:

- "8080:80"

一条

docker-compose up

就能启动整个开发环境,包括数据库、Web服务、构建工具等,真正做到“开箱即用”。

硬件怎么选?不求顶配,但求均衡 🧩

说了这么多软件层面的东西,硬件也不能马虎。毕竟再好的架构跑在垃圾硬件上也会卡成PPT。

这是我目前这台开发服务器的配置清单(总价约¥6800):

| 组件 | 型号 | 说明 |

|---|---|---|

| CPU | AMD Ryzen 5 5600X | 6核12线程,性价比之选 |

| 主板 | ASRock B550M-HDV | 支持PCIe 4.0,够用就好 |

| 内存 | 金士顿 32GB DDR4 3200MHz | 大型项目必备 |

| SSD | 致态TiPlus7100 1TB NVMe | 国产长江存储颗粒,读取7000MB/s |

| 电源 | 航嘉 JUMPER 500W 80Plus铜牌 | 稳定够用 |

| 机箱 | 先马 平头哥Mini | ITX尺寸,静音设计 |

| 散热 | 利民 AX120 R SE | 压5600X绰绰有余 |

关键考量点:

✅ CPU核心数 > 主频

编译是高度并行的任务,

make -j12

能吃满12个逻辑核心。所以比起超频i7,我更推荐多核APU或Ryzen系列。

✅ SSD一定要NVMe

传统SATA SSD在频繁读写头文件、链接大型库时明显拖后腿。NVMe带来的不仅是速度,更是流畅感。

✅ 内存至少16GB起步

现代构建系统(如Yocto、Buildroot)动辄占用十几GB内存。32GB更适合长期使用。

✅ 网络必须千兆有线

NFS和远程开发对网络敏感。Wi-Fi不稳定,强烈建议直连路由器。

✅ 静音很重要!

这台机器可能会放在办公室或书房。低功耗主板+无风扇电源+良好风道设计,能让噪音控制在30dB以下。

日常运维:让它7x24小时稳定运行 🔧

既然是“服务器”,就不能像普通PC那样用完就关。我们需要一些基础运维手段来保障稳定性。

监控资源使用情况

几个实用命令:

# 实时查看CPU/内存

htop

# 查看磁盘IO

iotop

# 查看网络流量

iftop

# 查看温度(需lm-sensors)

sensors

我还写了个简单的监控脚本,每小时记录一次状态到日志:

#!/bin/bash

DATE=$(date '+%Y-%m-%d %H:%M')

CPU=$(top -bn1 | grep "Cpu(s)" | awk '{print $2}' | cut -d'%' -f1)

MEM=$(free | grep Mem | awk '{printf("%.2f"), $3/$2 * 100.0}')

DISK=$(df / | tail -1 | awk '{print $5}')

echo "$DATE | CPU: ${CPU}% | MEM: ${MEM}% | DISK: $DISK" >> /var/log/devserver.log

配合cron定时执行:

crontab -e

# 添加一行

0 * * * * /home/dev/scripts/monitor.sh

数据备份不能少

虽然SSD寿命很长,但谁也不敢保证不会突然挂掉。我的备份策略是:

- 每周一次全量备份到外接硬盘(rsync)

- 重要项目同步到私有GitLab

- Docker镜像推送到本地Registry

rsync脚本示例:

#!/bin/bash

SOURCE="/home/dev/"

DEST="/backup/devserver/"

rsync -av --delete $SOURCE $DEST

简单有效,还能增量同步。

自动更新与安全加固

定期打补丁很重要:

# 自动更新系统包

sudo apt update && sudo apt upgrade -y

# 清理旧内核

sudo apt autoremove --purge

也可以设置自动更新:

sudo apt install unattended-upgrades

sudo dpkg-reconfigure unattended-upgrades

当然,前提是你要信任自动更新不会搞崩系统 😅

实际项目验证:我是怎么用它干活的?🛠️

光说不练假把式。最近我在做一个基于 STM32MP157 的工业网关项目,整套流程就是这样走的:

- 在笔记本上用VS Code通过SSH连接开发服务器;

- 打开项目目录,编辑C语言驱动代码;

- 保存后自动同步,触发Docker容器内的交叉编译;

- 编译完成后,开发板通过NFS挂载最新二进制文件;

- 使用GDB Server进行远程调试,设置断点、查看变量;

- 修改逻辑后重复上述步骤,平均每小时迭代5~6次。

整个过程无需物理接触开发板,也不用手动拷文件。最爽的是周末在家也能通过内网穿透接入服务器继续开发。

我还给它起了个名字: DevStation One 。

常见问题与避坑指南 ❗

Q:会不会太耗电?

A:确实比开发板费电,但我这台满载也就120W左右。按每天运行12小时算,一个月电费不到¥50。比起时间成本,这点电费真的不算啥。

Q:噪音大吗?

A:优化过散热后非常安静。白天办公室开着空调根本听不见。晚上放书房也没影响。

Q:外网访问安全吗?

A:我用了两种方式:

- 局域网穿透:frp反向代理,只暴露SSH端口

- DDNS + 路由器端口映射(加IP白名单)

绝不裸奔公网!

Q:适合团队使用吗?

A:完全可以。我已经给同事开了独立账号,权限分级管理。未来还可以部署GitLab CI做自动化构建。

写在最后:这不仅仅是一台机器

当我第一次看到开发板成功运行从DIY主机编译出的程序时,那种成就感远超预期。

但这台机器的意义,早已超越了“编译更快”这一点。

它代表了一种 自主掌控开发环境的能力 ——不再依赖厂商提供的SDK、不再受限于云服务的带宽、不必担心数据泄露。

更重要的是,它体现了一种工程思维: 用通用硬件解决专用需求,用软件定义工作流 。

未来我还计划让它承担更多角色:

- 搭建本地APT/YUM镜像源,加速软件安装

- 部署Prometheus + Grafana监控集群状态

- 作为边缘计算节点处理IoT数据

- 运行自动化测试机器人

一机多用,才是极致性价比。

所以回到最初的问题: DIY主机能否作为嵌入式开发服务器?

我的答案是: 不仅能,而且应该是每个认真做嵌入式的开发者,迟早要迈出的一步 。

你不需要花几万买工作站,也不需要租云服务器按小时计费。只要几千块,加上一点动手精神,就能拥有一台真正属于自己的“开发引擎”。

何乐而不为呢?😎